Bezpłatny fragment - ezoFizyka

Koniec epoki Determinizmu, powrót do Duchowego

…

Bądź Pozdrowiony, o Boże, Panie Ziemi i Sfer Niebieskich.

Niech cała przyroda i natura chyli głowę przed Twym Majestatem

Ja, nędzny robak, wielbię Twoją Wielkość, korzę się przed Twym

Obliczem …

Modlitwa Maga Uberyka do Boga (frag.), znaleziona na tabliczkach glinianych zapisanych pismem klinowym w okolicach południowego Iraku. Szacunkowa data powstania: późny Sumer

Ogólne

Postęp techniczny przez ostatnie sto lat jest wręcz progresywny. Jesteśmy wręcz ogłuszeni wynalazkami, których z każdym dniem przybywa, które z każdym dniem ułatwiają nam nasze życie codzienne. Bez elektroniki, bez komputerów, Internetu już nikt nie wyobraża sobie naszej codzienności. Lecz przecież jeszcze kilkadziesiąt lat wstecz sytuacja pod tym względem była zgoła odmienna. Ludzie musieli wydzierać życiu przynajmniej okruchy tych luksusów, które dziś są powszechne. Światło (prąd), ogólnie: industrializacja, higiena, pożywienie a nawet rozrywka dziś a kiedyś, to tak jakby porównywać ogień z wodą. Te warunki są oczywiście całkowicie odmienne. Być może, a nawet na pewno, te zdobycze cywilizacyjne nie są dane nam raz na zawsze, ale póki co korzystamy z nich pełną garścią. Zdobycze techniczne oddalają nas jednak od pewnych wartości, wartości niematerialnych, które jednak w tych gorszych dla techniki, dla luksusu życia, latach przeszłych były dość powszechne. Ośmielę się stwierdzić, że dla niektórych ludzi, tym bardziej szczególnie tych młodszych, dzisiaj bogiem jest technika, komputery coraz bardziej doskonałe, biotechnologia, postęp i wynalazki techniczne, a mało ważne są wartości czysto duchowe. Chyba właśnie dlatego tak się dzieje, bo cywilizacja techniczna zdławiła w sobie pierwiastki duchowe. Nauka, choć już od stu lat ogólnie znana jest mechanika kwantowa, w dalszym ciągu jest pod wpływem Deterministycznego paradygmatu, który zrodził się u progu powstania zrębów nowoczesnej wiedzy. Tak, to prawda, to było konieczne. To był konieczny krok, ten cały Determinizm, Mechanicyzm i Racjonalizm w rozwoju człowieka jako gatunku. Ci, którzy stworzyli podwaliny nauki, Cześć im i chwała, giganci typu Newtona, Leibniza, Laplace czy Legranda i wielu, wielu jeszcze innych, których nie sposób tu przytoczyć. Ci wszyscy oni zrobili wiele pożytecznej pracy, której ludzkość nie może zatracić, którą my, ich potomkowie, musimy doceniać i pielęgnować. Ale! Istnieje jednak pewne “ale”. To “ale”, to takie samo “ale”, jakie każdy astronom kieruje do koncepcji Ptolemeusza i jego pojmowania kosmosu. Niby zgadza się ono dość dobrze z rzeczywistością, można dość dobrze obliczyć wiele zjawisk Układu Słonecznego, ale jednak wiadomo, że nie jest to do końca prawidłowe. Dzisiaj wiemy, sytuacja z nauką i paradygmatami Oświecenia jest właśnie adekwatna do tego przykładu. Oczywiście, kto wie, ten wie, ale na uczelniach przykładowo powszechnie uczy się jeszcze Deterministycznego Paradygmatu. Przyznałem, że był to konieczny krok. Pełna racja. Sytuacja poprzedzająca naukowe pojmowanie rzeczywistości (Determinizm, Mechanicyzm, Racjonalizm) była przecież katastrofalna. W epoce Średniowiecza panował dominujący zabobon, kołtuństwo i analfabetyzm. Dlatego Oświeceniowe nowości były niczym łyk ozdrowieńczej wody. Ludzie poznając Determinizm i Racjonalizm nabierali większego szacunku dla logiki i rozumu ludzkiego. Okazało się, że poprzez redukcjonizm i logikę, i prawa przyrody można wiele rzeczy wytłumaczyć, bez odwoływania się do boskiej interwencji. To można porównać jedynie chyba z wynalezieniem ognia jako narzędzia użytecznego ludzkim społecznościom. W tym też kierunku rozwijała się nauka aż praktycznie do schyłku dziewiętnastego wieku, kiedy to czołowi fizycy (Kelvin na przykład) ogłosili światu koniec fizyki i zaranie inżynierii, przyjmując przy tym, że pozostało jedynie kilka, jak się wydaje, mało znaczących kwestii w fizyce nie do końca wyjaśnionych, na przykład katastrofa w nadfiolecie w problemie promieniowania ciała doskonale czarnego, z którymi fizyka jeszcze się boryka, ale to kwestia dni, miesięcy, gdy wszystkie one zostaną rozwiązane. Jak dziś wiemy, te kilka mało znaczących problemów urosły do rangi teorii, które całkowicie zmieniły obraz fizyki dwudziestowiecznej. Teorii, które powinny zwiastować koniec tych już teraz starych naukowych paradygmatów. Jednakże agonia Determinizmu, Racjonalizmu i Mechanicyzmu przedłuża się w sposób dramatyczny. Przedłuża się właśnie z powodu ich wielkiej użyteczności dla nauki i dla ludzkości, przynajmniej tej przeszłej użyteczności. Tak jakby ludzie nie chcieli się z nimi pożegnać, tak jak dziecko nie chce się pożegnać ze swoimi zepsutymi zabawkami, a one teraz same stały się de facto synonimem zacofania. Tak silna jest ta bezwładność, inercja intelektualna, że nie chce puścić już tego, co staje się pomału zawadą w dalszej drodze i rozwoju cywilizacji człowieka. Tak mnogo jest przecież przykładów w fizyce rozwiązanych w sposób zadowalający, wydawałoby się, przez te stare koncepcje. Teraz, wychodząc jednak niemal przed szereg, mogę stwierdzić, że te stare koncepcje rozwiązywały i rozwiązują jedynie problemy fizyczne z punktu widzenia mierzalnej rzeczywistości. I, okazuje się, nie jest to najdokładniejsze sformułowanie tych problemów.

Nim przejdę do właściwego meritum tej publikacji, pragnę jednak jeszcze raz podkreślić, że właściwie twórcy oświeceniowej fizyki nie mieli innego wyjścia. I z tego punktu widzenia należy się im wielkie podziękowanie i wielkie uznanie. Bo to była, jak gdyby, faza przejściowa, acz konieczna, niczym choroby wieku dziecięcego. Tak jak trudno od ucznia szkoły podstawowej wymagać, by zajął się i rozwiązywał równania różniczkowe, tak trudno od twórców nowoczesnej nauki oczekiwać, tych twórców z wieku XVII i później aż do początku XX wieku, by od razu ogarnęli całość fizyki czy nauk przyrodniczych. Oczywiście, to były kroki, czasami większe, czasami mniejsze, ale jednak zawsze naprzód. Jak pamiętamy, zaczęło się od zrzucenia Boga z piedestału nauki, co uczynił Kopernik swoją publikacją “O obrotach Sfer Niebieskich”, później zaś konsekwentnie i transparentnie w nauce obowiązywała zasada niemieszania tego co Duchowe z naukowością. Ba! Można nawet powiedzieć, że w nauce od Kopernika bardziej łaskawym okiem traktowano wszelkie próby ateistycznego wyjaśniania zjawisk. To na pewno było całkiem dobre, bardzo dobre, przynajmniej na tym etapie rozwoju nauki. Ale, tak jak prawie zawsze w każdej dziedzinie życia obowiązuje tu zasada wahadła, które oscyluje między swoimi antypodami. Według mojej oceny, to od momentu po odkryciu formalizmu Hamiltona w mechanice klasycznej, wahadło nauki zaczęło iść w niedobrym kierunku, tak że właściwie do dzisiaj ono jeszcze nie przestało się odchylać negatywnie. Dzieje się tak zawsze i trudno tu narzekać, ale dla mnie na przykład to panoszenie się powszechnego paradygmatu Determinizmu, Mechanicyzmu i Racjonalizmu jest już mocno przeterminowane i nie do przyjęcia. Jak już jednak to podkreślałem, nauka, a właściwie naukowcy szli i nadal w dużej mierze idą na ślepo. Jednak ich odkrycia odsłaniają i rozświetlają stopniowo kolejne etapy. Co ciekawe, jak by nie oceniać naukowców i wizjonerów nauki, to jednak ich postawa ma ogromne znaczenie dla reszty śmiertelników. Naukowcy bowiem rozgłaszają obowiązujące paradygmaty i budują zaplecze techniczne danej cywilizacji. Z tego punktu widzenia Oświeceniowe paradygmaty Determinizmu, Racjonalizmu, itd.., wielce zaszkodziły naszym przodkom, szczególnie tu w Europie. Śmiem twierdzić, że właśnie z tej postawy w dużej mierze wyniknęły straszliwe wojny światowe, które pochłonęły mnóstwo ofiar. Gdyby nie to tak namolne odcinanie się nauki od wszystkiego co ma jakiś posmak duchowego, być może losy ludzkości nie potoczyłyby się tak dramatycznie. Ja nie twierdzę, że wszędzie panował ateizm i odwrócono się powszechnie od Boga. Przecież budowano nowe kościoły, kultywowano wiarę i głoszono Ewangelię. Lecz jednak ludzie wykształceni w większości nie utożsamiali się z tym, najwyżej traktowali to jako rodzaj tradycji, o której nie można zapominać. Tak jak nie zapomina się nawet w kręgach neutralnych wyznaniowo o kolacji Wigilijnej czy podobnych świętach różnych wyznań. Wspominałem, że rolę boga przejął postęp techniczny, wynalazki i stopniowy wzrost stopy życiowej. Naczelnym hasłem nauki stało się to, że zjawiska fizyczne można wyjaśnić bez odwoływania się do Boga. Dość szybko zorientowano się, że wszelkie prawa przyrody, ja tu dodam, że prawa przyrody poziomu rzeczywistości Mierzalnej, mają charakter deterministyczny, dotyczy to szczególnie mechaniki klasycznej, która jest niejako jądrem fizyki, ponieważ są one wyrażone przez odpowiednie równania różniczkowe. Dziwne jest jednak to, że dość pobieżnie i nieuważnie traktowano cały czas samo Prawo Przyczynowo — skutkowe, które dość pobieżnie uważano za równoznaczne z Determinizmem. Notabene i dziś tak naprawdę nie zmieniło się to, choć przecież mówi się w kontekście mechaniki kwantowej o Indeterminizmie. I choć był przecież David Hume i był Leibniz. I było słynne stwierdzenie Huma, iż “Determinizm nie jest konieczny”, i było słynne sformułowanie Leibniza iż istnieje “Racja konieczna” zjawisk fizycznych. Ale żaden filozof chyba tak na poważnie nie przysiadł nad tym prawem, potocznie zwanym Przyczynowością. Być może było tak dlatego, iż ci dwoje i im podobni wizjonerzy urodzili się jednak trochę za wcześnie i dopiero po sformułowaniu mechaniki kwantowej nastała odpowiednia pora na nowe w tej kwestii. Ale wróćmy do Huma. Co on wyraził, wypowiadając: Determinizm nie jest konieczny? Otóż w formalizmie logiki można by to tak sformułować: (Prawo Przyczynowości) ≠> (Determinizm). Czyli innymi słowy, Determinizm nie jest konieczny i nie obowiązuje. Zresztą Hume przedstawił kilka przykładów na rzecz tej tezy. Między innymi taki przykład, iż z tego, że dziś rano wzeszło Słońce nie świadczy to, że jutro stanie się tak ponownie. Czyli, że dzisiejszy dzień nie determinuje jutrzejszy. Ale, dobrze, dobrze… abyśmy się nie pogubili, zastanówmy się jak w tych czasach rozumiano Determinizm, a jak dziś się go rozumie.

Sprawa jest dość jasna i na ten temat wypowiedział się już w starożytności Arystoteles. Mówi on: przyczyny są już wystarczające dla konkretnych skutków. To sformułowanie Arystotelesa w epoce Oświecenia i później, rozumiano, iż warunki początkowe procesów fizycznych jednoznacznie wyznaczają skutki jakie się dokonują. Takie właśnie cechy ma cały formalizm mechaniki klasycznej. Czy będziemy rozważali to w kategoriach trzech zasad dynamiki Newtonowskiej, czy w formalizmie Legranda, czy w formalizmie Hamiltona mechaniki klasycznej. Zawsze z tych równań teoretycznie można wyznaczyć wszystko to co się wydarzy, jak i wszystko to, co się już wydarzyło. Cofnijmy się teraz do Leibniza. Co to znaczy to jego określenie “Racji koniecznej”? Było to odwołanie się, niestety jednak w zbyt intuicyjnym rozumieniu, do Prawa Przyczynowości. Leibniz tylko tym stwierdzeniem zauważył, że każdy skutek musi mieć swoją przyczynę (więc z tego wniosek, że ta przyczyna musi być konieczna). Można stwierdzić, iż w ten sposób Leibniz zdefiniował, ale tylko po części, Prawo Przyczynowości. Gdyby urodził się nieco później, to znaczy już po odkryciu praw mechaniki kwantowej, można być pewnym, że to on umiałby prawidłowo sformułować Prawo Przyczynowości. Nota bene ta Racja Konieczna posłużyła później teoretykom do sformułowania formalizmu Legranda razem z ogromnie ważną Zasada Najmniejszego Działania. Jeszcze się wtedy ani nie śniła “przypadkowość” lub “Pozornie przypadkowość” w mechanice klasycznej czy ogólnie w fizyce. Oczywiście, doskonale znano wtedy rachunek prawdopodobieństwa, ale traktowano go jedynie za erzac, za środek mający praktyczne zastosowanie, wynikające ze złożoności obiektywnie deterministycznych zjawisk. Jakże charakterystycznie brzmi w tym kontekście zdanie, jakie powiedział do Napoleona Bonaparte czołowy matematyk i fizyk francuski doby oświecenia Laplace. Była to odpowiedź Laplace na pytanie, wtedy jeszcze tylko generała Bonaparte, który właśnie zaznajomił się z najnowszą pracą Laplace: … A gdzie w tej pracy działanie Absolutu? Na co Laplace odpowiada: … Sir, ta hipoteza nie była mi konieczna… W tym obrazoburczym zdaniu można się doszukać dwóch odpowiedzi. Oto, że fizycy doby Oświecenia i później, transparentnie wyjaśniali zjawiska nie odwołując się do duchowego i Boga, oraz to, że zjawiska przyrody są Deterministyczne i nawet sam Bóg nie jest w stanie wpłynąć na nie. Laplace’owi przecież wystarczyły “gołe” równania, by określić i przeszłość i dalszą przyszłość układu fizycznego. Bez żadnego odwołania się do Boga. Wychodząc nieco przed szereg, mogę gorzko skonstatować: Niestety, Panie Laplace, nie miał Pan do końca racji. Właśnie tą publikacją będę się starał tego dokazać. To, że świat nie jest zdeterminowany, że świat oprócz poziomu rzeczywistego posiada także poziom głębszy, ten Niemierzalny, którego konsekwencje działania manifestują się dopiero na tym poziomie Mierzalnym. Fizycy, naukowcy, już czują posmak tego poziomu. Operują oni bowiem takimi pojęciami jak cząstki wirtualne, procesy wirtualne. Mniejsza o nazwę, możemy ten poziom nazwać Poziomem Wirtualnym. Ja w swoich wcześniejszych publikacjach nazwałem ten poziom Poziomem Transcendencji. Być może wielu fizykom taka nazwa mocno będzie przeszkadzać, więc nie jest moją intencją za wszelką cenę promować taką nazwę. Używałem tej nazwy z racji tego, że mocno musi się ona kojarzyć każdemu, kto dogłębnie przemyśli ten temat, z Duchowym, z Absolutem. Nie mam jednak żadnego formalnego powodu, aby zastępować osoby do tego powołane w szerzeniu wiary lub treści duchowych. Każdy, kto zada sobie trudu, aby zaznajomić się z treścią tej i podobnych publikacji, i tak będzie się musiał się opowiedzieć. Będzie musiał określić swoje credo. Mogę cię jednak, Szanowny czytelniku, zapewnić, że treść tej książki nie pozostawi ci żadnego wyboru. Uwierzysz. Dowody bowiem na Duchowe, w tej książce są niepodważalne. Dowody- choć w dużej mierze poszlakowe, tak to prawda- są spójne logicznie i pozostawiają bardzo mało miejsca na jakiś margines błędu. No chyba, że zamiast dwóch poziomów wybierzesz zyliony zylionów rozłącznych wszechświatów. Będziesz miał jednak w tym przypadku rację, ale tylko z prawdopodobieństwem mniejszym niż wytypowanie głównej nagrody w Euro Jacku. Czy można więc być już większym pesymistą w takim przypadku? No, niestety ludzie pokroju Prof. Richarda Dawkinsa istnieją i będą istnieć. Więc niby wybór jest. Ale choć, książka ta opiera się na dogłębnej krytyce Racjonalizmu, jeśli masz jakieś sprawne komórki mózgowe, to wybór jest tylko jeden. Żeby być tu do końca precyzyjnym, ja choć krytykuję Racjonalizm, ale krytykuję tylko ten wypaczony. Dostrzegam bowiem w logice mocno newralgiczne miejsca, które stały się na przykład kanwą Twierdzeń o Niezupełności Kurta Gödla. Oto w tym chodzi, że z fałszu można wyprowadzić dowolne wnioski. Więc fałsz i nieprawda mogą nas doprowadzić do każdego celu, nawet tego chybionego. I tu jest właśnie cały szkopuł Racjonalizmu. Aby to pokazać przedstawię tu prawo Dunsa Szkota, że :(P and ~P) =>Q, które dosłownie mówi, że z fałszu wszystko wynika, dowolne “Q”, nawet bzdura i nonsensy. Trzeba mieć więc zawsze na uwadze, że w każdym systemie zamkniętym (Prawa Gödla) istnieją prawdziwe zdania niedowodliwe. Jeśli istnieją prawdziwe, to istnieją też fałszywe zdania niedowodliwe. Czyli tłumacząc to na nasze, istnieją zawsze zdania, które nie można udowodnić, ani że są prawdziwe, ani że są fałszywe. No i co na ten temat ma do powiedzenia Racjonalizm? Ale, nie znaczy to, że nie doceniam roli logiki i umysłu. I z całą siłą będę się tu powoływał na logikę i na umysł, gdy znajdę na to podstawy. Trzeba jednak znać te bariery Racjonalizmu i trzeba je uwzględniać. A więc, jaki stąd wniosek, nie widząc w pewnych przypadkach czy mamy do czynienia z prawdą lub fałszem (twierdzenia Gödla)? Zważ czy wnioski na tym oparte doprowadzą cię w takim razie do kompletnej bzdury? Nawet w systemach opartych na aksjomatach można się spodziewać, że jakiś aksjomat będzie dość ułomny. Na takiej ułomności jednego aksjomatu zbudowane są dwie geometrie, w zależności, jak się ten aksjomat potraktuje. Mam na myśli geometrię Euklidesową i geometrię krzywoliniową. A ten aksjomat brzmi, iż: na płaszczyźnie przez punkt nie należący do danej prostej zadanej można przeprowadzić tylko jedną prostą równoległą do tej zadanej. Nie można tu, oczywiście, mówić o jakiejś bzdurze, ale przez wiele stuleci nie wyobrażano sobie, że można ten aksjomat podważyć. Dla ciekawostki podam dwa równoważne sformułowania tego aksjomatu, które często można znaleźć w opracowaniach na ten temat. Pierwsze brzmi, iż suma kątów w każdym trójkącie wynosi 180°. Drugie to takie, iż przez dwa różne punkty na płaszczyźnie można przeprowadzić tylko jedną prostą. Te wszystkie trzy (a pewnie jest ich nieco więcej) sformułowania są sobie równoważne i stanowią treść i sens tak zwanego piątego pewnika w geometrii Euklidesowej.

Co ciekawe dla fizyków szczególnie ciekawy jest ten, iż suma kątów w trójkącie wynosi 180°, ponieważ pozwala on wyznaczyć, czy nasza czasoprzestrzeń jest zakrzywiona. Od wielu lat prowadzi się bowiem badania astrofizyczne i mierzy się takie trójkąty, których wierzchołki stanowią odpowiednie obiekty kosmiczne. Nie jest to jednak taka prosta sprawa, ale bada się, na ile się da, w ten sposób (sumując kąty w takich trójkątach), czy nasza przestrzeń (ściślej czasoprzestrzeń) jest zakrzywiona, czy nie. Bo, gdyby się okazało, że suma kątów w takich astronomicznych trójkątach była inna, minimalnie inna, to by znaczyło, że nasza przestrzeń (czasoprzestrzeń) jest krzywoliniowa. Na razie wiadomo jedynie o lokalnym zakrzywieniu czasoprzestrzeni w okolicach szczególnie masywnych obiektów, na przykład gwiazd, co tylko potwierdza OTW (Ogólną Teorię Względności). W 1919 roku ekspedycja Eddingtona do Afryki Zach. potwierdziła w czasie zaćmienia Słońca, że światło ulega zakrzywieniu, jego tor ruchu, w pobliżu masywnych obiektów kosmicznych, chodziło tu konkretnie o nasze Słońce. W ten sposób potwierdzono OTW i zyskała ona rangę obowiązującej teorii. Nie stwierdzono jednak w licznych eksperymentach ogólnego zakrzywienia czasoprzestrzeni, wydaje się więc, że jest ona w większej skali Euklidesowa lub nazwijmy ją ostrożnie quasi Euklidesowa. Ogólnie piąty aksjomat geometrii Euklidesowej zaczął być mocno podejrzany dopiero w nowożytności, w starożytności uznawano go za pewnik absolutny. Podważając go jednak, uzyskano bardzo potężne i przydatne narzędzia matematyczne geometrii krzywoliniowych, które między innymi stało się bazą do na przykład formalizmu rozmaitości różniczkowalnych, bez których trudno sobie wyobrazić współczesną fizykę. Istnieją jeszcze inne przykłady “dziwnych” pewników w systemach matematycznych. Od razu przychodzi tu do głowy tak zwany Aksjomat Wyboru w teorii mnogości. W zależności, czy uwzględnia się ten aksjomat lub jego negację uzyskuje się odpowiednio inne teorie mnogości, które, jak się okazują, mają konkretne zastosowania w teoriach matematycznych. Ta publikacja jednak ma profil nauki zwanej fizyką, więc zostawmy te matematyczne dylematy. Bardziej mi tu chodzi, aby wzbudzić u ciebie, Szanowny czytelniku, nutę sceptycyzmu co do niepodważalnego Racjonalizmu, jakim widzieliby go ateiści i materialiści. Zawsze istnieje ten cień niepewności. Dlatego między innymi w fizyce istnieje zasada, sam nie wiem czy do końca całkowicie słuszna, iż teoria musi być potwierdzona doświadczeniem. Jak sam zobaczysz nieco później, ta zasada ma też swoje cienie i to bardzo pryncypialne, ale o tym potem. Ogólnie jednak przyjmuje się w fizyce, że dywagacje teoretyczne powinny być sprawdzone w praktyce. Praktycznie wszystkie obowiązujące teorie fizyczne zostały potwierdzone w szeregu doświadczeniach empirycznych. Szkopuł w tym, że to nie Determinizm, a Indeterminizm jest właściwą formą Przyczynowości. Teraz to tylko sygnalizuję. Nieco później to uzasadnię. Lecz jeśli formą Przyczynowości (Prawa Przyczynowo — skutkowego) jest Indeterminizm, to fałszywe jest przekonanie fizyków, że doświadczenia muszą generować te same rezultaty. A to właśnie na takim postulacie błędnie oparta jest cała współczesna fizyka (z mojego punktu widzenia ta archaiczna). No bo przecież Indeterminizm można sformułować równorzędnie tak, iż oznacza on, że te same przyczyny nie prowadzą do tych samych skutków. Procesy fizyczne dokonują się z pewnym prawdopodobieństwem. Przyjmijmy na razie, że z prawdopodobieństwem. Później będę się starał wykazać, że to prawdopodobieństwo nie jest takie losowe, lecz wynika z głębszej zależności. Od razu zaznaczam, że nie jest to wyraz zawoalowanego Determinizmu. Widać więc od razu, że koncepcja potwierdzania teorii za pomocą doświadczenia już na tym etapie musi się wydawać bardzo zwodnicza. Fizycy doświadczalni doskonale wiedzą, że nie ma praktycznie dwóch takich samych pomiarów, jest jedynie pewna statystyczna powtarzalność. Za czasów pełnej dominacji fizyki klasycznej tłumaczono to dość pokrętnie błędami pomiarowymi. I dopiero mechanika kwantowa z jej zasadą nieoznaczoności Heisenberga wyjaśniła to w sposób dość zadowalający, jako przejaw a priori pewnych cech układów zamkniętych. Parametry układów niekomutujące ze sobą, inaczej nieprzemienne, po prostu a priori nie da się pomierzyć z dowolną dokładnością. Są one zawsze obarczone niedokładnością, której nie da się obejść. Niestety fizycy, i to ci akademiccy, trzymają się starego klasycznego paradygmatu w tym względzie. Wykonane pomiary muszą potwierdzać dane teorie, i tyle. Więc na to dictum musiała zareagować matematyka. Oto statystyczne opracowania doświadczeń rozwiązują ten problem.

Bowiem według statystyki, tylko statystyczna powtarzalność pomiarów i doświadczeń pozwala formułować teoretyczne wnioski. Pomiar, jeden pomiar, właściwie nic nie daje. On nie istnieje. Tylko ogrom pomiarów, pozwala na formułowanie empirycznych wniosków. Niestety nie zlikwidowało to równocześnie tego Deterministycznego ducha, który nad tym wszystkim czatuje i bardzo oszczędnie są formułowane wszelkie Indeterministyczne wnioski płynące z doświadczeń i postulatów samych teorii. Ten potwór Determinizmu, Racjonalizmu i Mechanicyzmu nadal broni swoich przebrzmiałych przywilejów. I nie chce odpuścić. Powiem to w przedbiegach, później uzasadnię, że tylko procesy z Poziomu Mierzalnego mogą spełniać Deterministyczne postulaty. Mnóstwo jest zjawisk fizycznych, których czysty Determinizm nie jest w stanie wyjaśnić. Na przykład rozpad promieniotwórczy naturalny. Innym takim zjawiskiem jest choćby to, że elektrony w atomach nie spadają na jądra atomowe. Wydawać by się mogło, że to drobna sprawa, a przecież na tym cały świat stoi. Sugeruje się, że to właśnie prawa mechaniki kwantowej, czyli zjawiska jak najbardziej, które wynikają z Indeterminizmu, tłumaczą to. Tak, to prawda, ale jednak dopiero określenie prawidłowej formuły Przyczynowości, czyli Prawa Przyczynowo -skutkowego podaje właściwe wytłumaczenie tych procesów. W tej książce pozwolę sobie na dogłębne rozpatrzenie tych problemów. No tak, zakaz Pauliego dla elektronów. No tak, zasada nieoznaczoności Heisenberga. To wszystko prawda, to w pewien sposób tłumaczy, jak się zachowują elektrony w atomach. Ale tak naprawdę fundamentalna przyczyna tego zachowania zależy od prawa Przyczynowości. Prawo Przyczynowości jest jednym z fundamentalnych praw przyrody i to aż dziwne, że nie zostało ono dotąd w sposób mu przynależny przeanalizowane. Wszyscy dotąd jakby ślizgali się po tym temacie i snuli na ten temat werbalne potworki. Prawo Przyczynowości jest tak fundamentalnym prawem, iż wiadomo, że niemożliwe są procesy fizyczne, które by z nim kolidowały. Weźmy takie cofanie się w czasie. Ze stuprocentową pewnością można stwierdzić, iż niemożliwe jest, przynajmniej na Poziomie Mierzalnym, cofanie w czasie, bowiem wtedy mogłoby dochodzić do procesów powiązanych Przyczynowością, w których skutki poprzedzały by przyczyny. Wiadomo bowiem, i tyle przynajmniej, dzięki Bogu, udało się ustalić dotąd, że zawsze przyczyny muszą poprzedzać w czasie skutki. Wychodząc teraz przed szereg, stwierdzę, że jest to słuszne na Poziomie Mierzalnym. Od razu przychodzi tu jako argument tak zwany Paradoks Dziadka. Oto, wnuk cofa się w czasie i zabija swego dziadka, nim się jeszcze urodził jego ojciec. To jest właśnie klasyczny przykład, kiedy skutek poprzedza przyczynę. Właśnie dzięki takim przykładom wiadomo, że na Poziomie Mierzalnym nie może się zrealizować cofanie w czasie. Ale?! Istnieje jednak pewne “ale”, o którym napiszę dopiero w dalszej części tej publikacji. To “ale” związane jest, no dobrze już powiem, z tym drugim poziomem Rzeczywistości, z Poziomem Wirtualnym (poziomem niemierzalnym). Warto tu sobie uzmysłowić, iż jeśli rozpatrujemy przyczyny i skutki, to należy pamiętać, że choć przyczyny mogą być jakość specjalnie złożone, to jednak rozpatrując je najmocniej redukcjonistycznie, dochodzimy po prostu do sił elementarnych. Więc właściwa definicja przyczyny jest taka, że są to w konsekwencji jakieś siły elementarne, które powodują dane skutki. Podkreślam tu teraz, co później wyjaśnię, że chodzi tu o przyczyny sprawcze. Jakie mamy siły elementarne? Są to siły: elektryczne, magnetyczne, jądrowe i grawitacyjne. Wszystkie inne rodzaje sił, są po prostu złożeniem tych elementarnych. I tak na przykład siły mechaniczne, te z którymi my ludzie mamy najwięcej do czynienia, to są złożenia sił elektrycznych, magnetycznych i grawitacji. To, że samochód jedzie po drodze, że my chodzimy, te wszystkie konsekwencje sił mechanicznych są złożeniem działania sił bardziej elementarnych. Na przykład wielkość Newtona polega między innymi na tym, że podając prawo mechaniczne (czyli dotyczące właśnie tych sił mechanicznych), sformułował prawo, które klasycznie dotyczy wszystkich rodzajów sił. Chodzi tu, oczywiście, o jego II Zasadę Dynamiki, a= F/m. Śmiało można stwierdzić, że jest to najważniejsze równanie mechaniki klasycznej, a ogólnie fizyki klasycznej, bowiem stosować je należy do każdego rodzaju sił, nie tylko mechanicznych. A poprzez to równanie otrzymuje się wszystkie parametry ruchu danego ciała, poddanego tej sile. Przed Newtonem utrzymywano, że siła ma wpływ jedynie na prędkość danego ciała. To były echa poglądów jeszcze

Arystotelesa, który narobił więcej złego niż dobrego w nauce swoimi “przeczuciami”. Galileusz, któremu było najbliżej do Newtona, i który był tuż przed nim w nauce, praktycznie sformułował treść I Zasady Dynamiki Newtona. Określił on, że ciało, na które nie działają siły, albo pozostaje w spoczynku, albo porusza się ruchem jednostajnym po torze prostoliniowym, nota bene to było też sprzeczne z tym, co głosił Arystoteles, i co było uznawane przez wiele stuleci za pewnik, który to uznawał, że naturalnym dla ciał jest stan spoczynku i do tego stanu wszystkie ciała dążą. Dziś wszyscy wiemy, że ciała są permanentnie w ruchu i w zależności od układu odniesienia ten ruch się zmienia. I tak, choć kula jest w spoczynku względem Ziemi, to i tak porusza się razem z Ziemią wokół Słońca, itd. My dziś doskonale wiemy, czego nie byli świadomi starożytni (Arystoteles), że ciało poruszające się po ziemi (np. kula), dlatego zastyga w konsekwencji w bezruchu, bo działają na nią jeszcze siły tarcia gruntu i oporu powietrza, i w konsekwencji traci ona (kula) stopniowo swoją energię (kinetyczną) poprzez rozproszone ciepło, a także traci pęd, który przejmują drobiny powietrza i gruntu (a nawet Ziemia) i w konsekwencji zastyga po pewnym czasie w bezruchu. Ale, broń Boże, nie jest to stan naturalny dla ciał, na które nie działają siły.

Mechanika klasyczna a Determinizm

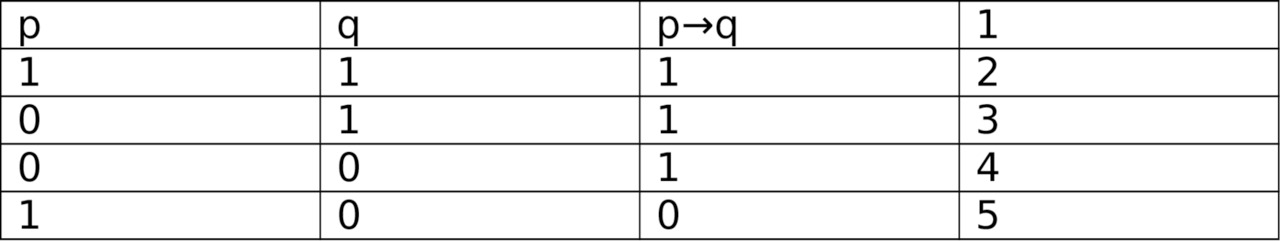

Jeszcze jesteśmy na bardzo prymitywnym poziomie, jeśli chodzi znajomość praw Przyrody w tym naukowym względzie. Jako Homo sapiens sapiens nasz gatunek istnieje od około stu tysięcy lat. Nasze mózgi prawdopodobnie osiągnęły pewien optymalny stan, ale nasze psychiki są daleko w ogonie. Jesteśmy dość słabi pod tym względem, bywa, że rzeczywistość nas przytłacza. Ale mniejsza o to. Jesteśmy prymitywni pod względem naukowym, bo nasza nowożytna nauka liczy sobie trzysta może czterysta lat. Nasza cywilizacja ma raptem sześć tysięcy lat, i to licząc od Sumeru. To zadziwiające, ale cywilizacja Sumeru rozkwitła nagle i niespodziewanie na obszarze Mezopotamii, i w przeciągu mniejszym niż dwa tysiące lat dokonała takich odkryć, z których nawet my dzisiaj korzystamy. Ja, osobiście, uważam, że mogło się tak stać tylko z jednej przyczyny. Musiał być wtedy dokonany kontakt z Obcymi. Te legendy Sitchina… Coś musi być w tym na rzeczy, bowiem jaka roślina wydaje plony bez odpowiedniego użyźnienia i przygotowania. W ten sposób można też wyjaśnić nasze dość słabe psychiki, bo przecież za Sitchinem zostaliśmy ukształtowani (nie stworzeni, ale ukształtowani) tylko i wyłącznie do pracy fizycznej i do służby bogom (Obcym?) z tą ogólną konkluzją, byśmy nie mądrowali nadmiernie. A potem ciach… I się wymknęliśmy, a może Oni nas zostawili tu samych? A może nas obserwują, czego też sami dokonamy? Co można jednak dość obiektywnie powiedzieć? To mało. Te sześć tysięcy lat to mało. Te trzysta lat to też mało. Zdecydowanie mało jak na czas istnienia życia na Ziemi, który to czas szacuje się na pół miliarda lat, przynajmniej od powstania wielokomórkowców. Pozostańmy przy tym porównaniu: 6 000 lat a 500 000 000 lat, oraz 300 lat a 500 000 000 lat. Wniosek jaki stąd może tylko wypływać, że jesteśmy jeszcze na bardzo wstępnym poziomie. Jednak pomimo tego dość pesymistycznego wtrętu każdy musi przyznać, że od około stu lat postęp techniczny jest porażająco wielki. Prognozy zaś są jeszcze bardziej zdumiewające, lecz raczej pesymistyczne. Gdzieś w niedalekiej przyszłości, czyli raptem za trzydzieści może czterdzieści lat AI, czyli Sztuczna Inteligencja, ma w pełni przejąć tę pałeczkę sztafetową dalszego rozwoju i postępu. Czyjego rozwoju? Naszego, a może już innego? Czy więc z tego punktu widzenia, te trzysta lat to dużo lub mało, jeśli w krótkiej perspektywie być może czai się już koniec naszego gatunku? Może Inteligencja ubrana w ciała biologiczne (czyli my) jest z góry skazana na tą dość krótką fazę rozwoju. Trudno bowiem sobie wyobrazić, przynajmniej mi, by nasi potomkowie mogli na dłuższą metę kontrolować maszyny (AI). One nie będą miały takich barier jakie my mamy z naszymi mózgami i osobowościami, ich dalszy rozwój będzie stale progresywny. Wszystkie książki, napisane nawet współcześnie, na ten temat mają bardzo pesymistyczny wydźwięk w tej kwestii. Lecz jest, a może są, pewne kwestie, które być może maszyny nie przeskoczą. Świadomość? Dusza? Życie? Póki co AI jest jeszcze w powijakach. A my przyjrzyjmy się temu rozwojowi nauki kiedyś oraz przez ostatnie trzysta może czterysta lat minionych. Zacząć więc trzeba od starożytnych filozofów, a właściwie ograniczę się tu tylko do jednego, tego, którego dziedzictwo ostało się w miarę kompletne. Oczywiście starożytni nie operowali takimi nowoczesnymi pojęciami jak: siła, energia, czy pęd. W każdym razie Arystoteles uważał, że naturalną dążnością ciał na Ziemi jest osiągnięcie spoczynku. Ponieważ nie znał działania na ciała tarcia i oporu powietrza, dlatego nie uwzględniał tego i stąd, obserwując zawsze, że każde ciało na Ziemi, choćby było nie wiadomo jak mocno rozpędzone, po ustaniu bodźca tego ruchu, zatrzymuje się, więc uznał, że jest to naturalna skłonność wszystkich ciał. Co my już doskonale wiemy jest kardynalnym błędem. Ale to dopiero wykazał swymi eksperymentami z kulami toczonymi na równi pochyłej Galileusz. Drugim takim kardynalnym błędem Arystotelesa i jemu współczesnych, przynajmniej jeśli chodzi o fizykę, było uznanie, że siła działa nie na przyspieszenie ciał, lecz że zmienia ona szybkość obiektów poruszanych. Starożytni, jak pisałem, używali całkiem dla nas dziś egzotycznych nazw na wielkości fizyczne, i tak w ujęciu Arystotelesa siła to był pewien motor, który działał na ciało. Gdybyśmy jednak chcieli rozumowanie Arystotelesa opisać współczesnymi pojęciami, to miałoby to taką postać: F=mv. Co my dziś wiemy, jest kompletną bzdurą, znaczyłoby to, iż ciało, aby się poruszać, musiałoby stal być pobudzane siłą, bo gdy siła “F” jest równa zeru, to i prędkość “v” musi mieć wartość zero. Bo, stąd że F=0, to F= mv=0, a że ciało nie ma masy równej zero m≠0, stąd v=0. Skorygował to rozumowanie dopiero Newton w XVII wieku. Nam się może wydawać, że to minęło strasznie dużo czasu między czasami Arystotelesa i Newtona, bo to aż ponad dwadzieścia stuleci. Ale z drugiej strony, rozpatrując to zgodnie z tym, co zauważyłem na początku, że odległości czasowe między tymi wydarzeniami a okres 500 000 000 lat, to naprawdę w tej skali był moment. Można bowiem skonstatować, że oba te poglądy to były kamienie milowe w dziejach cywilizacji i nauki ludzkiej. Fakt, że jeden błędny, a dopiero drugi prawidłowy jest normalną konsekwencją postępu. W nauce jednak, nie tak jak w finansach, w walutach, to lepsze wypiera gorsze. I tu też mamy taką sytuację, prawidłowy pogląd unieważnił, wyparł fałszywe mniemania. Być może to jest zasługą greckich, starożytnych filozofów, a może i właśnie samego Arystotelesa, ale jeśli dziś rozważamy, gdzie narodziła się nauka, wiedza to myślimy głównie o Europie. Dlaczego tak się stało? Dlaczego nie bierze się pod tym względem Azji z Chinami i Indiami? Prawdopodobnie dlatego, że to właśnie Arystoteles wprowadził Logikę do filozofii, a to miało decydujące znaczenie, a jeśli nie decydujące, to bardzo silne znaczenie w tej kwestii. Wprowadził i określił jej wagę i przedstawił ogólny schemat dowodzenia twierdzeń i prawd za pomocą logiki. To właśnie od tamtych czasów znamy właściwie dwa typy dowodzenia twierdzeń. To już nazywane z łacińska: Modus Ponens oraz Modus Tollens, inaczej Regułę Odrywania i Regułę Nie Wprost. Inne rodzaje dowodzeń, na przykład dowód Indukcyjny, wynikają właśnie z którejś z tych reguł. Można stwierdzić, że reguły dowodzenia wynikają z właściwości implikacji logicznej, czyli części logiki formalnej. Aby nieco naświetlić ten aspekt pokażę na jakiej zasadzie dokonuje się takich dowodzeń. Modus Ponens przedstawia się tak, jeśli mamy, jakieś założenie “a” i wiemy, że jest ono zawsze prawdziwe. To może być na przykład jakiś pewnik lub aksjomat, ale może to też być już jakieś udowodnione zdanie lub twierdzenie (na przykład lemat), to wtedy wiedząc, że prawidłowo przeprowadzony proces dowodzenia, innymi słowy, że cała implikacja logiczna jest prawdziwa, możemy stwierdzić, czyli: a →b jest prawdziwe, to stąd wynika, że także “b” jest prawdziwe. Wynika to stąd, iż to właśnie implikacja logiczna jest synonimem dowodzenia, wnioskowania i analizowania myślowego i logicznego. To właśnie jest dziedzictwo starożytnych, a właściwie Arystotelesa. Drugi rodzaj dowodzenia, czyli Modus Tollens, polega na tym, iż, jeśli wiemy, że prawidłowo przeprowadziliśmy jakieś rozumowanie (implikację logiczną)

i z wstępnych założeń wyniknęła nam jakaś bzdura, czy nonsens, czy po prostu jawny fałsz, to wstępne założenie musi być w tym momencie fałszywe, czyli: jeśli a →b jest prawdziwe, i wynika stąd, iż “b” jest fałszem, to z tego wynika, że “a” musi też być fałszem. To jest prosta konsekwencja implikacji logicznej, taka iż, jeśli jest ona prawdziwa, to z prawdy nie może wyniknąć fałsz. Bez dowodzenia swoich prawd nauka nie miałaby racji istnienia. Z drugiej strony upowszechnienie się alfabetów, czyli pisma miało też znacząca w tym rolę. W Chinach i Indiach lub w Egipcie w tym czasie też była rozwinięta bogata kultura, ludzie też znali wynalazki i udogodnienia, które pojawiały się na całym zamieszkałym ówcześnie świecie. Być może nieliczni mędrcy chińscy i azjatyccy znali podstawy logiki, ale to właśnie w Grecji, w Europie logikę zaczęto stosować i upowszechniać w kręgach ówcześnie ludzi wykształconych. Później to całe dziedzictwo przejęli Rzymianie i kontynentalna Europa. W konsekwencji tej nauka zaczęła się spiętrzać, bowiem udowodnione prawdy można było spisywać w pewne uporządkowane katalogi (księgi). A te katalogi można było przekazywać następnym pokoleniom. Wiedza, można tak stwierdzić, nie rozpływała się i nie uległa zapomnieniu, co na przykład zdarzało się w Azji, i to, co już udowodniono, na trwale wpisywało się w dziedzictwo cywilizacji europejskiej. Powstały wtedy pierwsze słynne biblioteki, gdzie właśnie przechowywano tę całą wiedzę. Przykładem niech będzie Biblioteka Aleksandryjska, która niestety została zniszczona (prawdopodobnie jej zbiory zostały spalone) w pierwszych wiekach naszej ery, do dziś istnieją spory, kto jest winny temu dziełu zniszczenia. Ale takich bibliotek powstawało coraz więcej w całej Europie, być może nie tak wielkich, ale jednak w konsekwencji proces ten był już nieodwracalny. Jedynym felerem tamtego okresu i tego gromadzenia się i nawarstwiania wiedzy ówcześnie było to, że wtedy jeszcze nie znano druku. I w konsekwencji każdą księgę powielano poprzez ręczne kopiowanie. Dlatego też każdy egzemplarz księgi, na przykład jakiegoś wybitnego myśliciela, był bardzo cenny i zniszczenie dowolnego zbioru takich ksiąg było bardzo dotkliwe. Sytuacja zmieniła się dopiero wraz z wynalezieniem druku Gutenberga. Właściwie wcześniej znano już pewne aspekty druku, wkładem zaś Gutenberga było wynalezienie ruchomych czcionek, wykonywanych z metalu, około 1440 roku, które zrewolucjonizowało cały proces druku. Narodził się nowy fach zecera czcionek, który zastąpił, pod względem rangi, dawny fach skryby kopisty, który ręcznie przepisywał księgi. I nie dziwi więc to, że po tym czasie, czyli po 1440 zaczęły drukiem wychodzić księgi, w których ówcześni mędrcy zaczęli gromadzić coraz to nową wiedzę. Teraz te księgi nie wychodziły już w kilku egzemplarzach, jak to było w przypadku ksiąg pisanych ręcznie, bo bardzo łatwo było uzyskać nakłady znacznie większe, początkowo sięgające kilkuset ksiąg. Tak było z pierwszą księgą Gutenberga, z Biblią Gutenberga, która powstała w latach 1552 do 1555 i miała ona nakład kilkuset egzemplarzy (około 200 egzemplarzy). Sukcesywnie pokonywano wszystkie trudności druku i nakłady ksiąg drukowanych stawały się coraz większe. Jedyną jeszcze tylko trudnością ówcześnie był proces produkcyjny papieru, dobrej jakości papieru, który nadawałby się do druku. Papier był więc dosyć cennym produktem. Ale i tą trudność sukcesywnie w kolejnych wiekach udało się pokonać. I to właśnie z wynalezieniem druku wiąże się następny milowy krok uczyniony przez człowieka na drodze rozwoju cywilizacji i nauki. Jak pisałem logika i potem katalogizacja wiedzy, która już nie jest zatracona i odkrywana niemal na nowo, a teraz to, że wzrosła ilość i to po wielokroć tworzonych ksiąg, w tym przypadku drukowanych, spowodowało, że ten cały proces nabrał niewyobrażalnego wręcz przyśpieszenia. Doskonale w to wpisuje się powstanie księgi Mikołaja Kopernika “O obrotach sfer niebieskich”, która to księga uważana jest powszechnie za początek powstania naukowości w tym nowoczesnym rozumieniu. W księdze tej Kopernik zrywa z ptolemeuszowski wizją świata, w którym Ziemia była uważana, za niewzruszone centrum świata, wokół której poruszały się wszystkie planety w tym Słońce. Znane jest powszechnie to stwierdzenie, że Kopernik ...wstrzymał Słońce i poruszył Ziemię… Ta księga mimo całej swojej nowoczesności, jak na tamte czasy, zawiera też kilka kardynalnych błędów.

Najważniejszym błędem Kopernika było to, iż nie umiał on sobie jeszcze wyobrazić orbit planet nie jako okręgów. Kopernik wierzył w to do końca, że budowa Układu Słonecznego musi być tak idealna, że tylko okręgi mogą być rozważana jako orbity ciał niebieskich. Ten błąd skorygował dopiero Kepler, który w końcu rezygnując z ideału, pozwolił planetom poruszać po mniej idealnych elipsach. To trzymanie się Kopernika ideału, to uznawanie orbit za okręgi doprowadziło w istocie do jeszcze większej komplikacji w obliczeniach odpowiednich zjawisk astronomicznych w Układzie Słonecznym, niż to, które niosło ze sobą teoria Ptolemeusza. Książkę właściwie Kopernik ukończył w 1519 roku, ale została wydana dopiero w roku śmierci astronoma w 1543 roku. Jak legenda podaje, astronom dostał swą wydaną drukiem księgę na łożu śmierci. Jest to raczej barwna fantazja, która miała służyć li tylko popularyzacji tej pozycji. Tę zwłokę tłumaczy się tym, iż obawiano się reakcji Watykanu i ogólnie Kościoła, było to bowiem jawne targnięcie się na prawdę objawioną, która zawarta była na kartach Biblii. W ogóle, post factum, uważa się, że pozycja ta strąciła z piedestału nauki Boga, podważając wyjątkowość Ziemi i czyniąc z niej jedną z wielu “zwyczajnych” planet, oczywiście, chodzi o Układ Słoneczny, a nie Kosmos jako taki. Nie dziwi więc to, że wydawca księgi w Norymberdze, usunął oryginalną przedmowę Kopernika i zastąpił ją specjalnie spreparowaną przedmową teologa Norymberskiego, niejakiego Andreasa Osiandera, który sugerował w niej, że księga ta jest jedynie wybiegiem matematycznym, pewną abstrakcyjna teorią, która miała zastąpić skomplikowaną matematycznie teorię Ptolemeusza. Jak już pisałem, było wręcz odwrotnie. To właśnie teoria Kopernika nastręczała więcej komplikacji obliczeniowych. I rzeczywiście, początkowo Watykan też tak potraktował tę pracę, jako ciekawostkę. Jednakże już po pewnym czasie, sytuacja wobec dzieła polskiego astronoma się radykalnie zmieniła i oczywiście księga znalazła się na oficjalnej czarnej liście Ksiąg Zakazanych. Co znamienne lista powstała znacznie później po wydaniu księgi Kopernika, bo dopiero po 1559 roku. Więc przynajmniej przez piętnaście lat księga ta nie była zwalczana nadmiernie. Można to uznać za zrządzenie losu, że ani autor, ani wydawca dzieła nie mieli tylu kłopotów, jak późniejsze pokolenia wybitnych naukowców i myślicieli, kiedy to dopiero zaczął się nasilać ten terror kościelny wobec wszystkiego co zakazane przez papieża i Kurię Rzymską. Przecież Giordano Bruno za herezję spłonął na stosie w 1600 roku (miało to dość luźny związek z teorią heliocentryczną Kopernika, a bardziej chodziło o to, iż Bruno utrzymywał, że są inne planety w Kosmosie, na których są inne formy życia i inne cywilizacje niż ludzka, co było wówczas jawną herezją), a Galileusz musiał się wyrzec heliocentryzmu w 1633 roku, pod groźbą równie dotkliwej kary. Z tego punktu widzenia można rzec, że Kopernik miał nieco szczęścia, że urodził się znacznie wcześniej, a swoją pracę ogłosił w czasach nieco bardziej tolerancyjnych. Ale, pomimo tego jawnego oporu Kościoła Katolickiego, wobec nowych obrazoburczych nieraz koncepcji nauki, tego procesu triumfu nauki nie można było już zatrzymać. Wyraźnie to Bóg ustąpił ze swojej pozycji w nauce. Po prostu naukowcy i myśliciele wprost nie wypowiadali się przeciw pozycji Boga, i wiary w niego, tylko z mozołem robili swoje. Robili krecią robotę. Już niedaleko było zaranie doby Oświeceniowej z jej bezpośrednim odwołaniem się do Determinizmu, Materializmu, Mechanicyzmu i Racjonalizmu. To, co ja tu piszę, okaże się ciosem w te koncepcje materialistyczne, okaże się ukłonem w kierunku tego co Duchowe, ale żeby być precyzyjnym, muszę jednak oddać szacunek temu początkowemu ruchowi w kierunku odwołania się w potęgę rozumu i logiki. Tamte czasy to rzeczywiście były czasy kołtuństwa, zabobonu i analfabetyzmu. Wyraźnie wtedy Wahadło Czasu wychylone było po stronie ogólnego zacofania. I należało to zmienić. Ówcześni myśliciele starali się, staraniem ludzkiego mózgu, bez odwoływania się do Boga, wyjaśnić mechanizmy funkcjonowania świata i przyrody. I tu trzeba im jak najbardziej oddać hołd i szacunek. Z tą jednak smutną konstatacją, że było to obarczone sporym błędem. Bo okazało się oto finalnie, że ani to świat nie jest do końca zdeterminowany, ani rozum nie jest tak doskonałym narzędziem poznawczym.

A logika, choć piękna i potężna, pełna jest paradoksów i zapętleń. Niestety jednak my, ludzie, skazani jesteśmy a priori na takie pomyłki, bo dopiero ci, co przyjdą po nas, będą wyraźnie widzieli ścieżkę, gdzie to my nieświadomi podążaliśmy. My zaś, tu i teraz, jesteśmy, i to dotyczy wszystkich czasów, w tym też tych doby Oświecenia i tych ludzi tamtej doby, jak ci zakuci w Jaskini Platońskiej, którzy mogą obserwować tylko cienie. Nauka była i jest w dużej mierze oparta na astronomii, bowiem już od zarania dziejów ludzie wpatrywali się w niebo i szukali tam wyjaśnień wszystkich tych spraw, które ich dotyczyły. Szukano tam bogów, szukano sensu istnienia, a nawet wróżb dotyczących zwykłego życia. Astrologia, czyli protoplastka astronomii, podobnie jak alchemia chemii, miała z pozycji gwiazd i planet wydobywać informacje o losach ludzkich. Nie dziwi więc to, że pierwsi nowożytni naukowcy też zajmowali się astrologią i astronomią. Nie wnieśli oni jednak dużo do samej mechaniki. Takim był i Kopernik, i inni, choćby Kepler był właśnie takim typowym myślicielem, który nie wniósł zbyt wiele do mechaniki klasycznej, ale za to, korzystając z zapisków de Braho, określił mechanikę całego Układu Słonecznego. Wyjaśnił to, że planety poruszają się po elipsach, w których ogniskach znajduje się zawsze Słońce. Ten cień astronomii w pracach wybitnych myślicieli i fizyków istniał praktycznie do czasów nam współczesnych. I Galileusz, potem Newton parali się astrologią. Robili to głównie dla zarobku. Galileusz jako pierwszy podważył ustalenia Arystotelesa i stwierdził, że jeśli na ciało nie działają żadne siły, to porusza się ono ruchem jednostajnym po torze prostoliniowym. Ustalił także, że prędkość ciał opadających w polu Ziemi, nie zależy od masy tych ciał, tylko od wysokości, z której są one zrzucane. Istnieje kolejna barwna legenda, jakoby zrzucał on ze słynnej krzywej wieży w Pizie ciała o różnych parametrach i notował czas ich opadania. Stwierdzenie, że ta prędkość zależy tylko od wysokości było na tamte czasy dość rewolucyjne, przecież każdy się może naocznie przekonać, że tak nie jest. Zależy to bowiem w dużej mierze od oporu powietrza danego ciała, więc w rzeczywistości zależy to także od masy tego ciała i jego wielkości. Galileusz wprowadził jednak do fizyki sposób naukowej, redukcjonistycznej analizy zagadnienia, która pozwoliła mu odrzucić mało istotne dla danego zagadnienia aspekty, aby w sposób ilościowy i jakościowy opisać dane zjawisko. Dlatego odrzucił on opór powietrza, odrzucił jego wpływ na ruch spadających ciał i mógł w ten sposób określić w sposób prawidłowy istotę całego zjawiska. Po raz pierwszy więc zastosował on metodę naukową, która będzie miała bardzo szerokie zastosowanie w nadchodzących czasach, i która ma zastosowanie do dziś. Gdyby nie to odrzucenie mało znaczących nieistotnych czynników w danych procesach fizycznych, to badacze nigdy by nie wyszli poza ustalenia Arystotelesa. Po Galileuszu nastąpił nowy czas dla rozwoju nauki. Oto na tej scenie pojawił się Izaak Newton. Ten prawdziwy geniusz swojej epoki, jakże charakterystyczne, nie przejawiał tak od razu w dzieciństwie ani zbytniej lotności umysłu, ani jakiejś takiej umiejętności absolutnego i z pełnym oddaniem zaangażowania się w dany temat, z czego później właśnie Newton był tak znany. Matka nawet w pewnym momencie, w pierwszym okresie dzieciństwa, obawiała się, czy syn nie jest opóźniony. Na szczęście okazało się, że mały Izaak nadrobił z naddatkiem te wszystkie pozorne niedostatki. Sytuacja podobna zdarzył się ponad dwieście lat później w życiu drugiej tak ważnej osoby w historii rozwoju fizyki, chodzi oczywiście o Einsteina. Newton, zgodnie z pewnym schematem osiągania sukcesów w naukach ścisłych, schematem, który powielany jest także w sporcie wyczynowym, swoje największe odkrycia i osiągnięcia na tej niwie dokonał w młodym wieku. Jego dzieło opublikowane w 1687 roku “Philosophiae Naturalis Principia Mathematica”, czyli inaczej “Matematyczne zasady filozofii naturalnej” stało się jednym z najważniejszych dzieł nowożytnej nauki, dotyczących fizyki. Newton zresztą dość długo zwlekał z publikacją swej pracy. Prawdopodobnie w końcu zdecydował się na publikację, bo czuł już presję innych tytanów nauki tamtego okresu, i chodziło mu de facto o pierwszeństwo odkryć.

Co charakterystyczne, właściwie zebrał on i usystematyzował dokonania swych poprzedników, i oczywiście swoje też dołożył. Ale, jakże charakterystyczne, jego sława dziś dotyczy tych praw, które praktycznie przed nim już odkryto. Zresztą, sam Newton nieraz wspominał, że dokonał tego wszystkiego, ...bowiem wspierał się na barkach tytanów… Czyli można to zrozumieć, że miał na myśli poprzedników. Dziś wiemy bowiem, że praktycznie I zasadę jego dynamiki sformułował już Galileusz, a z tej zasady, czyli też niejako dzięki Galileuszowi, wynika II zasada dynamik. Ponieważ Newton opracował podstawy rachunku całkowego i różniczkowego, stąd wiedział, że jeśli ciało porusza się ruchem jednostajnym po torze prostoliniowym, gdy żaden siły nań nie działają, to znaczy, że ma stałą prędkość. W rachunku różniczkowym i całkowym odpowiada to sytuacji, gdy przyspieszenie jest równe zeru. Czyli Newton tylko powiązał tę zależność, że jeśli siła F=0 to a=0, z tego wynika prosty wniosek, że siła “F” nie działa na prędkość, jak chciał Arystoteles i jego apologeci, tylko działa na przyśpieszenie “a”. Stąd wzięło się jego słynne równanie, chyba najważniejsze równanie w mechanice klasycznej: F=ma, będące treścią II Zasady Dynamiki Newtonowskiej. Nie inaczej sprawa się ma, jeśli chodzi o słynne prawo Ciążenia, sformułowane przez Newtona i opublikowane w tym samym dziele. Faktem jest, że to Newton jako pierwszy powiązał ten fakt, że siła z jaką jabłka spadają z drzewa, siła z jaką Ziemia Działa na Księżyc i siła z jaką Słońce utrzymuje planety na orbitach, to ten sam typ oddziaływania. Newton nazwał tę siłę Ciążeniem i opierając się na pracach Keplera oraz na rachunku różniczkowym i całkowym określił w sposób matematyczny postać tej siły. Niemniej to, że taka siła musi być odwrotnie proporcjonalna do kwadratu odległości pierwszy zasugerował Hook, kilka lat przed Newtonem. Nie doprowadził jednak swych rozważań i intuicji do końca, prawdopodobnie a nawet na pewno nie znał on jeszcze rachunku różniczkowego, który przecież odkrył Newton (oraz Leibniz). Hook zresztą całe swoje życie twierdził potem, że Newton podkradł mu pomysł, z czego Newton dość dosadnie szydził. Faktem jest jednak to, że podobną zależność znali już starożytni, bowiem wynika ona z Geometrii Euklidesowej Przestrzennej. Starożytni jednak pojęcia bladego nie mieli, że w ten sposób działa przyroda, była to dla nich tylko matematyczna ciekawostka. Co ciekawe jest jednak kilka absolutnie autorskich odkryć Newtona, na przykład rozszczepienie światła na pryzmacie i udowodnienie, że biały kolor to kompozycja wszystkich barw. Ponadto Newton zasugerował wtedy, że światło składa się z korpuskuł, dziś nazwalibyśmy je fotonami. Zresztą kwestia tego, aby uznać światło za fale, która to zaczęła obowiązywać po słynnym doświadczeniu Younga, dowodzące, że światło ulega interferencji (jak klasyczna fala) na przysłonie, zapanuje długo po Newtonie, ale będzie panowała niemal do dzisiaj. Co ciekawe z tej pracy, którą ci tu, Szanowny czytelniku, przestawiam, idea korpuskuł jako wiązka światła znów zacznie mieć pierwszorzędne znaczenie, ale o tym potem. Miał rację jednak Newton, światło to nie fala, tylko fotony, czyli cząstki. Tu trzeba jeszcze koniecznie wspomnieć o jednej sprawie, która do końca życia nie dawała Newtonowi spokoju. Otóż, uważał on, zresztą jak większość fizyków, że siły przenoszone są poprzez inne ciała. Że nie działają one bez pośrednika. Zresztą dziś obowiązuje podobny pogląd i mówi się o cząstkach wymiany oddziaływań. A tu, w przypadku siły ciężkości nie ma takich cząstek, oddziaływanie jest niejako przenoszone przez pustą przestrzeń. To nie dawało spokoju Newtonowi i, faktycznie, nie rozwiązał on tego problemu. Dopiero Einstein dokładnie rozwiązał to zagadnienie w Ogólnej Teorii Względności, twierdząc, że nie ma żadnych sił ciężkości, jest tylko zakrzywienie czasoprzestrzeni, które wynika z wartości masy danych ciał (kosmicznych). I ciała te poruszają się po liniach geodezyjnych, a nie pod wpływem siły grawitacji, tylko pod wpływem tego odkształcenia czasoprzestrzeni. Więc sprawa jest, przynajmniej z punktu widzenia Poziomu Mierzalnego, wyjaśniona, ale dopiero przez Einsteina. Powracając zaś do prawa ciążenia tego Newtonowskiego, to od razu nasuwa się tu nie do końca wyjaśniona sprawa.

Oto naukowcy do dziś rozróżniają masę bezwładną, tą zawartą we wzorze F=mba i masę ciężkości, zawartą we wzorze

F=(GMmc): R²

Czy mb = mc???, (notabene jest jeszcze podział na masę hadronową i leptonową, ale to już inna kwestia i bardziej współczesna)

Newton przyjął, że te masy są tożsame, jednak niemal do dnia dzisiejszego prowadzone są na całym świecie eksperymenty, aby to potwierdzić lub odrzucić, bo formalnie jest to przyjęty postulat jakby “na piękne oczy”, jako pewnik, ale skąd można wiedzieć, że jest to prawda? Jak na razie wszystkie wyniki z bardzo dużą dokładnością potwierdzają tę zależność. Oczywiście, jest teoria Einsteina (OTW), która dokładnie wyjaśnia mechanizm grawitacji i zgodnie z nią nie istnieją żadne siły grawitacji, ale łatwiejsza w zastosowaniu i obliczeniach jest wzór Newtona, dlatego do dziś to właśnie on ma większe zastosowanie i jest powszechnie używany w astronomii. Sam Newton od momentu opublikowania swoich “Principis…” zaczął być traktowany przez środowiska naukowe, a potem powszechnie przez wszystkich, za twórcę podstaw Racjonalizmu, Determinizmu i Mechanicyzmu, więc zaczęła się oto ta nieszczęsna (w moim pojęciu) epoka zadufania w ludzkie moce i samowystarczalność człowieka. No bo tak, jego praca jest wzorowo logiczna, oparta na przymiotach rozumu i wyprowadzona z przesłanek naukowych, stąd Racjonalizm. Ponadto jego prawa sformułowane w postaci równań różniczkowych są ściśle Deterministyczne, bo taka jest natura takich równań. Warunki początkowe tych równań, określają w sposób pewny warunki końcowe, czyli przyczyny sprawcze są już wystarczające dla ściśle określonych skutków. Ponadto jego II zasada dynamiki wyznacza Mechanicyzm jako koncepcję panującą w fizyce. Oto świat można traktować jako nakręcany zegarek mechaniczny, siły bowiem (mechaniczne) wyznaczają wszystkie parametry ruchu tych ciał, patrz F=ma, czyli a=F/m, stąd można określić znając siłę przyśpieszenie “a” oraz prędkość “v” a także drogę “s”. Paradoksalnie jednak sam Newton nigdy by się tak nie nazwał. Był to człowiek głęboko religijny (Purytanin) i, co wiemy od całkiem niedawna, od schyłku XX wieku, kiedy otworzono spuściznę spisaną ręką Newtona, ten geniusz niemal całe swoje dorosłe życie parał się, po kryjomu- bo to było w tamtych czasach niebezpieczne- Magią, Alchemią oraz namiętnie studiował Biblię i doszukiwał się tam, dziś powiedzielibyśmy, kodów Biblii. Ponadto jego celem było odkrycie Kamienia Filozoficznego. Na pewno to odkrycie, tej prawdziwej twarzy Newtona, było olbrzymim szokiem w środowisku naukowców. Mag czy Racjonalista? Chichot historii, czy nieporozumienie? Wybór, Szanowny czytelniku, należy do ciebie. Następne lata po Newtonie, to był okres wielkiego rozkwitu matematyki i nauk stosowanych. Właściwie tak wielu było wybitnych uczonych, że wymienianie ich mija się z celem. Jest tak również i dzisiaj. A bierze się to właśnie z tej, wymienionej przeze mnie cechy Europejskiej cywilizacji, iż wiedza jest katalogowana, poszczególne prawa są “udowodnione”, a poprzez katalogowanie w postaci książek, wiedza ta nie jest raz za razem odkrywana na nowo, lecz jej rozwój jest progresywny, i stale jest dodawane coś nowego. Dotyczy to praktycznie każdej dziedziny życia, nie tylko nauk ścisłych. Więc oto misją każdego uczonego było dodać coś nowego od siebie do tego katalogu. A łatwo jest dodać coś, opierając się na tym, co już stworzono. Równocześnie więc postępuje stały postęp cywilizacyjny. W tamtych czasach “człowiek zaczął się chlubić swym rozumem”. Następuje też stałe oddalanie się wiary i nauki. Kanony wiary bowiem, zawarte w Biblii, nie korespondują zaprawdę, z tym co ludzie zaczęli odkrywać. To fakt bezsporny, że i dziś są tacy, którzy dosłownie interpretują wersety Biblii. Realnie jednak nie można interpretować sześciu dni Stworzenia świata przez Boga z trzynastoma miliardami lat istnienia świata. To jest, rzeczywiście, duży problem. Śmiem jednak twierdzić, że jest to głównie problem tych ludzi jednak, którzy umiarkowanie są zaopatrzeni w wiedzę. Tę wiedzę ścisłą. To trzeba tu powiedzieć, że nawet ludzie mądrzy i o szerokich horyzontach, ale głównie humaniści, nie umieją dostrzec Dzieła Stworzenia na świecie, odrzuca ich bowiem wszechobecne zło, dodatkowo widzą to, że święte księgi tak mocno mijają się z prawdą. To jest ta mieszanka wybuchowa dla nich, odrzucająca ich niczym granat rozbryzgowy od wiary w Duchowe. Rozwój mechaniki klasycznej i jej różnorodnych aspektów następuje gwałtownie. Powstaje formalizm Lagrange’a, opracowany przez słynnego Eulera i Lagrange’a, który opiera się na zasadzie wariacyjnej, w której argumentami nie są zmienne tylko odpowiednie funkcje. Oblicza się w nim więc ekstrema nie funkcji tylko funkcjonałów (funkcje są argumentami [a nie wartości liczbowe] tychże funkcjonałów).

Formalizm Lagrange’a wynika z prostej Zasady Najmniejszego Działania Hamiltona i ma szerokie zastosowanie tam zwłaszcza, gdzie równania Newtona są mało przydatne. Chodzi tu głównie o przypadek, gdy ruch ograniczony jest w układzie o jakieś więzy, a zwłaszcza wtedy, gdy nie mamy dobrych współrzędnych kartezjańskich. Wtedy uogólnione współrzędne formalizmu Lagrange’a zdają doskonale egzamin i wtedy równania tego formalizmu, czyli równania Lagrange’a i Eulera doskonale opisują dane zagadnienie. Jakie to mogą być te uogólnione współrzędne? Na przykład cylindryczne lub biegunowe. Właściwie dowolne. Okazuje się, że schemat i postać równań Lagrange’a we wszystkich nich jest taki sam. To jest właśnie wielki walor tego formalizmu. Równania Newtona opisujące układ odniesienia, diametralnie zmieniają się, gdy przechodzi się na inne niż kartezjańskie współrzędne. Równania formalizmu Lagrange’a są niemal identyczne, dlatego mówi się w tym przypadku o uogólnionych współrzędnych i uogólnionych prędkości, czyli że może to być dowolny typ współrzędnych. Kolejnym krokiem był formalizm Hamiltona, jest to praktycznie ukoronowanie formalizmu w mechanice klasycznej. W mechanice Hamiltona operuje się tak zwanymi współrzędnymi kanonicznymi. Są to uogólnione pędy oraz uogólnione współrzędne położenia. Formalizm i mechanika Hamiltona wynika niejako z formalizmu Lagrange’a. Oczywiście, mechanika Hamiltona jest równoznaczna z mechaniką Newtona, ale ma zastosowanie w układach bardziej złożonych. Można też podkreślić to, że formalizm Hamiltona stał się punktem wyjścia formalizmu mechaniki kwantowej. W międzyczasie, wraz z rozwojem mechaniki klasycznej, wraz z wszystkimi jej odcieniami, które pokazały się na przestrzeni XVII i XIX wieku, powstały zupełnie nowe gałęzie fizyki, o których i Galileuszowi, i samemu

Newtonowi się ani śniło. Jeśli za czasów pionierów fizyki znano jedynie dwa rodzaje sił, to jest siłę grawitacji i siły mechaniczne, to jednak już później, to jest w XVIII poznano nowy typ sił, czyli siły elektryczne i magnetyczne. Jeśli być precyzyjnym, to już w starożytności znano manifestację sił elektrycznych. Bowiem zauważono wtedy, że pocierając bursztyn, ten bursztyn nabierał przedziwnych właściwości, przyciągał on bowiem lekkie przedmioty, ale wiedza na ten temat nie została gruntownie rozwinięta. Ta praca, ta publikacja, nie rości sobie prawa do tego, aby być uznawana jako kompletnym przewodnik po fizyce od czasów starożytnych do doby współczesnej, dlatego nie będę tu rozwijał tematów związanych z elektromagnetyzmem, termodynamiką czy z innymi działami, równie cennymi, fizyki. Ten fragment związany z rozwojem mechaniki klasycznej od czasów Arystotelesa do praktycznie apogeum tego działu, jakim jest formalizm Hamiltona, podjąłem tylko w tym celu, aby ci pokazać, Szanowny czytelniku, w jakich warunkach rósł cały ten czas kilku wieków niemal kult Determinizmu, Racjonalizmu, Materializmu i Mechanicyzmu. Moim bowiem celem w tej książce będzie między innymi obalenie tych paradygmatów w nauce, w fizyce. A zrobię to, już wyprzedzę nieco treść, w oparciu o mechanikę kwantową. Jak każdy nauczyciel tłumaczy w szkole, mechanika klasyczna jest w pełni Deterministyczna. Jest to mechanika opisana za pomocą liczb i funkcji Rzeczywistych. Można powiedzieć, że odpowiada ona Poziomowi Mierzalnemu (Poziomowi Rzeczywistemu). Jeśli się zastanowisz trochę głębiej, Szanowny czytelniku, to przyznasz, że każdy pomiar dokonuje się poprzez podanie określonych, zmierzonych wartości liczb Rzeczywistych, a ściślej jeszcze poprzez podanie wartości liczb wymiernych, bowiem przecież nie można podać wartości liczb niewymiernych. Dlatego też między innymi nazywam ten poziom, Poziomem Mierzalnym. Przecież nasze zmysły, pięć podstawowych (przyjmijmy klasycznie), to są takie nasze wewnętrzne urządzenia pomiarowe, które też podają na wyjściu wartości liczb Rzeczywistych, które potem interpretuje nasz mózg. A my w końcu tego procesu widzimy, słyszymy i czujemy. Podobnie działa Poziom Mierzalny. Jednak teraz na koniec tego rozdziału zastanów się, Czytelniku, czy istnieje jeszcze jakiś inny poziom, w którym przejawia się jakoś świat? Czy może Poziom Mierzalny to jest wszystko, co możemy powiedzieć o percepcji świata? Właśnie taka opinia panowała aż do pojawienia się mechaniki kwantowej, a właściwie wskutek bezwładności intelektualnej panuje do dziś. Jest to więc kolejny ważny i istotny problem, który rozpatruje i analizuje w miarę precyzyjnie ta publikacja. Uprzedzając nieco treść książki, spróbuję tu przedstawić i “rozwiązać” (potraktuj to, Czytelniku, w dużym cudzysłowie) kilka bardzo ważnych problemów nauki, które łącznie, niejako emergentnie określą nową fizykę, fizykę Indeterministyczną, ezoFizyke, fizykę opartą na dwóch poziomach. Na Poziomie Mierzalnym (albo jak kto lubi Poziomie Rzeczywistym) i na Poziomie Wirtualnym (inaczej Poziomie Niemierzalnym). Po pierwsze, określam tu ontologiczny sens istnienia liczb i funkcji zespolonych. Twierdzę, że sens ten polega na tym, iż są to narzędzia, ale teraz podległe tylko rozumowi, do badania (rozumem a nie empirią) Ukrytego Porządku, do badania tegoż Poziomu Wirtualnego. Po drugie, przedstawię tu prawidłową i formalną definicję Przyczynowości, czyli Prawa Przyczynowo — skutkowego. Przy tej okazji, zdefiniuję w sposób formalny Determinizm i Indeterminizm. Nakreślę nową i spójną interpretację mechaniki kwantowej, tak zwaną Interpretację Dwóch Poziomów percepcji świata, to jest Poziomu Mierzalnego I Poziomu Wirtualnego. To wszystko razem, zmusi cię, Szanowny czytelniku, do przewartościowania swojej, być może, postawy sceptycznej, a nawet ateistycznej. Zmusi cię do uznania Duchowego, jako do tego samego centrum, Jądra, Kernela, istniejącego Świata. Tego z czego Wszystko wynika.

Formalizm Zespolony

Chciałbym teraz skupić się na tym problemie i zagadnieniu, które, oprócz jeszcze tylko części dotyczącej formalnej postaci Prawa Przyczynowości, jest najważniejszą częścią tej książki. Chodzi tu o formalizm zespolony. Co ciekawe, to, co ja będę chciał tu poruszyć, nie jest akcentowane w żadnej książce czy to o matematyce, czy o tematyce nauk ścisłych. O liczbach zespolonych prawie każdy słyszał. Kojarzy się ona z wyższą matematyką, ale czy jest tak doprawdy? Każdy, kto rozwiązywał równania algebraiczne, czyli większość społeczeństwa, bo przecież uczą tego już w szkołach podstawowych, musiał się zetknąć z taką sytuacją, że dane równanie algebraiczne nie ma rozwiązania w zbiorze liczb Rzeczywistych. I co wtedy? No wtedy, jakiś kolega lub koleżanka, a może nauczyciel podpowiada nam: wiesz, nie ma rozwiązania w zbiorze liczb Rzeczywistych, jednakowoż jest rozwiązanie tego równania, ale w zbiorze liczb Zespolonych. Ogólnie znane jest tak zwane: Zasadnicze Twierdzenie Algebry, które udowodnił jako pierwszy Gauss na przełomie XVIII i XIX wieku. Tak, już wtedy znano formalizm zespolony. Twierdzenie to ogólnie można streścić do takiej dość prymitywnej postaci, że każde równanie algebraiczne ma rozwiązanie w zbiorze liczb Zespolonych. Czyli innymi słowy, jeśli mamy równanie czwartego stopnia, to ma cztery rozwiązania, piątego stopnia ma pięć rozwiązań w tym zbiorze, itd. W ogólności to chodzi o wielomiany, ale nie ma to większego dla nas znaczenia. Co ma znaczenie? Proste stwierdzenie, że tam, gdzie nie pomagają liczby Rzeczywiste, tam świetnie sprawdzają się liczby Zespolone. Albo inaczej jeszcze, jeśli liczby Rzeczywiste sprawdzają się do pewnej “ściany” zagadnienia, to liczby Zespolone będą się sprawdzać także za tą ścianą. To jest bardzo ważne, co przed chwilą napisałem. Właściwie powinienem to podkreślić i umieścić w pewnej ramce, praktycznie w złotej ramce. To jest jedno z najważniejszych sformułowań tej książki, a które można sformułować jeszcze tak: formalizm Zespolony pozwala zbadać i dotrzeć w głęboko ukryty porządek, do którego nie ma dojścia poprzez formalizm liczb Rzeczywistych. Oczywiście, analizując to zagadnienie nieco dokładniej, to mamy tu do czynienia nie z samymi liczbami, ale ze zbiorami liczb spełniającymi określone warunki matematycznie, a które nazywa się Ciałami. Mamy więc Ciało liczb Rzeczywistych, które oznacza się dużą literą R, oraz ciało liczb Zespolonych, określane dużą literą C. To są odpowiednie zbiory liczbowe z określonymi działaniami na tych zbiorach. Dla pewnej prostoty można stwierdzić, że te działanie w tych ciałach są identyczne należy jednak pamiętać o pewnym warunku. Aby to wyjaśnić trzeba się tu będzie wrócić, wrócić do podstawy, jakie to są te liczby Zespolone, jak one wyglądają, z czym to się je (bo przecież każdy wie, jak wyglądają liczby Rzeczywiste)? Postać liczb zespolonych przedstawia się tak:

a+ib=z

Gdzie a i b to są zwykłe liczby rzeczywiste. Chodzi jednak o to “i”. Co to jest właściwie “i”? “i” to jest taka liczba, która spełnia następujący warunek:

i²=i·i=-1

Czyli innymi słowy kwadrat “i” równa się minus jeden. Nie jest jednak prawdą, co przyjmuje się w wielu publikacjach, że

i=⎷-1

Jest to błąd, który można łatwo wykazać, bowiem jeśli i=⎷-1, to wtedy

i²=i·i= (⎷-1)(⎷-1)= ⎷(-1)⠂(-1)=⎷1=1 lub -1, co jest sprzeczne z założeniem

Żeby to werbalnie objaśnić. “i” razy “i”, z założeniem, że “i” to się równa pierwiastek z minus jeden, to znaczy, że pierwiastek z minus jeden razy pierwiastek z minus jeden, to jest pierwiastek z iloczynu minus jeden razy minus jeden, co przecież daje jeden pod pierwiastkiem, czyli to jest pierwiastek z jeden, czyli to jest sprzeczne z założeniem, że “i” razy “i” to się równa minus jeden i tylko minus jeden. Co jest dowodem nie wprost, że i≠⎷-1. Dlatego bezpieczniej jest zakładać warunek na “i”, że i²=i·i=-1

Ogólnie należy powiedzieć, że taka postać liczb zespolonych, czyli a+ib=z, zawiera w swojej konstrukcji liczby Rzeczywiste, to jest “a” oraz liczby nazywane w literaturze liczbami urojonymi postaci ‘”ib”. Właściwe jest jednak zauważyć, że te liczby, jakoby urojone( imaginare), to nie są żadne liczby urojone, tylko to jest nowy typ liczb. Tak jak znamy ze szkoły podstawowej liczby: Naturalne, Całkowite, Wymierne i Niewymierne, czyli wszystko to są liczby Rzeczywiste. Tak liczby postaci “ib” to jest nowy rodzaj liczb, który można nazwać liczbami nieRzeczywistymi. Okazuje się, że dopiero całkowite spektrum liczb Rzeczywistych i liczb nieRzeczywistych daje pełne spektrum liczb, potrzebnych nam, aby opisać fizykę zjawisk, pełną fizykę zjawisk. Czyli innymi słowy same liczby Rzeczywiste nie pozwalają nam opisać całej fizyki zjawisk. Teraz tylko jako dygresję dodam, że liczby Rzeczywiste wystarczają tylko do opisu zjawisk z Poziomu Mierzalnego. Aby jednak dotrzeć do Poziomu Wirtualnego, tego głębszego i opisać zjawiska z tego poziomu potrzebujemy tego całego spektrum liczb, które zawiera zarówno liczby Rzeczywiste jak i te nieRzeczywiste (urojone). To właśnie te liczby nieRzeczywiste są powodem, że formalizm liczb Zespolonych (i funkcji zespolonych) pozwala wniknąć za tę ścianę, tę zasłonę, za którą same liczby Rzeczywiste nie wystarczają. Teraz, niejako podam w przedbiegach, bo będę to opisywać nieco dalej, iż ta ściana, ta zasłona, którą już kilkakrotnie przywoływałem, to jest głównie granica pomiędzy tymi poziomami. Pomiędzy Poziomem Mierzalnym i Poziomem Wirtualnym (Poziom Niemierzalny). Koncepcja liczb nieRzeczywistych bardzo ładnie przedstawia się w formalizmie kwaternionów. Przy czym tam mamy do czynienia aż z trzema różnymi typami liczb nieRzeczywistych, odpowiednio ze sobą powiązanych. Jeśli ogólna postać kwaternionów to: z= a +ib+jc+kd, gdzie a,b,c,d są liczbami Rzeczywistymi,

to i²=j²=k²=-1, a także te nowe typy liczb nieRzeczywistych powiązane są dodatkowo: ij=k; jk=i; ki=j, oraz i≠j≠k≠ ⎷-1

Takie formy matematyczne jak kwaterniony wyraźnie mówią nam, że typów liczb nieRzeczywistych może być wiele. Jednak wydaje się, że liczby i funkcje zespolone, oparte tylko na jednym typie liczb nieRzeczywistych w swojej strukturze już całkowicie wystarczą do opisu całej fizyki. Dlaczego tak jest? Z prostego powodu. Okazuje się Natura lub Opatrzność jest w tym względzie minimalistyczna. Działa najprościej jak to może być. Mamy więc Zasadę Najmniejszego Działania, mamy tylko trzy wymiary przestrzenne, mniej już nie może być, więcej tak, ale to już jest naddatek pomijany przez Naturę, który nie jest realizowany, no i mamy liczby zespolone z tylko jednym typem liczb nieRzeczywistych. Oczywiście, jest też teoria strun z jej dziesięcioma wymiarami, ale zostawmy tę teorię w naszym opracowaniu w spokoju. Oczywiście, są liczby zespolone i są kwaterniony ze swoimi trzema typami liczb nieRzeczywistych. Są też oktoniony, sedeniony, itd.,które w swej strukturze mają jeszcze więcej typów liczb nieRzeczywistych, ale okazuje się z historii matematyki i nauk ścisłych, że ani kwaterniony, ani jeszcze bardziej wymyślne formy nie zyskały takiego znaczenia jak liczby i funkcje zespolone. Właśnie chyba dlatego, że Natura (Opatrzność) jest minimalistyczna, czego dowodów w nauce jest bez liku. Twórca kwaternionów i formalizmu z nimi związanego słynny fizyk i matematyk Hamilton, ten sam od Hamiltonianu układów fizycznych i od formalizmu Hamiltona mechaniki klasycznej, był przeświadczony, że to odkrycie (kwaternionów) jest największym jego odkryciem i wkładem do nauki. Niestety historia zweryfikowała nieco ten pogląd, bowiem fizycy zaczęli potem stosować nieco prostsze formy matematyczne, takie jak, iloczyn skalarny, dywergencja, rotacja i iloczyn wektorowy, i okazało się, że bez kwaternionów teoria jest bardziej przejrzysta. Niemniej kwaterniony jednak się ostały, i to nie tylko jako ciekawostka, bowiem mają teraz głównie zastosowanie w grafice komputerowej 3D i w podobnych projektach. Niektórzy teoretycy twierdzą wręcz, że przyszłość będzie jednak należała do kwaternionów. No cóż, pożyjemy, zobaczymy. Powróćmy jednak do liczb zespolonych. Otóż działania na liczbach zespolonych są takie same jak działania w zbiorze liczb Rzeczywistych, trzeba jednak zawsze uwzględniać ten warunek, że: i²=-1, i tak jeśli mamy dwie liczby zespolone z1= a1 + ib1, oraz liczbę z2=a2 + ib2, to ich iloczyn i suma będą się tak przedstawiały

z= z1+z2= (a1+a2) + i(b1+b2)

z= z1 · z2 =(a1+ib1)(a2+ib2)= a1a2 — b1b2 + i(a1b2+a2b1)

Podobnie konstruujemy pozostałe działania. W przypadku kwaternionów, oktonionów, itp., sytuacja jest analogiczna, trzeba jednak zawsze pamiętać o tych warunkach jakie są podane i trzeba je respektować.

Naprawdę, zastanawiający jest ten fakt, że formalizm zespolony, który był już wałkowany przez wielu wybitnych matematyków i fizyków i to od co najmniej trzech stuleci, nie nasunął tym wszystkim teoretykom pomysłu, po co w ogólności powstały i po co są te liczby i funkcje zespolone? Jaki jest ontologiczny sens tych liczb? Wszyscy doskonale poznali potęgę tych liczb, działania na tych liczbach i funkcjach. Ale nikt nie pokusił się na określenie tego sensu. A przecież wiadomo to niemal od Pitagorasa i od Związku Pitagorejczyków, że liczby- wtedy znane były tylko Rzeczywiste liczby- mają głęboki sens ontologiczny, one opisują zjawiska tego świata, jego proporcje. Oczywiście, są też tacy, którzy nie podzielają tego zdania. I chyba właśnie tacy ludzie zajmowali się głównie formalizmem zespolonym. Oni się tym formalizmem bawili, napawali i przy okazji rozwiązywali niektóre problemy, głównie matematyczne. Czyż nie piękne jest takie równanie, zwane równaniem Eulera? Powiadają, że jest to najpiękniejsze i najdoskonalsze równanie matematyczne, wiążące dwie główne liczby niewymierne (“π” i “e”) z liczbą “i” (urojoną), oraz z zerem i jednością:

exp(iπ)+1 =0

Tylko co z tego wynika? Chyba tylko dobra zabawa. Prawda zaś jest taka, że formalizm zespolony służy jednak do opisu fizyki, i taki jest jego ontologiczny sens. Służy jednak głównie do opisu fizyki za tą ścianą lub kurtyną, która przedziela Poziom Mierzalny i Poziom Wirtualny. Ten formalizm służy do opisu fizyki Ukrytego Porządku. Pewne jest jednak to, że do odkrycia mechaniki kwantowej nikt nie mógł być tego świadomym i dlatego nie kojarzono tych elementarnych zależności, to fakt niezaprzeczalny, ale minęło już prawie sto lat od powstania tejże, a dotąd jeszcze nikt nie pokusił się o taką interpretację. Wydaje się to mocno zastanawiające. Na zakończenie małą zagadka. Z czym, Szanowny czytelniku, kojarzy ci się ten wzór? :

Z= i⍵L + R

Oczywiście masz rację, z jakimś ukrytym porządkiem, bo jest tam liczba “i” w tym wzorze. Ściślej jest to wzór na Impedancję (Z) układu elektrycznego połączonych ze sobą szeregowo opornika (R) i cewki (L).

A ten wzór:

ih𝜕/𝜕t(𝛙) = 𝓗𝛙

I o tym jest ta publikacja.

Ten wstęp o liczbach i funkcjach zespolonych, czyli funkcjach, których argumentami są liczby zespolone, jest konieczny, aby mniej więcej zorientować się, co autor, czyli ja, “miał na myśli” pisząc tę całą publikację. Ten fragment oraz fragment dotyczący Przyczynowości (Prawa Przyczynowo skutkowego), ośmielę się zauważyć, tworzy praktycznie nową fizykę i nową jej interpretację. Nie są to, oczywiście, odkrycia na miarę OTW Einsteina czy Zasad Dynamiki Newtona. Bo przecież, to o czym ja piszę, każdy człowiek, fizyk może sam wydedukować. Nie musi tworzyć nowej matematyki, co jednak uczynił Newton (rachunek całkowy), nie musi tworzyć nowych koncepcji czasu i przestrzeni, co uczynił Einstein. Wystarczy zwykła logika i materiał wałkowany przez ogół fizyków od wielu lat. Tak wałkowany, że praktycznie nikt dotąd nie pokapował się w czym rzecz. Jedyne, co sobie przypisuję jako odkrycie, to sformułowanie formalnych postaci wzorów Determinizmu i Indeterminizmu (Przyczynowości). Reszta z tego właśnie wynika. Określenie mojej teorii zajęło mi dobrych kilkanaście lat, może więcej, a ta publikacja jest tego finalnym efektem. Jako fizyk amator najbardziej zafascynowany jestem mechaniką, a ogólnie fizyką, kwantową i teoriami pobieżnymi. Bo właściwie formalizm kwantowy opisuje nam całość “rzeczywistości” i tą jawną, i tą ukrytą. Może to teraz tajemniczo brzmi i nie będę to teraz szczegółowo tłumaczył, ale jedno, co powiem, to to, że koncepcja liczb nieRzeczywistych oraz koncepcja Przyczynowości mają decydujące znaczenie w tym opisie. Mówi się, że OTW Einsteina oraz mechanika kwantowa są wzajemnie sprzeczne. Pierwsza opisuje świat w skali makro, a druga w skali mikro. Ja znam jeszcze jedną różnicę między tymi teoriami, której jasność przedstawi ci się, Szanowny czytelniku, po przeczytaniu całej publikacji. Teraz tylko powiem, iż mechanika kwantowa w dużej mierze bazuje się na koncepcji Ukrytego Porządku (Poziom Wirtualny), a OTW jest teorią “tylko” z pozycji naszej zwykłej Rzeczywistości (Poziom Mierzalny). I śmiem twierdzić, na tym polega ten cały “konflikt” pomiędzy tymi fundamentalnymi teoriami. Ja optuję za mechaniką kwantową, ale to nie znaczy, że OTW (Ogólna Teoria Względności) jest błędna. Skala macro bowiem pozwala “pominąć” wpływ Ukrytego Porządku na fizykę zjawisk. A skala mikro wręcz bazuje na nim (na Ukrytym Porządku), choć współcześni fizycy “nie są tego jeszcze świadomi”. Czy więc obie teorie da się pogodzić? Jak dotąd się nie dało. Być może brak świadomości działania Ukrytego Porządku, powszechna na tę chwilę, blokowała taki związek pomiędzy tymi teoriami. Z drugiej strony OTW jest skrajnie Deterministyczna, jak mówią fizycy: deterministyczna w duchu Spinozy. A mechanika kwantowa i wszystkie teorie bazujące na formalizmie kwantowym są Indeterministyczne. To jak woda i ogień. A Determinizmu i Indeterminizmu nijak nie da się pogodzić. Stąd ta wzajemna sprzeczności między tymi teoriami. W ogólności warto zauważyć i to, że praktycznie wszystkie teorie z Poziomu Rzeczywistego (Mierzalnego) są Deterministyczne.

Prawo Przyczynowo skutkowe (Przyczynowość)