Błażej Kotowicz

AI dla kreatywnych

© Błażej Kotowicz

Książka jest objęta ochroną prawa autorskiego. Wszelkie udostępnianie osobom trzecim, upowszechnianie i upublicznianie, kopiowanie oraz przetwarzanie jest nielegalne i podlega właściwym sankcjom.

Książka z dedykacją dla Marceliny za nieustanną wiarę we mnie i za inspirację

Prolog

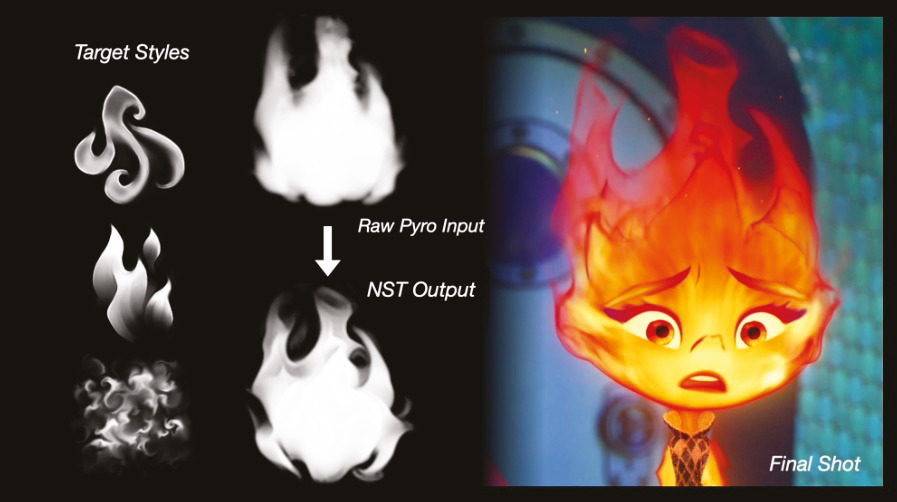

W świecie animacji komputerowej, gdzie technologia i sztuka nieustannie się przenikają, studio Pixar zawsze wyznaczało nowe standardy. Przy tworzeniu filmu „Między nami żywiołami” reżyserii Petera Sohna, zespół stanął przed wyjątkowym wyzwaniem: jak realistycznie przedstawić żywioły w ludzkiej postaci?

Artyści ze słynnego studia Pixar w Emeryville w Kalifornii zastanawiali się, jak uchwycić eteryczną naturę ognia na ekranie. Jak miałoby działać cielesne ciało z wody? Czy postać miałaby być przezroczysta? Ognista natura jednej z głównych postaci, Ember, okazała się być naprawdę dużym wyzwaniem dla animatorów studia. Chociaż posiadali narzędzia do tworzenia symulacji płomieni, w tym przypadku niestety nie przynosiły one oczekiwanych rezultatów. Istniało ryzyko, że efekt końcowy mógłby bardziej przypominać przerażającego Ghost Ridera niż przyjazną postać z filmu animowanego.

Peter Sohn, który był inspiracją przy tworzeniu postaci Russela z filmu „Odlot” (do którego sam podkładał głos), wciąż szukał sposobu na stworzenie czegoś, co będzie rozpoznawalne jako ogień. „Ogień jest naturalnie bardzo dynamiczny, ale jeśli go spowolnić, może zamienić się w coś, co wygląda jak plazma” — zauważył.

Kanyuk, specjalista od symulacji tłumów pracujący w Pixarze od 2005 roku, wpadł na nowatorski pomysł.

Doświadczenie zdobyte przy pracy nad filmem „Ratatuj”, gdzie zmagał się z problemem prawidłowej symulacji ubrań w dużych tłumach, skłoniło go do dołączenia do organizacji Association for Computing Machinery’s Siggraph, zajmującej się rozwojem grafiki komputerowej. Około 2016 roku odkrył badania grupy nad wykorzystaniem uczenia maszynowego do doskonalenia symulacji ubrań i od tego czasu starał się opanować tę technologię.

Przełom nastąpił około 2019 roku, gdy Kanyuk natknął się na artykuł z konferencji Siggraph Asia o wykorzystaniu neural style transfer (NST) — rodzaju sztucznej inteligencji używanej do nadawania zdjęciom stylu znanych artystów, takich jak Van Gogh czy Picasso. Technika ta pozwalała na przesuwanie wokseli (trójwymiarowych odpowiedników pikseli) w animacji, co umożliwiało nadanie postaci określonego wyglądu. Kanyuk uznał, że NST może być kluczem do rozwiązania problemu animacji płomieni, choć ocenił szanse powodzenia na około 50 procent.

„Powiedziałem Sohnowi: »Dam ci pięć pomysłów i może dwa z nich zadziałają«. Sohn odpowiedział: »Zróbmy je wszystkie!«” — wspominał Kanyuk.

Aby zrealizować swój plan, Kanyuk zwrócił się o pomoc do Disney Research Studios, laboratorium z siedzibą w Zurychu, specjalizującego się w badaniach nad sztuczną inteligencją i uczeniem maszynowym. Pixar współpracował już wcześniej z tym studiem przy produkcji „Toy Story 4”. Do projektu dołączył Jonathan Hoffman, artysta, który stworzył zestaw wirujących, spiczastych i niemal kreskówkowych płomieni, nazwanych przez zespół „fleur-de-lis”.

Wykorzystując technikę NST, zespół mógł połączyć te stylizowane płomienie z gęstszym ogniem z oryginalnej symulacji. Efekt był zdumiewający — udało się uzyskać ruch i intensywność ognia, złagodzone charakterystycznym dla Pixara stylem animacji.

Dla Sohna to innowacyjne podejście stanowiło okazję do stworzenia filmu, który nie tylko wyglądałby tak, jak sobie wymarzył, ale także oferowałby widzom coś, czego nigdy wcześniej nie widzieli. Jak sam podkreślił, symbolizowało to jedną z rzeczy, które najbardziej ceni w Pixarze: „spotkanie sztuki i technologii, gdzie ta ostatnia jest ważną częścią procesu, ale tylko jednym z elementów”.

„To połączenie lewej i prawej półkuli mózgowej oraz wykorzystanie technologii jako narzędzia do wyrażania emocji” — wyjaśnił Sohn, podkreślając holistyczne podejście studia do tworzenia animacji.

Kanyuk, patrząc w przyszłość, stwierdził: „Pixar wciąż »drapie powierzchnię« tego, co może zrobić NST. Jestem bardzo podekscytowany, że znaleźliśmy sposób na wykorzystanie tej technologii w filmie »Między nami żywiołami«, co pozwoliło wznieść naszą twórczość na wyższy poziom.”

Przypadek „Między nami żywiołami” pokazuje, jak sztuczna inteligencja i uczenie maszynowe mogą rewolucjonizować branżę animacji, umożliwiając twórcom realizację coraz bardziej ambitnych wizji artystycznych. Jednocześnie historia ta podkreśla, że nawet w erze zaawansowanych technologii, to ludzka kreatywność i innowacyjność pozostają kluczowymi czynnikami w procesie twórczym.

Terminator powrócił

Poczucie zagrożenia od zawsze towarzyszyło w branży filmowej wraz z pojawieniem się nowych technologii potrafiące z czasem wywrócić cały przemysł. Najsilniejsi okazywali się Ci, którzy dostrzegli szansę oraz potrafili efektywnie wprowadzić nowe rozwiązania do filmu.

Jednym z pierwszych zagrożeń dla wczesnego kina niemego był oczywiście dźwięk. Walt Disney ujrzał wielką szansę w oscylatorze dźwiękowym pewnej małej firmy. Hewlett-Packard. Zakupił osiem sztuk modelu 200B do testów systemu Fantasound. Czyli pierwszego na świecie systemu wielokanałowego kina dźwiękowego i został po raz pierwszy użyty do stworzenia dźwięku przestrzennego w filmie „Fantazja” w 1940 roku.

Chociaż sam system był za drogi dla kin. To otworzył bramę do znacznie usprawnionej technologii tamtych czasów. CinemaScope. Gdyby nie intuicja, odwaga oraz spryt inżynierów Walt Disney Studio. To być może nie zanurzalibyśmy się w dzisiejszych salach kinowych pełnych przestrzennych dźwięków jak 64 kanałowy Dolby Atmos.

W 1922 roku, w kinie Rialto Theatre w Nowym Jorku, miał swój pierwszy pokaz film „Toll of the Sea” — pierwsza kolorowa produkcja z Hollywood. Wyprodukowany przy użyciu drogiej techniki Technicolor, film zyskał uznanie za intensywność i nasycenie kolorów. Od premiery w Rialto Theatre aż do 1955 roku, Technicolor był prekursorem w swojej dziedzinie, ukazując kolorowy i baśniowy świat „Królewny Śnieżki i siedmiu krasnoludków” oraz zachwycający musical „Deszczowa piosenka”. Filmy te pokochały widzowie, a ich sukces w historii kinematografii był w dużej mierze zasługą rewolucyjnych barw Technicolor.

Lata 80’ przygotowały dla nas. Widzów oraz i twórców. Zachwycające możliwości grafiki CGI.

Przemysł filmowy początkowo miał pewne obawy związane z wprowadzeniem grafiki CGI (Computer Generated Imagery), ale szybko zrozumiano jej ogromny potencjał. CGI umożliwiła tworzenie efektów specjalnych i wizualnych, które były wcześniej trudne do osiągnięcia. Dzięki rozwojowi tej technologii filmy stały się bardziej imponujące i realistyczne. Obecnie CGI jest powszechnie używane w przemyśle filmowym i jest kluczowym elementem produkcji filmów, a obawy związane z jej wprowadzeniem minęły.

Jest 3 lutego 1986 roku. Steve Jobs, po tym jak został wyrzucony z własnej firmy, szuka nowego pomysłu na biznes. Dostrzega potencjał w małej firmie rozwijającej grafikę komputerową — Pixar, należącej wówczas do George’a Lucasa, twórcy „Gwiezdnych Wojen”.

Lucas, nie widząc większych możliwości w tym dziale, który rozwijał raczej technologie komputerowe niż filmowe, odsprzedał firmę Jobsowi za 5 mln dolarów. Steve Jobs zainwestował kolejne 5 mln dolarów w nowo nabytą firmę.

Jak to często bywa, początkowe decyzje nie zawsze są udane. W 1985 roku, Pixar zarabiał na sprzedaży bardzo kosztownych i rzadko spotykanych komputerów o nazwie Pixar Image Computer. Były to stacje graficzne wyposażone w zestaw oprogramowania do renderingu, które kosztowały 125 tysięcy dolarów.

Pixar jednak miał dużo szczęścia, ponieważ Disney szukał nowych technologii, które popchnie animację do przodu. Współpraca między tymi firmami ostatecznie ruszyła, ale nie była jeszcze mocno zacieśniona. Do tego potrzebne były dwie osoby — Steve Jobs i John Lasseter, oryginalny twórca “Toy Story”.

Lasseter był naprawdę zdolnym filmowcem, kochał swoją pracę, kochał Pixar i świetnie rozumiał stworzoną przez firmę technologię. Kiedy Jobs zobaczył stworzoną przez niego krótką pokazówkę z lampką Luxo, stwierdził, że “to jest to” — dosyć z dalszymi próbami tworzenia i sprzedawania komputerów, pora wziąć się za robienie filmów.

Skoro współpraca między Pixarem a Disney-em się układała, Jobs postanowił poruszyć temat ewentualnego jej zacieśnienia na potrzeby oryginalnej produkcji. Disney dość szybko się zgodził, kiedy usłyszał, że nad filmem miałby pracować John Lasseter — tyle że sam zainteresowany był Pixarowi lojalny i nigdzie się nie wybierał, nawet jeśli miałoby to zwiększyć jego stawkę. Ostatecznie padła jednak propozycja, że właścicielem filmu zostanie Disney, zapewniając 12,5% profitu z zysków Pixarowi. I tak oto ruszyły prace nad Toy Story, pierwszą pełnometrażową animacją komputerową, która na zawsze odmieniła nasz sposób patrzenia na ten gatunek.

Quo vadis ai?

Czym jest Runway ML? Według ich własnych słów, Runway to firma zajmująca się badaniami nad sztuczną inteligencją, kształtująca następną erę sztuki, rozrywki i ludzkiej kreatywności. Jest w tym dużo prawdy. Jesteśmy aktualnie w nowej erze ludzkiej kreatywności i inwencji twórczej. Znacznie większej niż wynalezienie dźwięku czy nadanie barw taśmie filmowej.

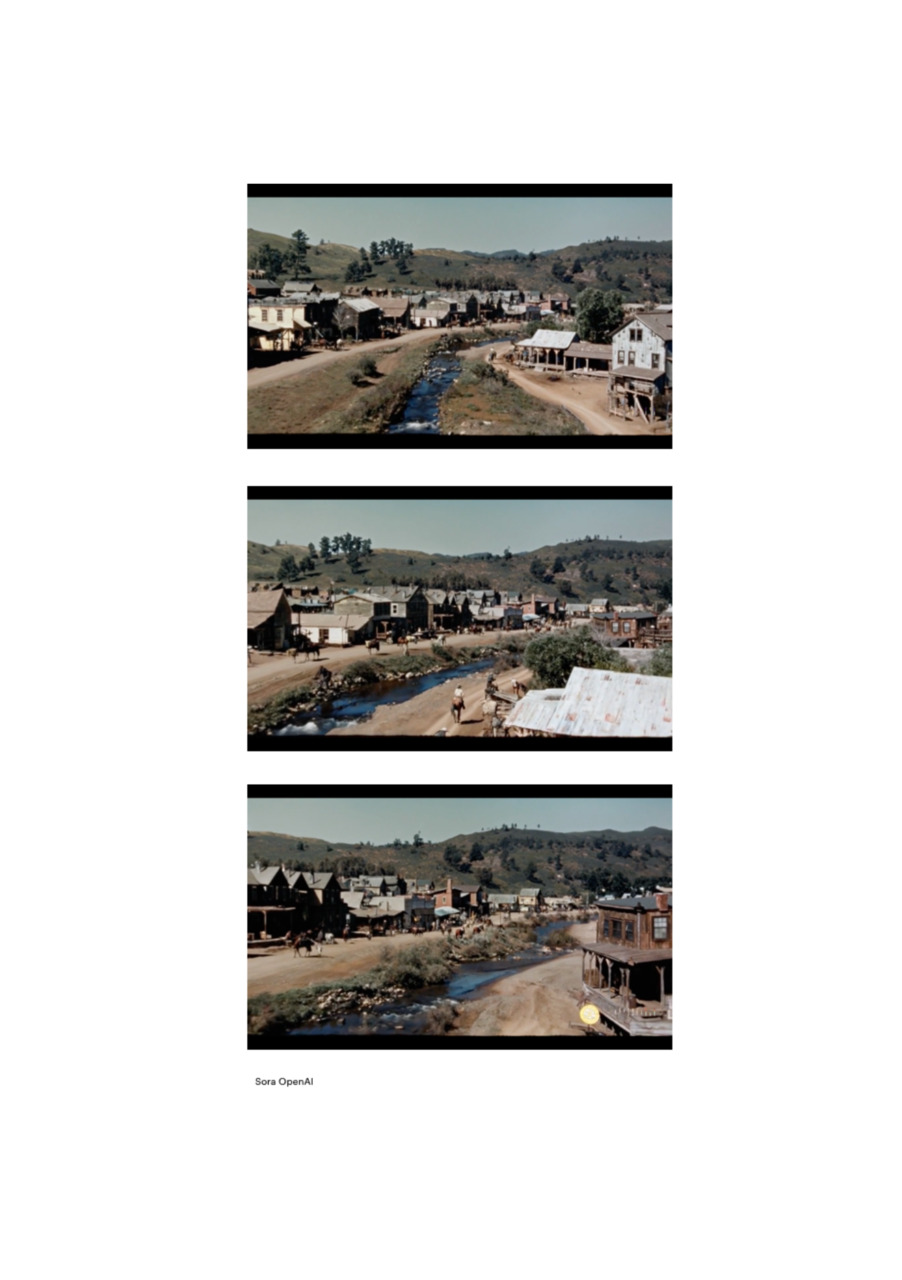

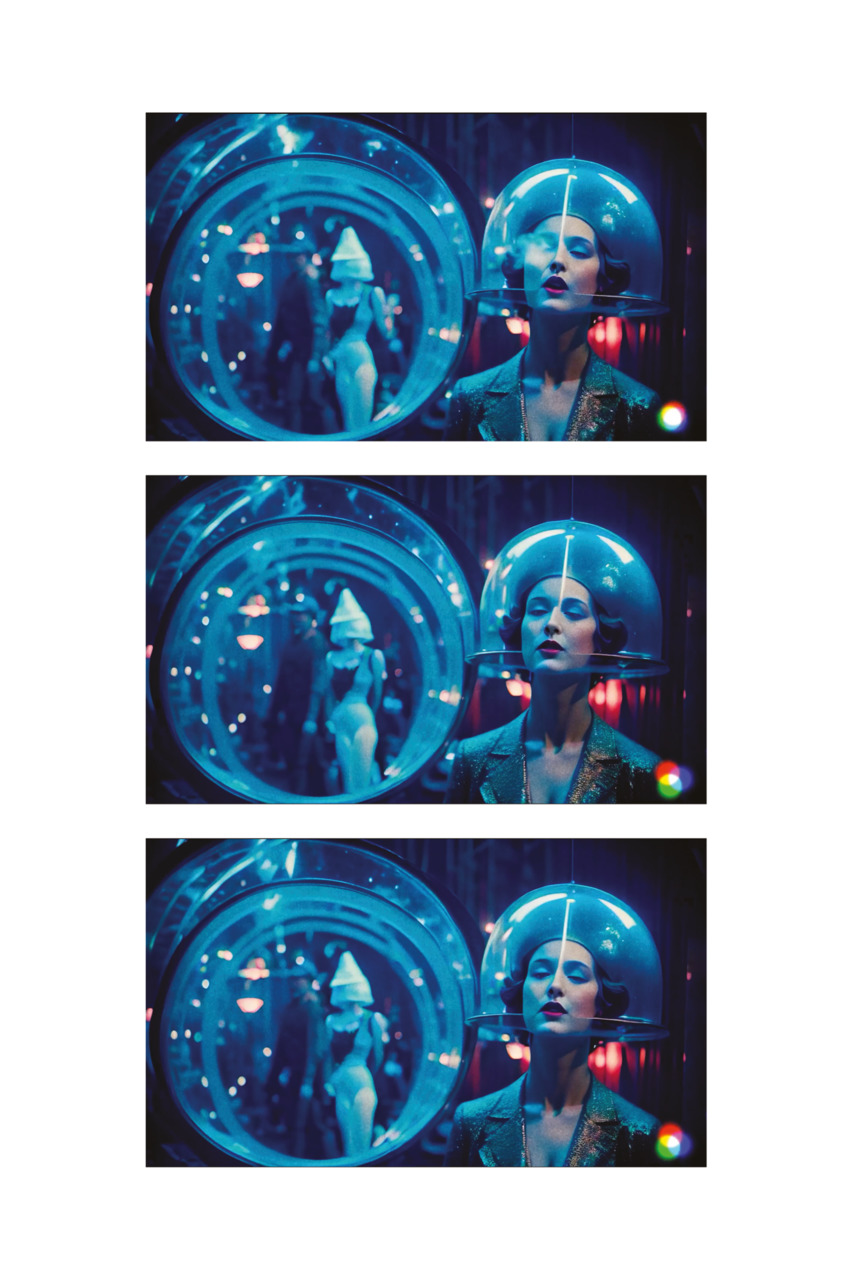

Rozwój technologii generatywnych, takich jak Runway ML, Pika Lab czy Sora od OpenAI, przynosi rewolucję w dziedzinie wizualnej narracji i animacji. Podobnie jak w 1896 roku, kiedy film braci Lumière „Wjazd pociągu na stację w La Ciotat” wywołał u widzów strach i zdumienie, tak nowoczesne modele AI mogą budzić podobne uczucia. To, co kiedyś wymagało długich godzin pracy i nauki, teraz może być wygenerowane w znacznie krótszym czasie, co z pewnością może budzić niepokój wśród profesjonalistów. Jednakże, podobnie jak kiedyś kino stało się nową formą sztuki i wyrazu, tak teraz sztuczna inteligencja otwiera nowe możliwości dla twórców.

Może to być okazja do eksploracji nowych horyzontów kreatywności, gdzie umiejętności animacji 3D mogą być połączone z AI, tworząc zupełnie nowe doświadczenia wizualne. Warto pamiętać, że narzędzia te są rozszerzeniem ludzkiej kreatywności, a nie jej zastępstwem.

Sztuczna inteligencja może służyć jako współtwórca, pozwalając na realizację wizji, które wcześniej byłyby niemożliwe do osiągnięcia lub wymagałyby ogromnych zasobów. Może to być początek nowej ery w sztuce i rozrywce, gdzie granice między rzeczywistością a fikcją stają się coraz bardziej płynne, a możliwości wyrazu artystycznego — niemal nieograniczone.

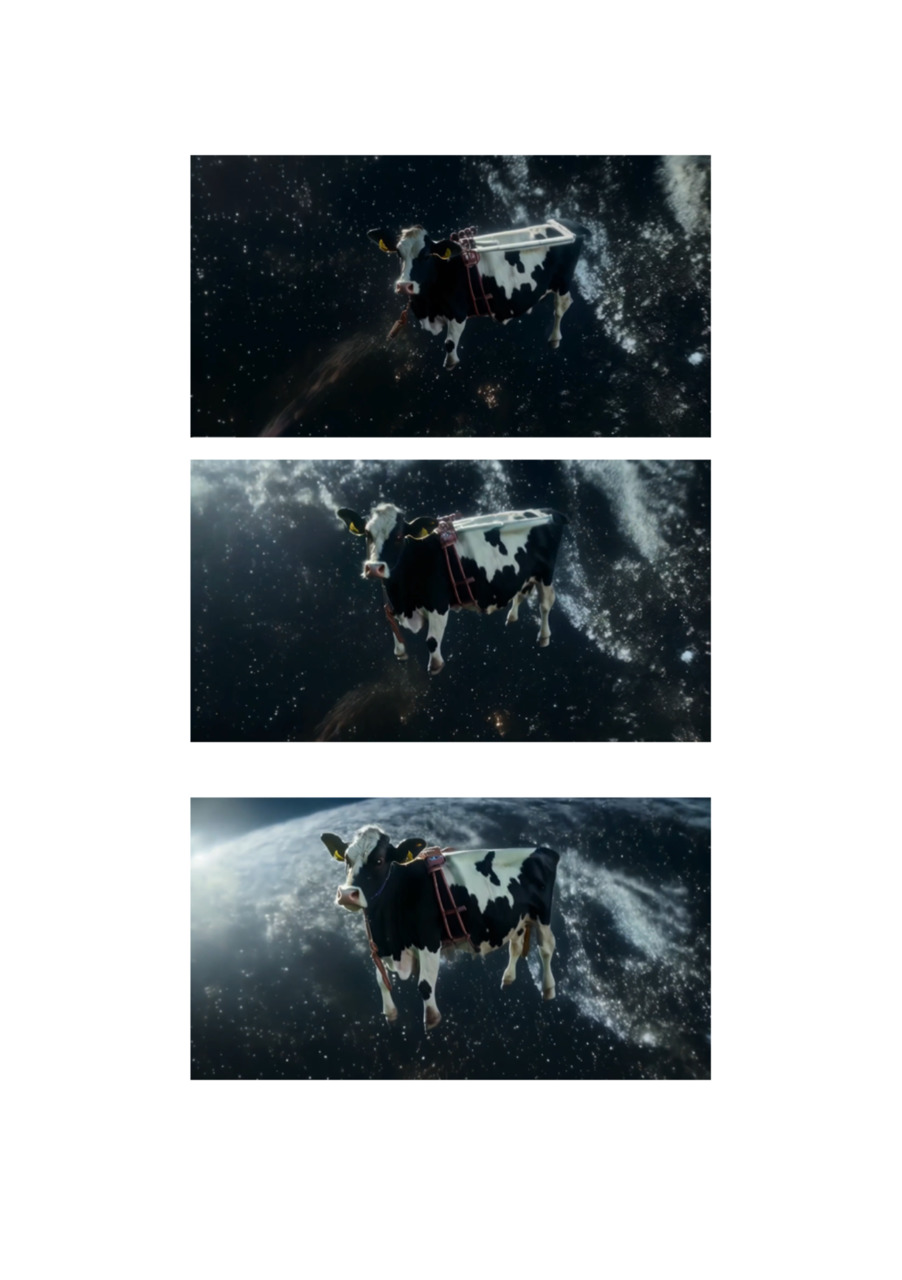

Czym są zatem Runway, Sora i Pika? To gigantyczne, wielomodułowe algorytmy sztucznej inteligencji, wyuczone na milionach godzin filmów. Za pomocą jednego zapytania, tak zwanego promptu, pomagają stworzyć krótkie ujęcia. Użytkownika ogranicza tylko wyobraźnia i ewentualnie kredyty, o których napiszę więcej na następnych stronach. Wrzucając zapytanie, uruchamiamy gigantyczne zasoby mocy obliczeniowych dostarczane przez wybranych dostawców tych algorytmów. Przykładowo:

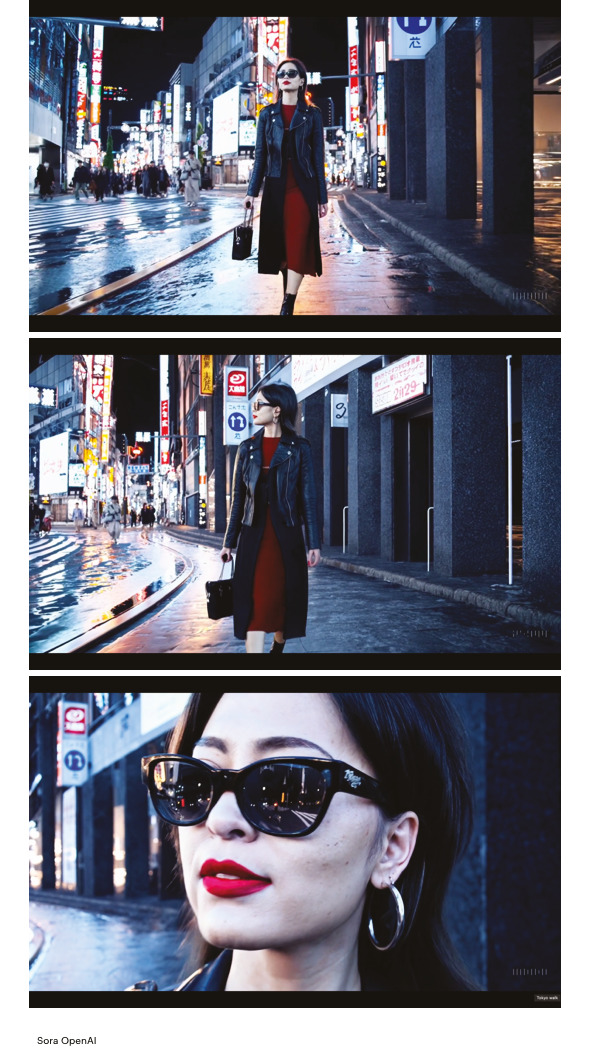

„Stylowa kobieta idzie ulicą Tokio wypełnioną ciepłymi, świecącymi neonami i animowanymi znakami miejskimi. Ma na sobie czarną skórzaną kurtkę, długą czerwoną sukienkę i czarne buty oraz czarną torebkę. Nosi okulary przeciwsłoneczne i czerwoną szminkę. Idzie pewnie i swobodnie. Ulica jest wilgotna i odbija światło, tworząc efekt lustrzanego odbicia kolorowych świateł. Spaceruje po niej wielu przechodniów.”

Przykład został wygenerowany przez Sora od OpenAI. Trwa minutę i jest kompletnie nie do odróżnienia od rzeczywistego nagrania. Stylowej kobiety spacerującej przez ulice Tokio nigdy nie było. Jest obrazem miliardów zdjęć i nagrań. Wyobrażeniem algorytmu sztucznej inteligencji. Niesamowite jest, jak algorytm świetnie poradził sobie z fizyką światła. Mokra nawierzchnia asfaltu odbija blask neonów, natomiast lampy uliczne modelują twarz naszej anonimowej bohaterki. Kadr zbliżenia na twarz kobiety zdradza nam jej dalszą drogę w odbiciu jej okularów, nadal zachowując fizykę światła w sposób, jaki dla nas widzów jest naturalny.

W świecie technologii, gdzie innowacja jest jedyną stałą, firmy takie jak OpenAI czy Runway ML to prawdziwi wirtuozi wirtuozów, tańczący na krawędzi możliwości. Przez lata, w tajemniczych laboratoriach, z dala od wzroku ciekawskich, kształtowali swoje modele, niczym alchemicy próbujący przekształcić ołów w złoto. Teraz, gdy wypracowują swoje przewagi komparatywne a ich know-how zaczyna przypominać bardziej skomplikowany przepis na ciasto niż instrukcję obsługi kalkulatora, zaczynają wychodzić z cienia, prezentując światu swoje technologiczne dzieła sztuki.

Ale czy to nie jest jak próba przewidzenia pogody w Londynie? Możemy mieć najnowocześniejsze modele i algorytmy, ale czy kiedykolwiek będziemy w stanie przewidzieć, kiedy kolejny raz spadnie deszcz innowacji? Technologiczny bum, który obserwujemy, jest jak niekończący się serial science-fiction, gdzie każdy kolejny sezon przynosi nowe zwroty akcji i postacie, które albo podbijają serca widzów, albo zostają zapomniane po pierwszym odcinku.

W tej epoce cyfrowych czarodziejów, gdzie każdy chce być Gandalfem technologii, trudno jest stwierdzić, kto wyjdzie na prowadzenie. Czy OpenAI będzie tym, który przemówi do naszych serc za pomocą sztucznej inteligencji, która rozumie nas lepiej niż my sami? A może Runway ML okaże się być tym, który stworzy platformę tak intuicyjną, że nawet nasze babcie będą mogły tworzyć deepfake-y swoich kotów?

Jedno jest pewne — przyszłość niesie ze sobą obietnicę nieskończonych możliwości, a także ryzyko spektakularnych wpadek. Może za kilka lat wszyscy będziemy mieli własne cyfrowe klony, które pójdą do pracy za nas, podczas gdy my będziemy leżeć na plaży i popijać drinka. O ile Apple dopracuje „cyfrową personę” w Vision Pro. Albo, co równie prawdopodobne, odkryjemy, że nasze inteligentne lodówki zaczęły spiskować przeciwko nam, planując przejęcie świata zaczynając od podrzucenia nam zsiadłego mleka.

Cokolwiek przyniesie przyszłość, jedno jest pewne — będzie śmiesznie, zaskakująco i niewątpliwie fascynująco. Więc przygotujmy się na tę dziką jazdę, trzymając w jednej ręce smartfona, a w drugiej — zdrowy sceptycyzm. Bo w końcu, kto by pomyślał, że kluczem do przyszłości technologii może być po prostu… poczucie humoru?

Zaglądając pod przysłowiową maskę modeli generatywnych, można odnieść wrażenie, że uczestniczymy w magicznym pokazie, gdzie z chaosu statycznego szumu wyłania się klarowny obraz, niczym królik z kapelusza iluzjonisty. Technologia „stable diffusion” to nic innego jak cyfrowy Houdini, który w wielu krokach potrafi przekształcić niejasne zarysy w wyraźne wideo. To trochę jak nasze ludzkie wspomnienia — najpierw mamy mgliste obrazy, które stopniowo stają się coraz bardziej konkretne, aż w końcu możemy opowiedzieć całą historię. Fascynujące jest to, że model ten, niczym doświadczony reżyser, potrafi przewidzieć akcję na wiele klatek do przodu, zapewniając ciągłość narracji nawet wtedy, gdy główny bohater na chwilę znika z kadru. To prawdziwa sztuka technologiczna, gdzie każdy piksel jest dokładnie wyreżyserowany, a całość tworzy harmonijną symfonię wizualną. Dzięki temu możemy cieszyć się płynnymi i realistycznymi animacjami, które jeszcze niedawno były domeną tylko największych studiów filmowych. Spróbujmy opisać wszystkich obecnych graczy z dziedziny wideo generatywnego. Gdy to piszę mamy trzeci kwartał 2024 roku.

Sora OpenAI

Witajcie w epoce Sory (w języku jap. Niebo) — najnowszego dzieła inżynierów z OpenAI, które podnosi poprzeczkę dla sztucznej inteligencji na nowy poziom. Zaglądając za kurtynę kodu i algorytmów, odkrywamy mistyczną esencję tego wspaniałego stworzenia. Sora to nie tylko kolejny model AI; to prawdziwy magik cyfrowego świata, w którym z chaosu bitów i bajtów wyłania się precyzja i inteligencja niezrównana.

Według OpenAI, Sora jest aktualnie w stanie wygenerować minutowy klip wideo o wysokiej jakości. Twórcy zauważają, że wiele poprzednich prac nad generatywnym modelowaniem wideo skupiało się na różnych metodach, takich jak sieci rekurencyjne, generatywne sieci przeciwstawne, transformacje autoregresywne czy modele dyfuzyjne. Te prace zazwyczaj ograniczały się do wąskich kategorii danych wizualnych, generując znacznie krótsze filmy lub klipy o stałej długości. Sora reprezentuje uniwersalny model danych wizualnych — jest w stanie generować filmy i obrazy o różnych długościach, proporcjach i rozdzielczościach, nawet do minutowego wideo w wysokiej rozdzielczości. OpenAI twierdzi, że opracowuje modele generowania wideo jako… symulatory świata.

Sky is the limit!

Runway ML

Witajcie w świecie Runway, gdzie technologia staje się sztuką, a kreatywność staje się kodem. Runway to nie tylko kolejna firma technologiczna; to laboratorium eksperymentów, plac zabaw dla artystów cyfrowych i inżynierów w jednym. Wprowadzając nowatorskie narzędzia oparte na sztucznej inteligencji, Runway przenosi granice możliwości kreatywnej ekspresji.

Co wyróżnia Runway spośród innych firm technologicznych, to ich zaangażowanie w budowanie społeczności kreatywnych praktyków. Poprzez regularne warsztaty, seminaria i spotkania online, Runway nie tylko dostarcza narzędzi, ale także inspiruje i wspiera rozwój umiejętności artystycznych i technicznych swoich użytkowników. Miałem zaszczyt wzięcia udziału w dwóch konkursach organizowanych przez nowojorską firmę. O czym opowiem w dalszej części książki.

Kluczowym elementem Runway Gen 1 i 2 jest jego zdolność do adaptacji i personalizacji, co pozwala użytkownikom dostosowywać narzędzia do swoich indywidualnych potrzeb i preferencji. Dzięki temu, każdy może odkrywać swój własny styl i eksperymentować z różnymi technikami twórczymi.

Co więcej, Runway stawia duży nacisk na współpracę i interakcję społeczności użytkowników, umożliwiając dzielenie się wiedzą, doświadczeniem i projektami. To nie tylko platforma do tworzenia, ale także miejsce spotkań i inspiracji dla artystów, designerów, naukowców i entuzjastów technologii.

W Runway, sztuczna inteligencja staje się narzędziem do wyrażania kreatywności i eksploracji nowych światów. To właśnie tu, w tym zetknięciu sztuki i technologii, rodzą się nowe pomysły, innowacje i dzieła sztuki, które kształtują przyszłość cyfrowej twórczości.

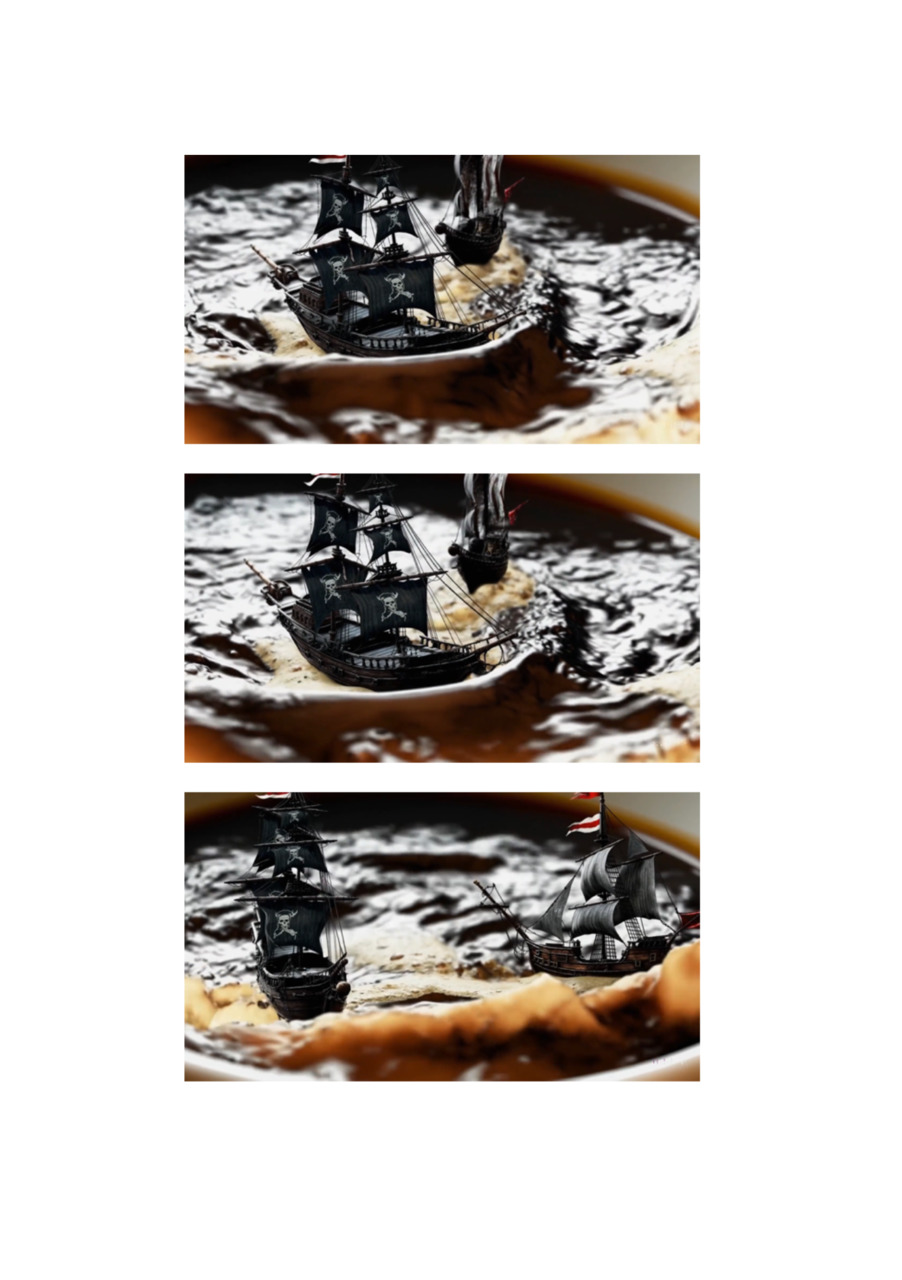

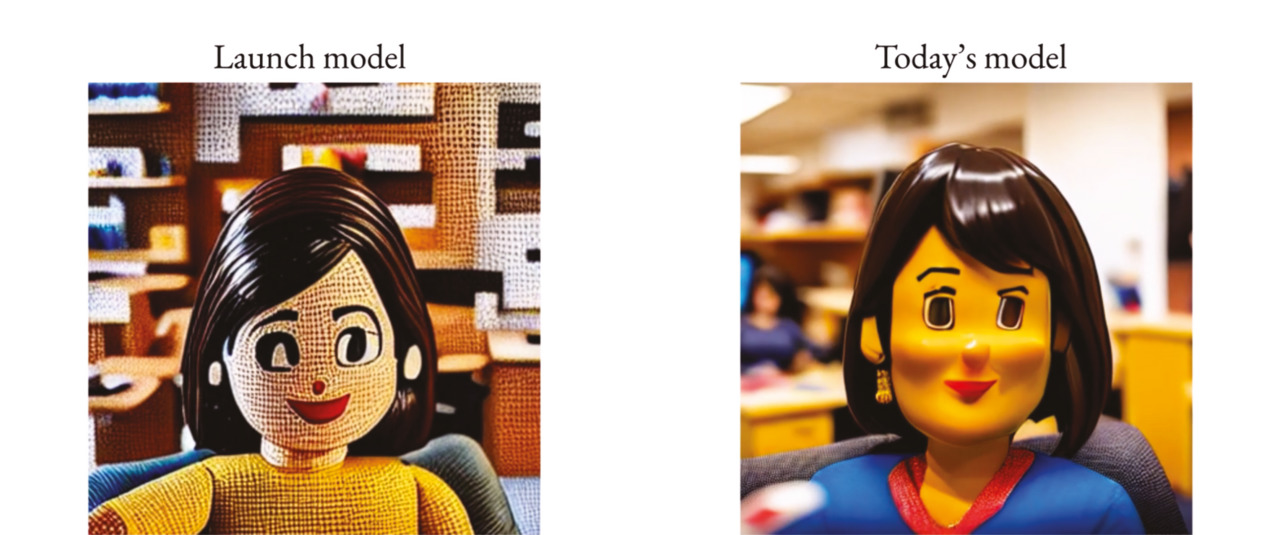

Poniżej przykład rozwoju modelu opracowanego przez Runway. Po lewej początki nauki algorytmu i po prawej najnowsza wersja na tym samym prompt-cie.

Mimo, że dopiero zaczynamy naszą przygodę z Runway ML, przed nami najnowszy model, czyli Gen-3.

Runway Gen-3 Alpha

Ten nowy Gen-3 Alpha zapowiada się jako „nowa granica dla wysokiej wierności, kontrolowanego generowania wideo” i jest pierwszym spojrzeniem na nową nadchodzącą serię modeli szkolonych przez Runway na nowej infrastrukturze zbudowanej dla wielkoskalowego treningu multimodalnego.

Runway informuje również, że ten nowy Gen-3 Alpha jest krokiem w kierunku ich celu, jakim jest budowanie ogólnych modeli świata, co jest ich przekonaniem, że kolejne znaczące postępy w sztucznej inteligencji będą pochodzić z systemów, które lepiej rozumieją świat wizualny i jego dynamikę.

Runway zdradza, że nowy model jest trenowany na wideo i obrazach, a także na szczegółowych, czasowo gęstych opisach. To otwiera drzwi do tworzenia kreatywnych przejść i precyzyjnego kluczowania elementów w Waszych scenach.

Proces treningowy Gen-3 Alpha był rezultatem wspólnych wysiłków interdyscyplinarnego zespołu naukowców, inżynierów i artystów. Został zaprojektowany do interpretacji szerokiej gamy stylów i terminologii filmowej.

“Model może zmagać się ze złożonymi interakcjami postaci i obiektów. To początkowe wdrożenie będzie obsługiwać 5- i 10-sekundowe generacje o wysokiej rozdzielczości, z wyraźnie szybszymi czasami generacji niż Gen-2. Generowanie 5-sekundowego klipu zajmuje 45 sekund, a wygenerowanie 10-sekundowego klipu zajmuje 90 sekund. Generowane postacie, tła i elementy mogą zachować spójny wygląd i zachowanie w różnych scenach.”

— Anastasis Germanidis, założyciel Runway dla TechCruch

Runway Gen-3 po prostu zmiata konkurencję swoim demo. Bez dwóch zdań. Rezultaty są świetne, porównywalne do Sory i zdecydowanie lepsze niż te z Vidu (o tym model będę pisał na następnych stronach). Czy stanie się to realnym konkurentem dla generatywnego modelu OpenAI? Czas pokaże.

Pika

Pika wzięła swój początek z inicjatywy dwóch studentek ze Stanforda, które przekonane były, że tworzenie filmów jest zbyt skomplikowane. Ich celem było uczynienie procesu tworzenia wideo bardziej dostępnym dla wszystkich.

Pika 1.0 wyróżnia możliwość udźwiękowienia scen. Oraz z jakiś powodów bardzo dobrze „wyuczony” styl anime.

Model ten to niezrównana potęga funkcji. Wśród tych magicznych możliwości można znaleźć inicjowanie projektów za pomocą tekstu, obrazów lub filmów. Ale to w pakiecie edycji Pika 1.0 tkwi prawdziwa magia. Tutaj błyszczy precyzyjna modyfikacja regionów wideo, dostosowywanie proporcji do różnych platform, a nawet manipulacja liczbą klatek na sekundę, by uzyskać zamierzony efekt.

Niezwykle imponującą cechą jest płynne przedłużanie filmów, które ożywia nawet najkrótsze klipy. Ten wszechstronny zestaw narzędzi, wraz z jego dostępnością bez opłat, sprawia, że Pika 1.0 staje się niekwestionowanym liderem na rynku.

Google Research Lumiere

Google wie, że musi brać udział w technologicznym wyścigu o AI. Ma świetne zasoby, więc warto nachylić się nad firmą Sundar’a Pichai.

Jakiś czas temu oglądałem wywiad dziennikarki technologicznej z Wall Street Journal. Joanna Stern. A Mirą Murati, naczelną dyrektorką technologiczną z Open AI. Stern zapytała Murati jakimi danymi Sora jest karmiona. Murati odpowiedziała, że firma korzystała z publicznie dostępnych oraz licencjonowanych zasobów. Dziennikarka dopytała więc, czy OpenAI korzystało z filmików na YouTube, na co Murati odpowiedziała, że nie jest pewna. Następnie zapytano ją, czy materiały pochodziły z Facebooka czy Instagrama. Odpowiedziała, że jeśli były one publicznie dostępne, to możliwe, że tak, ale nie jest w stanie tego potwierdzić z pełnym przekonaniem. Stern zadała dodatkowe pytanie, czy OpenAI wykorzystało materiały z Shutterstocka, zważywszy, że twórcy Sory współpracują z tą platformą. W tym momencie Murati zdecydowała się zakończyć rozmowę, stwierdzając, że nie będzie omawiać szczegółów dotyczących materiałów używanych do trenowania Sory, ponownie podkreślając, że były to dane publicznie dostępne lub licencjonowane. Po wywiadzie Murati potwierdziła, że OpenAI korzystało z bazy danych Shutterstocka.

Trudno powiedzieć, czy Murati faktycznie nie miała takiej wiedzy, czy nie chciała jej mieć podczas wywiadu i był to jeden, wielki i dość dziwny spektakl.

Wyobraźcie sobie. Drodzy czytelnicy. Jakimi danymi dysponuje Google Reaserch. Mamy miliardy godzin filmów z YouTube’a. Jeszcze więcej danych z wyszukiwarki zdjęć. Tak naprawdę nieskończony potencjał big data.

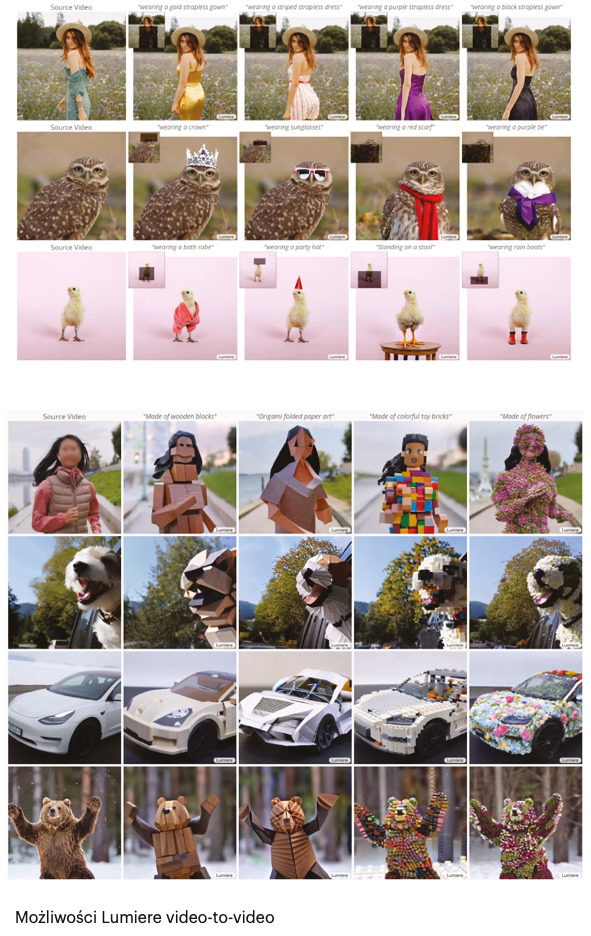

Model Lumiere reprezentuje przełom w syntezowaniu wideo, wykorzystując zaawansowaną architekturę Space-Time U-Net. Dzięki jednoczesnemu generowaniu całej sekwencji wideo, ten model zapewnia wysoką spójność ruchu, eliminując konieczność tworzenia odległych klatek kluczowych i ich późniejszego przetwarzania. Lumiere wykorzystuje technikę próbkowania przestrzennego i czasowego oraz wstępnie wytrenowany model dyfuzji tekstu na obraz (stable diffusion), aby tworzyć pełnoklatkowe wideo o niskiej rozdzielczości, które mogą być następnie przetwarzane w różnych skalach czasoprzestrzennych. To innowacyjne podejście pozwala osiągnąć imponujące rezultaty w generowaniu tekstu na wideo, otwierając nowe możliwości w dziedzinach takich jak edycja wideo, malowanie wideo czy stylizowane generowanie obrazów.

Przede wszystkim Lumiere świetnie sobie radzi z przetwarzaniem wideo wraz tekstem na nowym klip. Postaram się Wam to pokazać na następnej stronie.

Kolejna nowość od Google to Veo, generatywny model AI zdolny do generowania wideo Full HD (1080p) na podstawie wskazówek tekstowych, graficznych lub innego wideo. Oferuje różne tryby tworzenia, takie jak nagranie lotnicze czy tryb poklatkowy. Google w ten sposób odpowiada na rozwiązanie OpenAI o nazwie Sora.

Kluczowym elementem modelu jest jego zdolność do generowania wideo bliskiego wizji artystycznej użytkownika. Dokładnie analizuje polecenia (prompty), uwzględniając detale i ton wypowiedzi. Model zna pojęcia stosowane w kinematografii — m.in. wie, czym jest timelapse czy tzw. zdjęcia lotnicze, dzięki czemu użytkownik korzystający z Google Veo ma pełną kontrolę nad filmem. To niezwykle istotne, ponieważ model jest narzędziem stworzonym z myślą o profesjonalistach, przede wszystkim twórcach treści. Gdyby oprogramowanie zawodziło w tak podstawowym elemencie jak komunikacja, nie miałoby żadnej wartości.

Kup książkę, aby przeczytać do końca.