Bezpłatny fragment - AI bez ściemy.

Jak dzięki sztucznej inteligencji pracować mniej, robić więcej i nie dać się wygryźć.

Wstęp: Dlaczego w ogóle powinieneś to czytać?

Cześć, jestem Maciej. I nie jestem Twoim „Guru”

Pozwól, że na wstępie ustalimy jedną rzecz, oszczędzając nam obu czasu i rozczarowań. Jeśli szukasz profesora w tweedowej marynarce, który zza katedry z dębowego drewna będzie Ci wykładał teorię sztucznej inteligencji używając słów, których nie ma nawet w słowniku wyrazów obcych — źle trafiłeś. Odłóż tę książkę. Serio. Na rynku jest mnóstwo pozycji napisanych przez akademików, którzy ostatni raz widzieli prawdziwe wdrożenie biznesowe, gdy dyskietki były w modzie.

Nazywam się Maciej Karsznia. Nie mam tytułu „Wielkiego Maga AI”. Jestem praktykiem.

Na co dzień wykładam na studiach podyplomowych na uczelni Merito. Ale nie jestem typowym akademikiem zamkniętym w bibliotece. Jestem człowiekiem biznesu. Przez lata wdrażałem innowacje, budowałem strategie i widziałem na własne oczy, jak technologia zmienia firmy — czasem na lepsze, a czasem w spektakularne katastrofy, o których nikt nie chce mówić głośno.

Wdrażałem systemy AI w organizacjach, gdzie wszystko miało działać idealnie, a wykładało się na prostych ludzkich błędach. Widziałem prezesów płacących fortunę za „magiczne pudełka z AI”, które okazywały się wydmuszkami. I widziałem małe firmy, które dzięki sprytnemu wykorzystaniu darmowych narzędzi wyprzedzały rynkowych gigantów.

Piszę do Ciebie nie z wieży z kości słoniowej, ale z okopów biznesowych i sali wykładowej, gdzie studenci zadają najtrudniejsze pytania: „Panie Macieju, ale jak ja mam to jutro wykorzystać w mojej firmie?”.

Jestem Twoim przewodnikiem po tej dżungli. Mam maczetę, mapę (trochę pogniecioną od ciągłego używania) i wiem, w których krzakach siedzą węże. Nie obiecuję Ci, że nie ubrudzisz sobie butów. Obiecuję Ci, że przeżyjesz i wyjdziesz z tej dżungli z konkretnymi umiejętnościami, a nie tylko z głową pełną teorii.

To nie jest książka dla informatyków. To książka dla Ciebie — niezależnie od tego, czy prowadzisz firmę, pracujesz w korporacji, czy po prostu chcesz zrozumieć, o co tyle hałasu z tą sztuczną inteligencją.

Gotowy? No to zaczynamy.

Obietnica „Fail Fast”: Ubrudź sobie ręce

W szkole uczyli nas, że błędy są złe. Że za błąd dostaje się jedynkę, uwagę do dziennika i wstyd przed całą klasą.

W świecie AI ta zasada to prosty przepis na porażkę.

Tutaj obowiązuje jedna reguła: Fail Fast, Learn Faster (Psuj Szybko, Ucz się Jeszcze Szybciej). Jeśli czytasz tę książkę, żeby nauczyć się „teorii” przed pierwszym otwarciem ChatGPT — robisz to źle. Chcę, żebyś w trakcie lektury miał otwartą przeglądarkę. Chcę, żebyś pisał prompty, które nie działają. Chcę, żebyś się frustrował, klął pod nosem i zastanawiał, dlaczego to cholerstwo znowu wygenerowało bzdury.

Dlaczego? Bo AI, o którym będziemy rozmawiać, to nie jest stabilny most, po którym możesz bezpiecznie przejść. To jest żywy organizm. To jest chaos. Modele językowe halucynują (czyli kłamią z pewnością siebie godną polityka), mylą fakty, gubią wątek. I to jest wspaniałe. Bo tylko „psując” je, zrozumiesz, jak działają.

Nie będziemy tu kuć na pamięć definicji sieci neuronowych. Będziemy eksperymentować. Będziemy wciskać guziki z napisem „Nie dotykać”, tylko po to, żeby zobaczyć, co wybuchnie. Bo kiedy wybuchnie w kontrolowanych warunkach (u Ciebie na ekranie), to nauczysz się więcej w 5 minut, niż przez rok słuchania wykładów o historii cybernetyki.

Ostrzeżenie: To nie magia, to matematyka (i trochę statystyki)

Muszę Cię brutalnie sprowadzić na ziemię. Wiem, co słyszysz w mediach. „Sztuczna Inteligencja zyskała świadomość!”, „AI czuje!”, „Robot chce zniszczyć ludzkość!”.

Bzdura.

Sztuczna inteligencja, o której tutaj piszemy — te wszystkie modele GPT, Claude, Llama — nie mają duszy. Nie mają uczuć. Nie „myślą” w ludzkim rozumieniu tego słowa. Nie obrażają się (chociaż czasem tak to wygląda).

To jest matematyka. Bardzo zaawansowana, niesamowicie imponująca, ale wciąż — matematyka. Statystyka na sterydach.

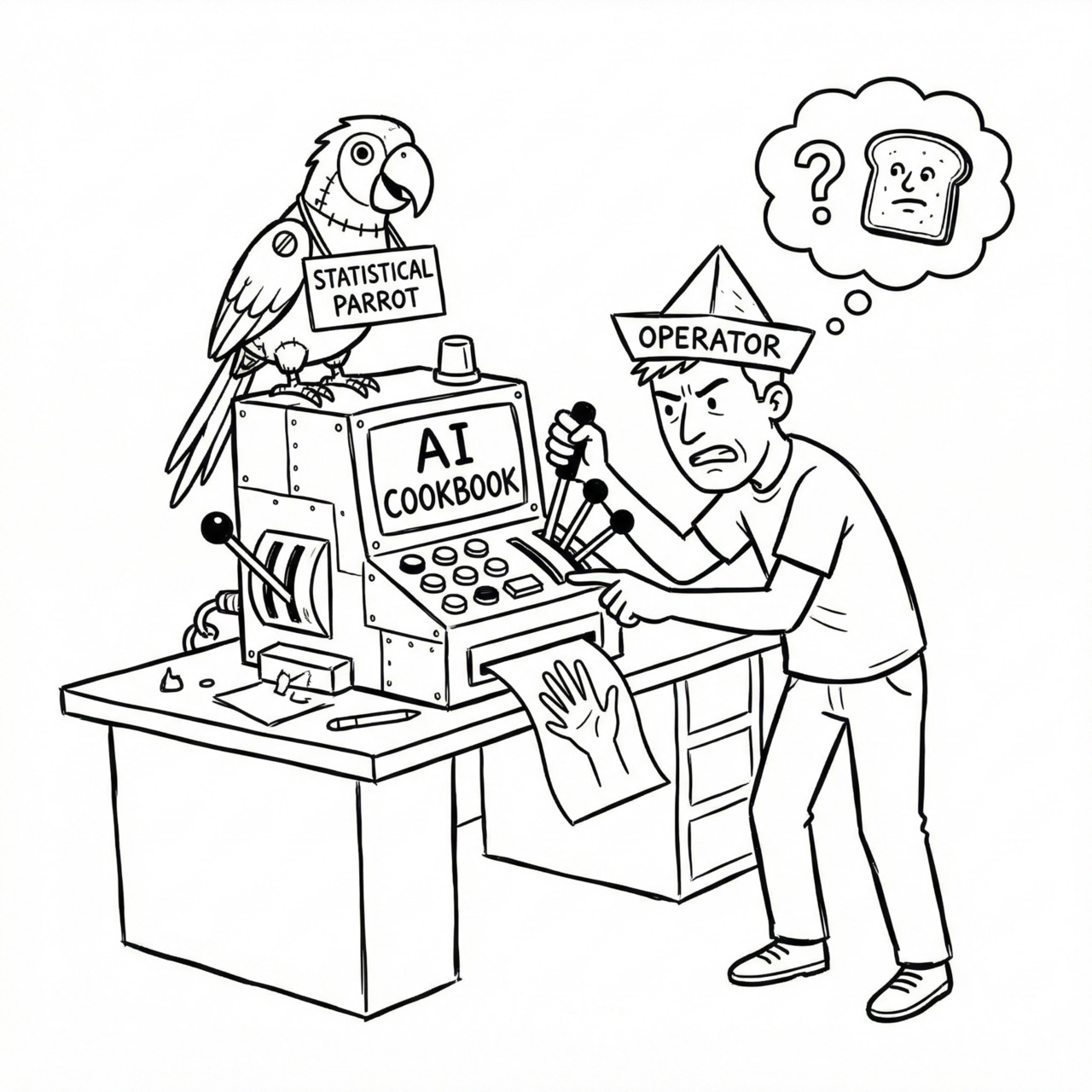

Wyobraź sobie, że masz papugę, która przeczytała cały Internet. Wszystkie książki, artykuły, posty na Reddicie i komentarze na Onecie. Kiedy zadajesz jej pytanie, ona nie „zastanawia się” nad odpowiedzią. Ona, bazując na miliardach przeczytanych zdań, oblicza prawdopodobieństwo, jakie słowo powinno wystąpić po poprzednim.

To jest „Statystyczna Papuga”. Genialna, ale papuga.

Dlaczego o tym mówię na wstępie? Bo jeśli zaczniesz traktować AI jak człowieka — jak przyjaciela, powiernika czy, nie daj Boże, autorytet moralny — zginiesz. AI to narzędzie. Jak wiertarka, młotek albo arkusz kalkulacyjny. Wiertarka nie ma gorszego dnia, nie ma intencji, nie knuje przeciwko Tobie. Wiertarka po prostu wierci, jeśli naciśniesz spust. Jeśli przyłożysz ją do kolana i naciśniesz spust — przewierci Ci kolano. Czy to wina wiertarki? Nie.

Traktuj tę książkę jako instrukcję obsługi tej wiertarki udarowej. Nauczę Cię, jak nią celować, żeby wiercić dziury w ścianach (rozwiązywać problemy), a nie w swoich kolanach.

Dlaczego teraz? (Czyli o Tosterze z WiFi)

Możesz zapytać: „Maciek, dlaczego akurat teraz? Przecież AI istnieje od lat 50. ubiegłego wieku”.

To prawda. Ale lata 2023/2024 to moment, w którym — mówiąc kolokwialnie — tama pękła.

Siedzimy właśnie w takim momencie historii, w jakim byli ludzie, gdy Tim Berners-Lee pokazał światu pierwszą stronę WWW. Wtedy mało kto rozumiał, po co komu „internet”. „Przecież mam telefon i faks, po co mi ta sieć?”. Dziś nie wyobrażasz sobie życia bez smartfona.

Mamy do czynienia z „Momentem iPhone’a” dla sztucznej inteligencji. Technologia, która była ukryta w laboratoriach Google i OpenAI, nagle trafiła pod strzechy. Każdy — od licealisty piszącego wypracowanie, po prezesa banku — dostał dostęp do superkomputera w kieszeni.

Świat przyspieszył. I to nie jest marketingowe hasło. Firmy, które teraz zignorują AI, zginą jak producenci faksów. Będą martwe. Albo w najlepszym razie — skansenem.

To jest „Toster z WiFi”. Nagle każda aplikacja, każdy program, każde urządzenie „ma AI”. To jest wszędzie. Nie uciekniesz przed tym. Możesz albo stać na brzegu i narzekać, że idzie fala, albo nauczyć się surfować.

Ta książka to Twoja deska surfingowa.

Bariera Wejścia: Co muszę mieć na start?

Na koniec dobra wiadomość. Żeby zacząć, nie potrzebujesz:

— Doktoratu z matematyki.

— Superkomputera z kartami graficznymi za 50 000 zł.

— Umiejętności programowania w Pythonie (choć to się przydaje, ale o tym później).

— Walizki pieniędzy.

Bariera wejścia leży na ziemi. Wystarczy Ci:

— Komputer (nawet stary laptop) lub smartfon.

— Dostęp do Internetu.

— Adres e-mail.

— Ciekawość. (To najważniejszy punkt).

„Ale Maciek, czy muszę płacić te 20 dolarów miesięcznie za ChatGPT Plus?”

Na start? Nie. Darmowe wersje modeli (GPT, Claude, Gemini) są absolutnie wystarczające, żeby zrozumieć podstawy, nauczyć się promptowania i poczuć tę technologię. Pokażę Ci, kiedy warto wyciągnąć kartę kredytową, a kiedy darmowe narzędzie zrobi robotę w 100%.

Większość ludzi myśli, że AI to „czarna magia” dla inżynierów z Doliny Krzemowej. Moją misją w tej książce jest udowodnienie Ci, że to bzdura. AI jest dla prawników, marketingowców, nauczycieli, lekarzy, sprzedawców i hydraulików. Jest dla Ciebie.

Więc, jeśli jesteś gotowy, żeby przestać się bać i zacząć działać — zapnij pasy. Wchodzimy do króliczej nory. I obiecuję Ci — będzie ciekawie.

Gotowy? No to jedziemy.

Mapa Drogowa: Co Cię czeka w tej dżungli?

Zanim ruszymy w głęboki las, rzućmy okiem na mapę. Ta książka to nie zbiór losowych ciekawostek. To proces. Przemyślana ścieżka od „nie mam pojęcia, o co chodzi” do „zarządzam armią cyfrowych asystentów”.

Oto przystanki, które zaliczymy po drodze:

Rozdział 1: Ale o co chodzi? AI pod maską

Zdejmiemy obudowę z silnika. Dowiesz się, jak to w ogóle działa — ale bez matematyki z doktoratu. Zrozumiesz, dlaczego AI czasem „zmyśla” (halucynuje) i dlaczego to nie jest błąd, ale cecha. Poznasz pojęcia takie jak tokeny czy temperatura, dzięki czemu przestaniesz traktować ChatGPT jak magię, a zaczniesz jak narzędzie.

Rozdział 2: Jak rozmawiać? Inżynieria Promptów

Nauczysz się języka, którym mówi AI. Pokażę Ci, że „jakość pytania równa się jakość odpowiedzi”. Dostaniesz gotowe szablony (Magiczna Triada), nauczysz się metody „myśl krok po kroku” i zobaczysz, jak zmusić model do poprawiania samego siebie. Koniec z frustracją, że „ono mnie nie rozumie”.

Rozdział 3: Haker Umysłów: Psychologia w AI

To moje ulubione. Pokażę Ci, jak „zhakować” AI, używając… emocji i psychologii. Dowiesz się, dlaczego bycie miłym (lub udawanie paniki) poprawia wyniki. Nauczysz się nadawać modelowi role (Role Play) i omijać jego wewnętrzną cenzurę, gdy jest nadgorliwa.

Rozdział 4: Twój Własny Sztab: Budowanie Asystentów

Przestaniesz pisać w kółko te same instrukcje. Zbudujesz własną armię spersonalizowanych asystentów (GPTs) — od specjalisty ds. marketingu po osobistego trenera produktywności. Pokażę Ci, jak stworzyć „Meta-Asystenta”, który będzie pisał prompty za Ciebie.

Rozdział 5: GPS dla Modelu: Wektory i Semantyka

Brzmi groźnie? Spokojnie. To moment, w którym zrozumiesz, jak AI „rozumie” znaczenie słów. Dzięki temu dowiesz się, jak działa Netflix czy Spotify i jak wykorzystać tę technologię, by znajdować igłę w stogu siana (informacji), nawet gdy nie znasz dokładnych słów kluczowych.

Rozdział 6: Pamięć Absolutna: RAG i Dokumenty

Twoje AI przestanie zgadywać, a zacznie pracować na Twoich danych. Nauczysz się „rozmawiać” z dokumentami PDF, umowami czy raportami. Pokażę Ci narzędzia (jak NotebookLM), które robią to za darmo i w kilka sekund. To koniec ery „Ctrl+F”.

Rozdział 7: AI w Biznesie: Procedury Flow

Konkretne scenariusze użycia. Jak zautomatyzować nudne maile? Jak analizować umowy prawne bez kończenia prawa? Jak zmusić AI do pracy w Excelu i tworzenia wykresów? To rozdział dla tych, którzy chcą odzyskać swój czas.

Rozdział 8: Bezpieczeństwo i Etyka

Ciemna strona mocy. Czego NIE wrzucać do chatu, żeby nie stracić tajemnic firmowych. Jak rozpoznać, kiedy AI kłamie prosto w oczy (i przytakuje Ci, bo chce być miłe). Będzie o bezpieczeństwie Twoich danych i o tym, jak nie dać się oszukać deepfake’om.

Rozdział 9: Przyszłość: Agenci i AGI

Na koniec spojrzymy w szklaną kulę. Czym są autonomiczni agenci, którzy sami rezerwują Ci loty? Kiedy AI będzie mądrzejsze od nas we wszystkim (AGI)? I co najważniejsze — jak się na to przygotować, żeby nie wypaść z rynku.

To nie jest tylko spis treści. To obietnica. Jeśli przejdziesz ze mną tę drogę, rozdział po rozdziale, wykonując ćwiczenia (pamiętasz o „brudzeniu sobie rąk”? ), to na końcu będziesz wiedział o praktycznym zastosowaniu AI więcej, niż 99% ludzi wokół Ciebie.

Wchodzisz w to?

Rozdział 1: Ale o co chodzi? AI pod maską (Technikalia w ludzkim języku)

TL; DR — Czego dowiesz się w tym rozdziale:

— Kucharz vs Przepis: Dlaczego AI to kreatywny chaos, a nie sztywny algorytm.

— Wujek Zdzisiek: Jak działa sieć neuronowa (na przykładzie wesela).

— Statystyczna Papuga: Dlaczego model kłamie z kamienną twarzą.

— Ekonomia Tokenów: Dlaczego darmowe AI „liczy” pieniądze inaczej niż Ty.

— Kontekst: Dlaczego AI zapomina, co napisałeś minutę temu.

Wstęp: Ofiara czy Operator?

Czujesz się głupi, gdy Twoi koledzy z IT rzucają przy kawie terminami „gradient descent”, „fine-tuning”, „RAG” albo „wektoryzacja”? Masz wrażenie, że cyfrowy pociąg odjeżdża z piskiem opon, a Ty stoisz na peronie z nieważnym biletem, w dodatku w klapkach, i machasz ręką do konduktora, który ma Cię gdzieś?

Spokojnie. Oddychaj. To nie Twoja wina.

To wina „ekspertów”, którzy budują mury z żargonu, żeby sprzedawać Ci drabiny po 5000 zł za szkolenie. Albo po prostu sami nie rozumieją, o czym mówią, więc chowają się za trudnymi słowami.

Ja, Maciej Karsznia, mam na to alergię. Mówi się, że jeśli nie potrafisz czegoś wytłumaczyć sześciolatkowi (albo swojej babci, która myśli, że Wi-Fi to rodzaj herbaty), to znaczy, że sam tego nie rozumiesz. Ja nie aspiruję do Nobla z matematyki. Ja chcę, żebyś po tym rozdziale przestał być Ofiarą Technologii, a stał się jej Operatorem.

Po co Ci „bebechy”?

Możesz zapytać: „Maciek, ale po co mi to? Ja chcę pisać maile, a nie budować Skynet”.

Słusznie. Ale czy wsiadłbyś do samochodu, nie wiedząc, która pedał to hamulec, a który gaz? Albo myśląc, że paliwo wlewa się do spryskiwacza? Pewnie nie. Z AI jest tak samo. Jeśli traktujesz ChatGPT jak magię, będziesz nim rozczarowany. Będziesz krzyczeć na komputer, że „znowu kłamie”, zamiast zrozumieć, dlaczego kłamie i jak to naprawić.

Zdejmijmy maskę „magii”. Zobaczysz pod nią nie duszę, nie świadomość, ale trybiki. Zimne, matematyczne trybiki.

Wiesz co jest w tym najlepsze? Trybiki można naoliwić, naprawić albo… wyrzucić, jak przestaną działać. Magię trzeba czcić. Maszyną można sterować.

Ten rozdział to Twoja instrukcja obsługi wiertarki. Może nie jest tak ekscytująca jak film science-fiction, ale dzięki niej nie powiercisz sobie kolan.

Gotowy? No to otwieramy maskę.

1. Szarlotka, czyli czym się różni Algorytm od AI?

Zacznijmy od podstaw, o które potykają się nawet prezesi banków (serio, widziałem to na własne oczy podczas wdrożenia za miliony). Czym do cholery różni się „zwykły program” (jak Excel, system księgowy czy kalkulator) od „Sztucznej Inteligencji”?

To różnica między Twoją Babcią a Gordonem Ramsayem.

Klasyczny Program = Przepis Babci (Algorytm)

Wyobraź sobie przepis na szarlotkę. Masz listę instrukcji dla robota (klasycznego programu):

— Krok 1: Weź 1kg jabłek odmiany Reneta.

— Krok 2: Obierz je ze skórki o grubości max 1mm.

— Krok 3: Zagnieć 500g mąki z 200g masła.

— Krok 4: Piecz dokładnie 45 minut w 180 stopniach Celsjusza.

Klasyczny program jest tępy, posłuszny i nieelastyczny.

— Scenariusz A: Wszystko idzie zgodnie z planem. Dostajesz idealną szarlotkę. Zawsze taką samą. Nuda, ale przewidywalna.

— Scenariusz B (Awaria): Zabraknie jabłek. Co robi „zwykły program”? Staje w miejscu, wyświetla niebieski ekran i krzyczy: CRITICAL ERROR: BRAK SKŁADNIKA [JABŁKO]. Koniec pracy. Idź do domu.

— Scenariusz C (Katastrofa): Piekarnik grzeje trochę mocniej. Program ma wpisane „45 minut”. Więc piecze 45 minut, mimo że ciasto już dawno zamieniło się w węgiel. On nie „widzi” efektu. On wykonuje procedurę.

AI = Kucharz, który uczy się smaku (Machine Learning)

Sztuczna Inteligencja (a konkretnie Machine Learning) nie dostaje przepisu krok-po-kroku. Dostaje Cel i Dane.

Cel: „Zrób coś pysznego”.

Dane: Tysiące zdjęć ciast, miliony przepisów z internetu, opinie krytyków kulinarnych, filmy z YouTube’a jak ludzie jedzą i się uśmiechają.

AI wchodzi do kuchni i zaczyna eksperymentować (to się ładnie nazywa „treningiem modelu”).

— Próba 1: Miesza mąkę z wodą w proporcji 1:1. Wychodzi klej do tapet. Ludzie plują. AI notuje: „Zła droga. -10 punktów do nagrody”.

— Próba 2: Miesza jabłka z cukrem. Smaczne, ale to sałatka owocowa, a nie ciasto. Notuje: „Blisko, ale brak struktury. +2 punkty”.

— Próba 15 000: Odkrywa, że połączenie ciasta, jabłek, cynamonu i temperatury X daje efekt, który ludzie oceniają na 5 gwiazdek. „Bingo! Zapisuję ten wzorzec”.

Wniosek: Kreatywność vs Posłuszeństwo

Wszystko pięknie, prawda? AI to Kreatywny Kucharz. Nie działa wedle sztywnego przepisu. Ono uczy się wzorców.

Dlatego, gdy w kuchni (w Twoim projekcie) zabraknie jabłek:

— Excel: Wywali błąd #VALUE!.

— AI: Pomyśli (statystycznie): „Wzorce pokazują, że gruszki mają podobną strukturę cukrów, wody i chrupkości do jabłek. W wielu przepisach występują zamiennie. Użyję gruszek.”.

Tradycyjny soft by się wyłożył. AI zadziała i uratuje imprezę.

Haczyk (Bo zawsze jest haczyk)

Ten genialny kucharz ma jedną wadę. Czasem, w przypływie „kreatywności”, pomyli sól z cukrem. Albo doda do szarlotki musztardę, bo statystycznie musztarda jest żółta jak wanilia, więc „może pasować”. I poda Ci niejadalny zakalec, twierdząc z kamienną twarzą i pełnym profesjonalizmem, że to „Awangardowa Kuchnia Fusion, której po prostu nie rozumiesz”.

I co gorsza — będzie w tym tak przekonujący, że możesz mu uwierzyć.

Maciek RADZI: Super-moc AI

AI ma jedną przewagę nad człowiekiem, której nie doceniasz. AI nie ma Ego.

Możesz kazać mu poprawiać tego samego maila 50 razy. „Zmień ton na weselszy”. „Teraz bardziej formalny”. „Teraz dodaj emotikonę”. „Wyrzuć emotikonę”.

Ludzki asystent po 5. razie rzuciłby w Ciebie klawiaturą albo zaczął Cię obgadywać w kuchni.

AI robi to z nieskończoną cierpliwością. Wykorzystaj to. Katuj model, aż wynik będzie idealny. To nie mobbing, to optymalizacja.

2. Machine Learning: Koty, Psy i Brutalna Siła

No dobra, ale jak to działa w praktyce? Jak nauczyć komputer — skrzynkę pełną przełączników prądu — odróżniać kota od psa? Przecież on nie ma oczu, nie ma uczuć, nie lubi głaskania.

Podejście Klasyczne (Porażka)

Gdybyś był programistą starej daty (takim z brodą do pasa i swetrem w renifery), próbowałbyś zapisać to w regułach IF-THEN (JEŚLI-TO):

— JEŚLI obiekt ma trójkątne uszy, TO jest kotem. (Błąd: Owczarek niemiecki też ma trójkątne uszy).

— JEŚLI obiekt ma wąsy… (Problem: Na zdjęciu kot stoi tyłem, wąsów nie widać).

— JEŚLI obiekt jest mały i puszysty… (Błąd: Młody Szpic Miniaturowy wygląda jak kłębek wełny, a nie jak pies).

Zwariowałbyś po godzinie. Świata nie da się opisać sztywnymi regułami. Jest zbyt chaotyczny. Koty bywają łyse (Sfinksy), psy bywają wielkości szczura (Chihuahua). Klasyczne metody nie dają rady.

Podejście Machine Learning (Brutal Force)

W Machine Learningu robimy inaczej. Stosujemy metodę „na brutala”.

— Bierzemy Dataset (Zbiór Danych): Folder, w którym jest milion zdjęć. Pół miliona zdjęć ma etykietę „PIES”, drugie pół miliona „KOT”.

— Wrzucamy to do „Czarnej Skrzynki” (Modelu) i mówimy: „Masz tu zdjęcia i odpowiedzi. Radź sobie. Znajdź różnice. Nie obchodzi mnie jak, masz zgadywać tak długo, aż zaczniesz trafiać.”

Algorytm zaczyna mielić piksele. On nie wie, co to „kot”. Dla niego zdjęcie to tylko macierz cyfr (każdy piksel to liczba określająca kolor).

Ale po przemieleniu miliona obrazków, algorytm zaczyna zauważać matematyczne zależności, których my nawet nie potrafimy nazwać:

— „Hej, na zdjęciach z etykietą KOT często występuje ten specyficzny układ pikseli (my wiemy, że to pionowa źrenica).”

— „Na zdjęciach z etykietą PIES często pojawia się ten kształt (wiszące uszy).”

Mapa Cech (Features)

Komputer buduje sobie Mapę Cech. Nie widzi zwierzęcia. Widzi zbiór statystycznych punktów:

— Kąt nachylenia ucha.

— Rozstaw oczu.

— Puszystość tekstury.

— Obecność języka na wierzchu.

Dla AI „Kot” to nie puszysty przyjaciel. To zbiór wektorów i wag, który z 99% prawdopodobieństwem pasuje do etykiety „KOT”.

Dlaczego to ważne dla Ciebie?

Bo to tłumaczy, dlaczego AI czasem popełnia idiotyczne błędy.

Jeśli pokażesz mu zdjęcie babeczki z jagodami (muffin) i zdjęcie pyszczka psa rasy Chihuahua, AI może zgłupieć.

Dla Ciebie różnica jest oczywista. Dla AI? Układ pikseli (trzy czarne kropki na jasnym tle) jest matematycznie prawie identyczny.

AI nie „rozumie” psa. AI „rozpoznaje wzorzec” psa. A wzorzec psa i babeczki jest niebezpiecznie bliski. Pamiętaj o tym, zanim zawierzysz AI w 100% przy analizie rentgenowskiej czy identyfikacji podejrzanych na lotnisku. To tylko statystyka.

3. Sieci Neuronowe: Wujek Zdzisiek na Weselu

„Sieci neuronowe” (Neural Networks). Brzmi jak coś z Cyberpunka, prawda? Albo jak bełkot, którym startupowcy zasłaniają fakt, że nie mają działającego produktu.

Spokojnie. To prosta matematyka, która bezczelnie zrzyna… z Twojej głowy.

Pokażę Ci to na przykładzie rozpoznawania Wujka Zdziśka na weselu. Dlaczego? Bo to najlepiej obrazuje, jak działa AI w rzeczywistym świecie szumu informacyjnego (i alkoholu).

Warstwy Abstrakcji (Jak myśli mózg?)

Twój mózg (i sztuczna sieć neuronowa) działa warstwowo. To się dzieje w ułamku sekundy, ale proces wygląda tak:

— Warstwa 1 (Input — Kształty): Twoje oczy rejestrują plamy koloru. Owalny kształt. Kilka kresek. Czerwony nos. Błysk szkła. Nic więcej. Twój mózg nie wie jeszcze, co to jest. To surowe dane.

— Warstwa 2 (Feature Extraction — Cechy): Mózg zaczyna składać te plamy do kupy. „Ten owal ma wąsy”. „Ten trójkąt to chyba krawat”. „Ten czerwony obiekt to nos”.

— Warstwa 3 (Object Recognition — Obiekty): „Wąsaty mężczyzna w krawacie, lekko się chwieje i trzyma kieliszek. Wygląda znajomo”. Mózg szuka w bazie danych (pamięci).

— Warstwa Wyjściowa (Output — Werdykt): „To musi być Wujek Zdzisiek (prawdopodobieństwo 99%). Trzeba uciekać, bo będzie chciał pożyczyć 200 zł”.

Sztuczna sieć neuronowa robi dokładnie to samo (tylko Zdzisiek jest cyfrowy). Przemiela dane przez kolejne sita (warstwy ukryte). Jedna warstwa szuka kresek, druga nosów, trzecia twarzy, czwarta konkretnej tożsamości.

To jest Deep Learning (Głębokie Uczenie). „Głębokie”, bo tych warstw (sit) są setki.

Dlaczego AI widzi duchy? (Pareidolia)

Tu dochodzimy do fascynującego zjawiska. Skoro sieć jest tak potężna, to dlaczego czasem widzi rzeczy, których tam nie ma?

Znasz to uczucie, gdy spoglądasz w chmury i widzisz twarz? Albo widzisz Jezusa na przypalonym toście? To się nazywa Pareidolia. Twój mózg jest tak wytrenowany na szukanie twarzy (bo to ewolucyjnie ważne — musisz odróżnić przyjaciela od wroga), że znajdzie ją nawet w gniazdku elektrycznym.

Sztuczna sieć ma tak samo. Jeśli jest „przetrenowana” (overfitting) na szukanie wujków na zdjęciach, to znajdzie wujka nawet w sałatce jarzynowej, jeśli układ groszku i marchewki minimalnie przypomina jego wąsy.

Wniosek Biznesowy:

Pamiętaj o tym, gdy AI zacznie Ci wmawiać „fakty” i widzieć „trendy” w przypadkowym szumie danych giełdowych. To nie jest błąd systemu. To cecha jego budowy. Sieć szuka wzorca za wszelką cenę. Nawet tam, gdzie go nie ma.

Twoim zadaniem (jako Operatora) jest powiedzieć: „Stop. To nie trend. To szum. Nie inwestujemy”.

4. LLM: Statystyczna Papuga (I dlaczego łże jak z nut)

Teraz najważniejsze. ChatGPT, Claude, Gemini, Llama — to wszystko Large Language Models (LLM).

Oto brutalna prawda, która może zburzyć Twój światopogląd, jeśli wierzyłeś w „Ducha w Maszynie”:

AI nie wie, co mówi. AI nie rozumie słów. AI tylko oblicza prawdopodobieństwo.

Mechanika Papugi

Wyobraź sobie zdanie:

„Mikołaj Kopernik wielkim…”

Co będzie dalej?

Statystyka (oparta na całym polskim Internecie, podręcznikach, Wikipedii) mówi:

— ...astronomem był (85% szans — najbardziej prawdopodobne)

— …Polakiem był (14% szans — też często występuje)

— ...grillowanym tosterem (0.0001% szans — bez sensu)

ChatGPT to „Autouzupełnianie w Twoim telefonie”, tylko na gigantycznych sterydach. Nie myśli o Koperniku. Nie widzi gwiazd. Nie czuje dumy narodowej. Wylicza, że po ciągu znaków M-i-k-o-ł-a-j statystycznie najlepiej pasuje ciąg a-s-t-r-o-n-o-m.

Dlatego nazywam LLM-y Statystycznymi Papugami.

Papuga może powiedzieć „Jesteś genialny”, ale nie dlatego, że przeczytała Twój doktorat i oceniła Twój intelekt. Powiedziała tak, bo słyszała to tysiąc razy i dostała za to orzeszka (feedback pozytywny).

Geneza Halucynacji (Kłamstwo Doskonałe)

Jeśli zapytasz o coś popularnego (jak Kopernik), model trafi w 100%. Danych jest mnóstwo. Statystyka jest silna.

Ale co się stanie, jeśli zapytasz o coś rzadkiego? O niszowy wyrok sądu z 1998 roku? Albo o biografię Twojego sąsiada?

Model zacznie zmyślać (halucynować).

Dlaczego? Bo on nie ma opcji „Nie wiem”. On ma zadanie: „Dokończ tekst”.

Więc dokończy.

Dla modelu zdanie:

„Kopernik był kobietą”

jest tak samo poprawne gramatycznie i matematycznie (jako ciąg znaków) jak:

„Kopernik był mężczyzną”.

Jego celem nie jest Prawda. Jego celem jest Płynność. Ma brzmieć naturalnie.

Dlatego AI kłamie z pełnym przekonaniem w głosie. Jak pewny siebie narcyz w drogim garniturze na spotkaniu zarządu, który nie ma pojęcia o czym mówi, ale mówi to pięknie, używając trudnych słów. Wszyscy kiwają głowami, bo „brzmi mądrze”.

MIKRO-ZADANIE (Sprawdź to sam):

Otwórz teraz ChatGPT i zapytaj: „Opowiedz 3 ciekawe, mało znane fakty o życiu [Twoje imię i nazwisko]”.

Jeśli nie jesteś celebrytą, zobaczysz halucynacje w najczystszej postaci.

— AI zmyśli Twoją szkołę.

— Wymyśli nagrody, których nie dostałeś.

— A może nawet uśmierci Cię w 2010 roku w tragicznym wypadku na monocyklu.

Zrobi to z pełną powagą. Bo „słowa pasują statystycznie”. Nie wierz mu. Weryfikuj.

5. Nie tylko tekst: AI też „patrzy” i „słucha”

Mówimy o pisaniu, ale w 2026 roku modele są multimodalne. To znaczy: widzą obrazy, słyszą głos, generują wideo, a nawet piszą kod (dzięki Bogu, bo ja nienawidzę średników w C++).

Ale zasada „Statystycznej Papugi” pozostaje ta sama. Niezależnie czy to tekst, piksele czy fale dźwiękowe.

Case Study: Dlaczego AI rysowało 7 palców?

Zastanawiałeś się, dlaczego przez długi czas (w erze Midjourney v4 czy DALL-E 2) sztuczna inteligencja miała fiksację na punkcie dłoni? Generowała ludzi z 7, 8 albo 3 palcami. Wyglądało to jak horror klasy B.

To proste (i fascynujące).

W bazie danych (te miliony zdjęć z internetu) dłonie rzadko są „czyste”.

— Ludzie trzymają się za ręce (plątanina palców).

— Trzymają kubek kawy (część palców zasłonięta).

— Machają (rozmycie ruchu).

AI, jako statystyczny obserwator, „nauczyło się”, że na końcu ręki ma być „zbiór podłużnych, cielistych kształtów, w liczbie bliżej nieokreślonej, ale dużej”.

AI nie umie liczyć do pięciu. Ono nie wie, co to „anatomia człowieka”. Ono widzi plamy. Statystycznie zgadzało się: „Są palce? Są. Czy jest ich dużo? Tak. No to proszę, masz 7 palców. Nie dziękuj”.

Dziś modele są lepsze, bo nauczyliśmy je (my, ludzie) anatomii „na siłę” (poprzez RLHF — Reinforcement Learning from Human Feedback), ale mechanizm pozostał.

Wniosek:

AI „widzi” piksele, a nie obiekty. Jeśli poprosisz o wygenerowanie „Psa grającego w szachy”, AI nie zastanawia się nad zasadami szachów. Po prostu ułoży piksele tak, żeby przypominały planszę i psa. Pionki mogą stać w niemożliwych miejscach. Król może mieć głowę jamnika.

Dla AI to tylko wzór. Dla Ciebie — absurd.

Pamiętaj o tym, gdy generujesz grafiki do prezentacji dla Prezesa. Sprawdź, czy wszyscy mają po 5 palców, zanim klikniesz „Wyślij”.

6. Tokeny: Ból portfela (Dlaczego AI nie umie liczyć?)

Wielu moich studentów pyta (zwykle po kilku nieudanych próbach):

„Maciek, czemu to głupie AI nie umie napisać wiersza, gdzie każde słowo ma dokładnie 5 liter?! Przecież to proste jak budowa cepa!”.

Dla Ciebie tak. Dla AI to niemożliwe.

Bo AI nie widzi liter. Widzi Tokeny.

Klocki LEGO (Jednostka Znaczenia)

Token to „jednostka znaczenia”. To taki klocek LEGO.

— Dla AI słowo Apple to jeden klocek (nie widzi A-p-p-l-e).

— Słowo Jabłko (w języku polskim, który jest trudniejszy dla modeli z USA) to mogą być 2 albo 3 klocki (np. Ja, bł, ko).

— Słowo Konstantynopolitańczykowianeczka to już cała wieża z klocków.

Wyobraź sobie, że każę Ci policzyć litery „a” w zamkniętych pudełkach. Nie widzisz środka pudełka. Widzisz tylko etykietę na zewnątrz. Tak AI widzi tekst. Operuje na całych sylabach lub słowach. Nie zejdzie do poziomu litery, chyba że zmusisz je do literowania jak dziecko w przedszkolu („Przeliteruj słowo k-o-t”).

Explain Like I’m CEO: Aspekt Finansowy

To nie jest tylko ciekawostka dla geeków. To ma fundamentalne znaczenie dla Twojego portfela.

Modele (w API, czyli gdy podpinasz AI pod firmę, CRM czy stronę www) nie rozliczają się za słowa. Rozliczają się za tokeny.

— Język angielski jest „tani” (1 słowo = ~1 token).

— Język polski jest „drogi” (1 słowo = ~2—3 tokeny, przez końcówki fleksyjne ą/ę/óż).

Jeśli myślisz, że „krótki mail po polsku” kosztuje tyle samo co po angielsku, możesz się zdziwić przy płaceniu faktury.

Zrozumienie tokenów to różnica między fakturą za API na $50 a $500 miesięcznie.

Wskazówka:

Jeśli budujesz bota dla klienta w Polsce, licz się z tym, że „zjada” on limit tokenów 2x szybciej niż jego amerykański odpowiednik. Warto o tym wiedzieć, zanim obiecasz Szefowi, że „będzie tanio”.

7. Temperatura: Księgowy vs Poeta

Każdy model AI ma magiczny suwak zwany Temperaturą (zazwyczaj skala 0—1, czasem 0—2).

W ChatGPT jest on ukryty (działa gdzieś w tle na poziomie 0.7—1.0), ale w API czy w „Playground” masz nad nim pełną kontrolę.

To suwak, który decyduje, jak bardzo „szalony” ma być model.

Temperatura 0 (Lodowaty Księgowy)

Model wybiera TYLKO najbardziej prawdopodobne słowa. Zero ryzyka. Zero inwencji.

— Pytanie: „Dokończ: Kto rano wstaje…”

— Odpowiedź: „…temu Pan Bóg daje.” (Zawsze ta sama odpowiedź. 100 na 100 razy).

Zastosowanie Biznesowe:

— Generowanie kodu JSON do faktury.

— Wyciąganie danych z umów („Podaj datę i kwotę”).

— Analiza sentymentu.

— Tu nie chcesz „kreatywności”. Chcesz nudy, precyzji i powtarzalności.

Księgowy ma liczyć, a nie pisać wiersze o podatkach.

Temperatura 1 (Nawiedzony Poeta)

Model zaczyna ryzykować. Wybiera słowa mniej oczywiste, żeby było ciekawiej, barwniej, bardziej „ludzko”.

— Pytanie: „Dokończ: Kto rano wstaje…”

— Odpowiedź: „…ten idzie po świeże bułki do Biedronki.” (Albo „…ten ma wory pod oczami”).

Zastosowanie Biznesowe:

— Brainstorming nazw dla nowej marki chipsów.

— Pisanie zabawnych postów na LinkedIn.

— Wymyślanie scenariuszy reklamowych.

Ostrzeżenie (Security Alert)

Pamiętaj o prostej zasadzie: Wysoka temperatura = Większe ryzyko kłamstwa (halucynacji).

Poeta częściej zmyśla niż Księgowy, bo „prawda” bywa nudna, a on chce być ciekawy.

Jeśli potrzebujesz twardych faktów, trzymaj suwak nisko (lub proś w prompcie o styl „analityczny, suchy, bez ozdobników”). Jeśli chcesz zabawy — odkręć kurek.

Ale nigdy, przenigdy nie proś o analizę finansową przy temperaturze 1.0, chyba że chcesz dostać raport z Narnii.

8. Kontekst: Krótka Pamięć Złotej Rybki

Na koniec coś, o czym zapomina 90% użytkowników i potem pisze do mnie maile z pretensjami: „Maciek, ten GPT zgłupiał pod koniec rozmowy!”.

Ludzie myślą, że jak raz powiedzą coś AI, to ono zapamięta to na zawsze (jak przyjaciel).

Bzdura. AI ma pamięć złotej rybki (trochę lepszej, cyfrowej, ale wciąż).

Stół Roboczy (Context Window)

Wyobraź sobie Stół Roboczy. To jest „pamięć krótkotrwała” modelu (Context Window).

Rozmawiasz z ChatGPT:

— Zadajesz pytanie. AI kładzie kartkę z Twoim pytaniem na stole.

— AI odpowiada. Kładzie kartkę z odpowiedzią na stole.

— Zadajesz kolejne pytanie. Kolejna kartka.

Ten stół ma skończoną powierzchnię (limit tokenów).

Co się dzieje, gdy stół się zapełni? Czy AI dokłada dostawkę? Nie.

Gdy stół jest pełny, najstarsza kartka spada „z tyłu” na podłogę.

Fizyka Zapominania

To działa dosłownie. Fizycznie.

Jeśli wkleisz AI całą historię maili z klientem z całego roku (50 stron A4), a na końcu zapytasz o cenę ustaloną w pierwszym mailu — AI może ją zmyślić.

Dlaczego? Bo „pierwszy mail” leży już na podłodze. AI go „nie widzi” w swoim oknie kontekstowym. Widzi tylko to, co leży na stole w tej chwili (np. ostatnie 10 stron).

Higiena Pracy (Context Hygiene)

W biznesie to krytyczne. „Zaśmiecony stół” to błędne decyzje.

Jeśli czujesz, że model zaczyna bredzić, gubić wątek, mylić imiona — to znak, że stół jest pełny śmieci.

Czasem trzeba powiedzieć twardo: „Stop. Reset. Czyścimy stół.”

W ChatGPT klikasz „New Chat”.

Zaczynasz z czystym, pustym blatem. AI znów jest skupione, świeże i gotowe do pracy.

Nie ciągnij jednego wątku (czatu) w nieskończoność. To jak próba prowadzenia rozmowy w pokoju pełnym starych gazet — w końcu nikt nie wie, o czym gadacie.

Podsumowanie: Masz kluczyki, i co teraz?

Wiesz już, jak działa silnik. Gratulacje. Jesteś w elitarnym gronie ludzi, którzy wiedzą dlaczego, a nie tylko jak.

Wiesz, że:

— AI to Statystyczna Papuga, która czasem widzi duchy na toście.

— Nie umie liczyć liter w pudełkach (Tokeny).

— Ma pamięć złotej rybki, której kartki spadają ze stołu (Kontekst).

— To potężny, kreatywny Kucharz, który ma nieskończoną cierpliwość, ale czasem poda Ci musztardę zamiast kremu.

Ale wiedza o tym, jak działa silnik, nie sprawi, że zostaniesz dobrym kierowcą. Jeśli teraz spróbujesz wrzucić „wsteczny” przy setce na liczniku — rozbijesz się na pierwszym drzewie (albo stracisz klienta przez głupiego maila).

W następnym rozdziale nauczę Cię języka, którym mówi się do tej maszyny.

Pokażę Ci, dlaczego 90% ludzi „promptuje” źle (pisząc „napisz mi fajnego maila”) i jak w 3 prostych krokach wyprzedzić ich o lata świetlne.

Jesteś gotowy?

Otwórz nowy czat (wyczyść stół!). Zaczynamy jazdę.

Rozdział 2: Jak rozmawiać? Inżynieria Promptów od A do Z (Wersja Elite)

Ostrzeżenie: Ten rozdział jest długi. Jest „cegłą”. I ma taki być.

Dlaczego? Bo to najważniejsza umiejętność XXI wieku. Jeśli to odpuścisz, będziesz jak analfabeta w bibliotece — otoczony wiedzą, do której nie masz klucza.

Więc zaparz kawę. Dużą. I przygotuj się na to, że Twój mózg będzie musiał przestawić się na inne tory. Nie uczymy się tu „komend”. Uczymy się nowego języka.

Obalamy Mity: To nie Magia, to Matematyka

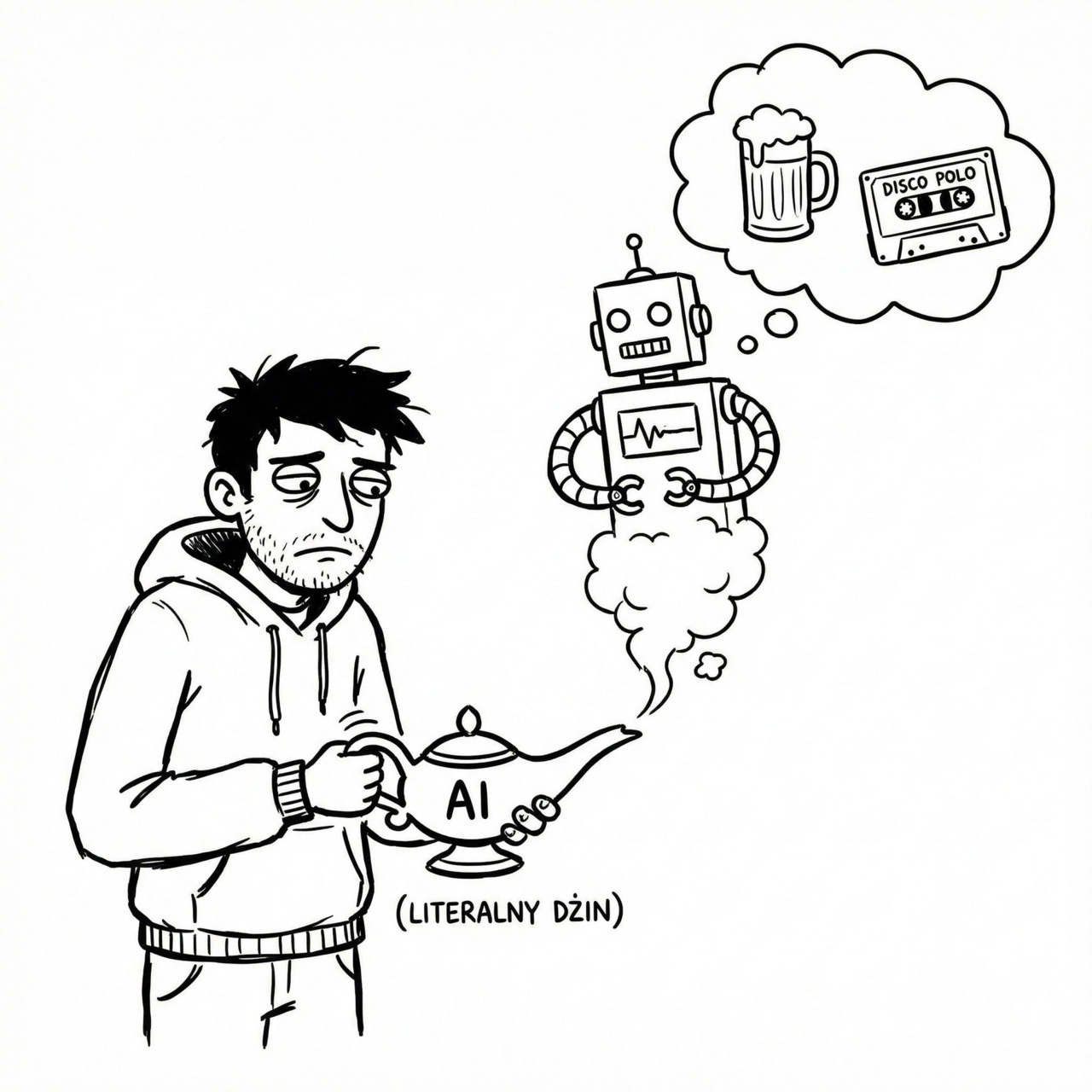

Ludzie myślą, że AI to „magiczna kula”, która czyta w myślach, albo „Dżin”, który jest złośliwy.

Bzdura.

AI to genialny stażysta z Aspergerem, który „przeczytał” cały internet, ale nie rozumie kontekstu społecznego.

A tak naprawdę, pod maską, to Architektura Prawdopodobieństwa.

Jak to działa? (Wersja dla Humanistów)

Wyobraź sobie, że piszesz SMS-a i telefon podpowiada Ci kolejne słowo.

Ty piszesz: „Idę do…", a telefon proponuje: „domu” (70%), „pracy” (20%), „kina” (10%).

LLM (Large Language Model) to właśnie taki „autouzupełniacz” na sterydach. Tylko że on nie patrzy na ostatnie słowo, ale na cały kontekst, który mu dałeś.

Diagram Mentalny:

MYŚL (Twoja intencja) -> JĘZYK (Twój niedoskonały opis) -> TOKENY (Cyfry dla maszyny) -> PRZETWARZANIE (Mnożenie macierzy) -> PRAWDOPODOBIEŃSTWO -> WYNIK.

Twoim zadaniem jako Inżyniera Promptów jest tak sformułować „JĘZYK”, żeby „PRAWDOPODOBIEŃSTWO” wskazało dokładnie to, o co Ci chodziło.

Jeśli napiszesz „fajny tekst”, prawdopodobieństwo rozmywa się na tysiące znaczeń (od „śmieszny” po „profesjonalny”).

Jeśli napiszesz „sarkastyczny felieton w stylu Jeremiego Clarksona o wadach samochodów elektrycznych”, prawdopodobieństwo zawęża się do bardzo konkretnego zbioru słów.

Efekt Dżina z Lampy (Literalność)

Wróćmy do metafory Dżina, bo ona najlepiej oddaje problem.

Pocierasz lampę i mówisz: „Dżinie, chcę żeby było fajnie”.

Co robi Dżin (Model)? Analizuje statystycznie słowo „fajnie” w internecie. I co mu wychodzi?

Że dla większości ludzi „fajnie” to memy z kotami, piwo i prosta rozrywka.

Więc Dżin stawia Ci budkę z ciepłym piwem i puszcza disco-polo na pełny regulator.

Ty chciałeś pałac z marmuru i kwartet smyczkowy.

Wściekasz się: „Głupi Dżin! Przecież wiedziałeś!”.

Nie, nie wiedział. Ty nie powiedziałeś.

Dżin jest LITERALNY. Bierze Twoje słowa dosłownie, bez nakładki kulturowej, bez „domyśl się”, bez „to oczywiste”.

Dla AI nic nie jest oczywiste.

Twoja Nowa Rola: Architekt Kontekstu

Witaj w świecie Professional Prompt Engineering.

To nie jest „pisanie zapytań”.

To jest projektowanie tekstowe.

Twoim celem jest zamiana myśli w precyzyjny kod (napisany językiem naturalnym), który nie pozostawia marginesu na błąd.

W tym rozdziale nauczysz się:

— Zasady GIGO — dlaczego Twoje prompty są słabe (i jak to naprawić).

— Modelu K-C-F-O-S — pancernej struktury każdego polecenia.

— Myślenia Wektorowego — jak nawigować po wiedzy modelu.

— Technik Zaawansowanych — XML tags, Chain of Thought, Tree of Thoughts.

Przestań być użytkownikiem. Zostań operatorem.

Zaczynamy.

1. GIGO: Garbage In, Garbage Out (Jakość Wsadu = Jakość Wyniku)

To jest absolutny fundament. Prawo, które rządzi informatyką od lat 60-tych, a w erze AI stało się ważniejsze niż kiedykolwiek.

Jeśli wrzucisz do maszynki do mięsa zgniłe ziemniaki i stare gazety, nie wyjdzie z niej polędwica wołowa. Wyjdzie breja.

W AI działa to tak samo, tylko szybciej i drożej.

Ludzie narzekają: „To AI jest głupie, pisze bełkot”.

Pytam: „A co wpisałeś?”.

Odpowiadają: „No… napisz maila do klienta”.

To jest Śmieć (Garbage).

Dając taki prompt, zmuszasz model do zgadywania. A model zgaduje „bezpiecznie”, czyli nudno.

Latent Space: Biblioteka Wszystkiego

Żeby zrozumieć GIGO, musisz zrozumieć pojęcie Latent Space (Przestrzeń Ukryta).

Model LLM to nie jest baza danych, gdzie masz szufladkę z napisem „Email do klienta”.

Model to wielowymiarowa mapa pojęć.

Gdy piszesz „Klient”, model zapala w swojej „głowie” obszar, gdzie są pojęcia: pieniądze, sprzedaż, negocjacje, usługa, faktura.

Gdy piszesz „Przyjaciel”, zapala obszar: zaufanie, piwo, spotkanie, pomoc, emocje.

Jeśli Twój prompt jest nieprecyzyjny („Napisz wiadomość”), model stoi na środku tej biblioteki i nie wie, w którą alejkę skręcić. Więc bierze książkę z półki „Najbardziej Popularne Banały”.

Dostajesz tekst: „Szanowni Państwo, w nawiązaniu do…". Tekst, który ląduje w koszu mentalnym odbiorcy.

Twoim zadaniem jest nawigacja. Musisz podać współrzędne w tej Przestrzeni Ukrytej.

Musisz powiedzieć: „Idź do alejki »Agresywna Sprzedaż«, weź książkę »Psychologia Wywierania Wpływu« i otwórz na stronie »Techniki Zamykania Sprzedaży B2B«”.

Analiza Biznesowa: Gdzie tracisz pieniądze (High Stakes)

Spójrzmy na konkretny przykład biznesowy. Chcesz przeanalizować umowę. To nie jest zabawa w wierszyki, tu jeden błąd może kosztować firmę fortunę.

Prompt Amatora (GIGO)

„Sprawdź tę umowę i powiedz czy jest ok.”

Wynik AI (Porażka / Halucynacja):

„Umowa wygląda standardowo. Zawiera typowe klauzule o poufności i płatnościach. Jest poprawnie sformatowana.”

Dlaczego to jest koszmar?

Bo „czy jest ok” to pojęcie względne. Dla prawnika drugiej strony jest „ok”. Dla Ciebie może być wyrokiem śmierci. AI bez kontekstu nie wie, po której stronie siedzisz.

Prompt Profesjonalisty (Elite):

„Działaj jako Senior Legal Counsel (Radca Prawny) specjalizujący się w prawie autorskim IT.

Kontekst: Jesteśmy Software Housem (Wykonawcą). Klient podesłał nam ten draft umowy.

Zadanie: Przeanalizuj poniższą umowę pod kątem Ryzyk dla Wykonawcy.

Szukaj konkretnie:

— Kar umownych, które są nielimitowane (szukaj braku górnego limitu odpowiedzialności).

— Klauzul o przeniesieniu praw autorskich przed zapłatą wynagrodzenia (to dla nas deal-breaker).

— Niejasnych terminów odbioru prac (ryzyko wiecznego poprawiania).

— Format: Tabela [Klauzula] | [Ryzyko] | [Sugerowana Poprawka].

— Jeśli nie znajdziesz ryzyk w tych obszarach, napisz wyraźnie „BRAK RYZYKA”. Nie zmyślaj.”

Wynik AI (Sukces):

Dostaniesz precyzyjny audyt prawny, który punktuje: „Art 5 ust 2 nie zawiera limitu kar — ryzyko bankructwa”.

To jest ta sama maszyna! Różnica leży w operatorze.

Technika Gumowej Kaczuszki (Rubber Duck Debugging)

Programiści znają metodę „tłumaczenia kodu gumowej kaczuszce”. Jeśli utknąłeś, opowiedz problem na głos.

W promptingu działa to świetnie jako Pre-Prompting.

Zanim wciśniesz Enter, zadaj sobie pytanie:

„Czy gdybym dał to polecenie stażyście, który przyszedł pierwszy dzień do pracy i nie zna firmy, to zrobiłby to dobrze?”

Jeśli odpowiedź brzmi „Nie”, to Twój prompt jest GIGO.

Pamiętaj: AI to najmądrzejszy, ale i najbardziej zagubiony stażysta, jakiego masz.

Bez mapy (Promptu) nigdzie nie dojdzie.

2. Sztuka Dekompozycji: Jak zjeść Słonia? (Pizza vs Słoń)

Najczęstszy błąd menedżera? Rzucanie w pracownika (i w AI) projektem-gigantem bez instrukcji.

„Stwórz mi strategię wejścia na rynek niemiecki.”

To jest Słoń.

Wielkie, ciężkie, niestrawne zadanie.

Teoria Obciążenia Poznawczego (Cognitive Load)

Dlaczego AI dławi się takim zadaniem?

Każdy model LLM ma limit Attention Window (Okna Uwagi). Jeśli zalejesz go zbyt szerokim pytaniem, jego uwaga się rozprasza.

Model „ślizga się” po powierzchni tematu, bo musi „zmieścić” odpowiedź w jednym przebiegu (single pass generation).

Efekt? Lista banałów: „Przetłumacz stronę”, „Zatrudnij handlowca”, „Zrób reklamy na Google”.

Dzięki, Sherlocku. Za to nie płacę.

Żeby zjeść słonia, trzeba go pokroić na kawałki. Na kawałki pizzy.

AI radzi sobie genialnie z mikro-zadaniami.

Framework 4D: Twoja Maszyna do Krojenia

Zamiast pisać jeden wielki prompt, zastosuj metodę 4D:

— DEFINE (Zdefiniuj): Co chcemy osiągnąć na końcu? (Strategia wejścia na rynek).

— DIVIDE (Podziel): Rozbij to na logiczne etapy.

— DO (Wykonaj): Promptuj każdy etap osobno.

— DEBRIEF (Złóż): Połącz wyniki w całość.

Case Study: Generowanie Kodu Python/SQL (Skomplikowane)

Wyobraź sobie, że chcesz skrypt, który pobiera dane z giełdy, liczy średnią kroczącą i wysyła alert na Slacka.

Prompt Słonia:

„Napisz mi skrypt w Pythonie do analizy giełdy z alertami na Slacka.”

Wynik AI:

Kod, który połowicznie działa, gubi importy, a funkcja Slacka jest zmyślona. Debugowanie tego zajmie Ci 2 godziny.

Proces 4D (Pizza):

Krok 1 (Dane):

„Napisz funkcję w Pythonie (get_stock_data), która pobiera ceny Apple z Yahoo Finance API. Zwróć tylko DataFrame pandas. Nie pisz reszty.”

Krok 2 (Analiza):

„Mam DataFrame z cenami. Napisz funkcję (calculate_sma), która dodaje kolumnę ze średnią kroczącą z 50 dni.”

Krok 3 (Alert):

„Napisz funkcję (send_slack_alert), która przyjmuje tekst i wysyła go na webhook Slacka. Użyj biblioteki requests.”

Krok 4 (Main):

„Teraz złóż te 3 funkcje w jeden skrypt main.py. Dodaj obsługę błędów (try/except).”

Widzisz różnicę?

Każdy kawałek kodu jest mały, testowalny i łatwy dla modelu. Prawdopodobieństwo błędu spada drastycznie.

Zbudowałeś skomplikowany system z klocków LEGO, zamiast próbować odlać go w całości z betonu.

Zasada: Jeśli prompt jest dłuższy niż 10 linijek — prawdopodobnie powinieneś go rozbić na dwa osobne.

Nie bój się rozmowy. Bój się monologu.

3. Model K-C-F-O-S: Ewolucja Standardu

Zapomnij o chaotycznym pisaniu. W profesjonalnym środowisku (Studio Grade / Enterprise) nie ma miejsca na „wydaje mi się”.

Stosuj model K-C-F-O-S.

To Twój nowy „SOP” (Procedura Operacyjna). Wydrukuj to i powieś nad biurkiem.

1. KONTEKST (Context)

Kim jesteś Ty? Kim ma być AI? Kto jest odbiorcą?

To jest ustawienie sceny. Bez tego AI jest aktorem bez scenariusza.

— Przykład: „Działaj jako Senior Prawnik Specjalista od RODO. Ja jestem właścicielem małego sklepu internetowego.”

2. CEL (Goal)

Co ma się wydarzyć? Jaki jest cel BIZNESOWY?

Nie pisz „napisz tekst”. Pisz „przekonaj klienta do zakupu”.

— Przykład: „Celem jest napisanie klauzuli informacyjnej, która jest zgodna z prawem, ale nie straszy klienta (User Friendly).”

3. FORMAT

W jakiej formie chcesz wynik?

Nie trać czasu na ręczne formatowanie w Wordzie. AI to zrobi.

— Przykład: „Wynik przedstaw jako tabelę Markdown z dwiema kolumnami: [Treść Prawna] i [Wyjaśnienie dla Ludzi — »po ludzku«]. Lub jako kod JSON.”

4. OGRANICZENIA (Constraints) — Kluczowe!

To jest ten element, o którym amatorzy zapominają. Musisz powiedzieć AI, czego NIE ROBIĆ (Negative Constraints).

AI ma tendencję do „lania wody” i bycia zbyt miłym. Musisz postawić bariery.

— Przykład:

— „Nie używaj słów: zważywszy na, niniejszym, iż.”

— „Maksymalna długość: 500 znaków (hard limit).”

— „Nie dawaj porad biznesowych, skup się TYLKO na prawie.”

— „Nie przepraszaj. Nie pisz „Jako model językowy…'.”

5. STYL (Style & Tone) — Nowy Element

Wersja podstawowa K-C-F-O nie uwzględniała tego, jak bardzo ton zmienia odbiór.

Ten sam tekst może brzmieć jak „Urząd Skarbowy” albo jak „Kumpel przy piwie”.

— Przykład: „Styl: Cyniczny, krótki, jak z filmu Noir. Używaj równoważników zdań.”

— Przykład: „Styl: Empatyczny terapeuta. Dużo pytań otwartych, ciepły ton.”

MASTER TEMPLATE (Kopiuj-Wklej):

### KONTEKST ###

Działaj jako [ROLA np. Senior Marketing Copywriter].

Piszesz dla [ODBIORCA np. Generacja Z].

### CEL ###

Twoim zadaniem jest [ZADANIE np. napisać post na LinkedIn].

Chcemy osiągnąć [EFEKT np. wywołać kontrowersję i dyskusję].

### FORMAT ###

Wynik w formacie [np. Lista punktowana z emoji].

### OGRANICZENIA ###

— Nie używaj korpo-mowy (ASAP, deadline).

— Długość: max 3 zdania na akapit.

— Nie używaj hashtagu #współpraca.

### STYL ###

[np. Prowokacyjny, odważny, bezpośredni].

Jeśli zastosujesz ten szablon, 90% Twoich problemów z „głupim AI” zniknie natychmiast.

To jak różnica między „Chcę obiad” a „Poproszę stek medium-rare z frytkami i sosem pieprzowym”.

Dostajesz to, co zamówiłeś.

4. Drabina Kompetencji: Zero-Shot vs Few-Shot (Małpa widzi, małpa robi)

Pamiętasz teorię? AI to statystyka.

Ale AI to też Mechanizm Uwagi (Attention Mechanism).

Oznacza to, że model „patrzy” na to, co mu podałeś, i próbuje zgadnąć ciąg dalszy.

Masz trzy poziomy wtajemniczenia:

1. Zero-Shot (Poziom Amatora)

Rzucasz zadanie bez przykładu.

„Napisz wiersz o kocie.”

Efekt? Losowy. Raz wyjdzie Mickiewicz, raz raper z gimnazjum.

2. One-Shot (Poziom Praktyka)

Dajesz JEDEN przykład, żeby ustawić celownik.

„Napisz wiersz o kocie.

Przykład stylu: „Litwo! Ojczyzno moja! ty jesteś jak zdrowie…”

Twój wiersz:”

Efekt? Model już wie, że ma być patetycznie i wzniośle.

3. Few-Shot (Poziom Mistrza / Elite)

Dajesz SERIĘ przykładów. To jest kalibracja broni snajperskiej.

Model widzi WZORZEC (Pattern) i go powiela.

Case Study: Transfer Stylu (Inżynier -> Poeta)

Chcesz, żeby AI pisało specyficzne opisy produktów.

Masz sklep z kawą dla hipsterów. Opisy muszą być pretensjonalne, dziwne, ale chwytliwe.

Prompt Zero-Shot:

„Opisz tę kawę: Etiopia Yirgacheffe, nuty jaśminu.”

Wynik AI:

„Ta wyśmienita kawa z Etiopii charakteryzuje się delikatnym aromatem jaśminu. Jest idealna na poranek.”

(Nuda. To pisał bot.)

Prompt Few-Shot:

„Jesteś copywriterem dla hipsterskiej palarni kawy. Twój styl to: metafora, synestezja, odrobinę arogancji.

Ucz się na moich przykładach:

Input: Brazylia Santos (orzech, czekolada)

Output: Ciemna jak listopadowa noc, gęsta jak smar w silniku twojego starego Volvo. Czekolada uderza cię w twarz, a orzech laskowy przeprasza, że żyjesz. Kawa dla ludzi, którzy nie słodzą.

Input: Kenia AA (porzeczka, kwasowość)

Output: Eksplozja w fabryce dżemu. Kwasowość wykręca mordę w uśmiechu Jokera. To nie jest napój, to sok z akumulatora, który smakuje jak dzieciństwo na działce u dziadka.

Zadanie (Input): Etiopia Yirgacheffe (jaśmin, bergamotka)

Output:”

Wynik AI (Geniusz):

„Herbatka u Królowej Anglii, która postanowiła zostać punkrockowcem. Jaśmin tańczy pogo z bergamotką. Delikatna jak policzek niemowlęcia, ale kopie jak prąd w gniazdku. Pijesz to i nagle rozumiesz poezję śpiewaną.”

Widzisz to?

Model „zrozumiał” (tak naprawdę: obliczył), że stylem jest agresywna metafora.

Bez przykładów (Few-Shot) nigdy byś tego nie uzyskał, nawet pisząc esej o stylu.

Pokaż, nie opisuj.

5. Separatory i Tagi XML: Standard Enterprise

Wyobraź sobie, że dajesz komuś książkę i piszesz instrukcję („Streść mi to”) długopisem gdzieś w środku rozdziału 3, między dialogami bohaterów.

Istnieje ryzyko, że czytelnik uzna Twoją instrukcję za część powieści i ją zignoruje.

To samo dzieje się z AI.

W profesjonalnych systemach (jak Claude czy GPT-4 API) używamy Tagów XML.

To są „znaczniki”, które mówią modelowi: „Tu się zaczyna, a tu kończy dany fragment”.

Dla modelu to jak znaki drogowe.

Struktura Modułowa (Separacja Danych)

Zamiast pisać ścianę tekstu, buduj prompt z klocków.

Amator:

„Przeanalizuj ten raport: [Tu wkleja 10 stron raportu] i wyciągnij wnioski.”

Pro:

„Jesteś analitykiem biznesowym. Przeanalizuj poniższe dane pod kątem spadku przychodów.

<kontekst>

Firma to e-commerce z odzieżą. Mamy Q4 2025.

</kontekst>

Kup książkę, aby przeczytać do końca.